尋夢新聞LINE@每日推播熱門推薦文章,趣聞不漏接❤️

作者黃樂平、何玫與楊俊傑

AI 晶片設計是人工智能產業鏈的重要一環。 自 2017 年 5 月以來,各 AI 晶片廠商的新品競相發布,經過一年多的發展,各環節分工逐漸明顯。 AI 晶片的應用場景不再局限於雲端,部署於智慧型手機、 安防錄影頭、及自動駕駛汽車等終端的各項產品日趨豐富。 除了追求性能提升外, AI 晶片也逐漸專注於特殊場景的優化。

自 2017 年 5 月以來發布的 AI 晶片一覽

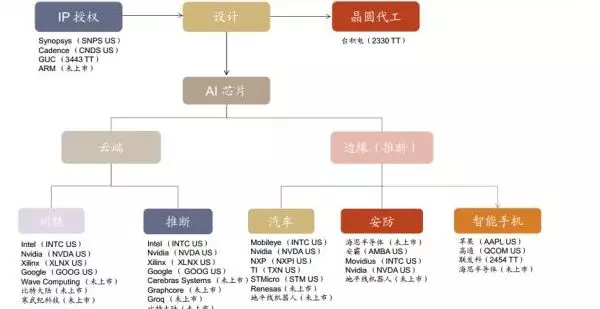

目前, 人工智能產業鏈中,包括提供 AI 加速核的 IP 授權商,各種 AI 晶片設計公司,以及晶圓代工企業。

► 按部署的位置來分, AI 晶片可以部署在數據中心(雲端),和手機,安防錄影頭,汽車等終端上。

► 按承擔的任務來分,可以被分為用於構建神經網路模型的訓練晶片,與利用神經網路模型進行推斷的推斷晶片。 訓練晶片注重絕對的計算能力,而推斷晶片更注重綜合指標, 單位能耗算力、時延、成本等都要考慮。

► 訓練晶片受算力約束,一般只在雲端部署。推斷晶片按照不同應用場景,分為手機邊緣推斷晶片、安防邊緣推斷晶片、自動駕駛邊緣推斷晶片。為方便起見,我們也稱它們為手機 AI 晶片、安防 AI 晶片和汽車 AI 晶片。

► 由於 AI晶片對單位能耗算力要求較高,一般採用 14nm/12nm/10nm等先進工藝生產。台積電目前和 Nvidia、 Xilinx 等多家晶片廠商展開合作,攻堅 7nm AI 晶片。

AI 晶片投資地圖

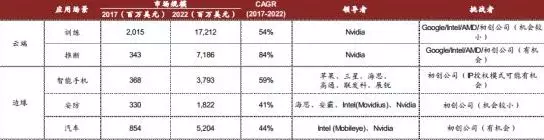

AI 晶片市場規模: 未來五年有接近 10 倍的增長, 2022 年將達到 352 億美元。根據我們對相關上市 AI 晶片公司的收入統計,及對 AI 在各場景中滲透率的估算, 2017年 AI 晶片市場規模已達到 39.1 億美元,具體情況如下:

► 2017 年全球數據中心 AI 晶片規模合計 23.6 億美元,其中雲端訓練晶片市場規模 20.2億美元,雲端推斷晶片 3.4 億美元。

► 2017 年全球手機 AI 晶片市場規模 3.7 億美元。

► 2017 年全球安防錄影頭 AI 晶片市場規模 3.3 億美元。

► 2017 年全球自動駕駛 AI 晶片的市場規模在 8.5 億美元。

AI 晶片市場規模及競爭格局

Nvidia 在 2017 年時指出,到 2020 年,全球雲端訓練晶片的市場規模將達到 110 億美元,而推斷晶片(雲端+邊緣) 的市場規模將達到 150 億美元。 Intel 在剛剛結束的 2018 DCI峰會上,也重申了數據業務驅動硬體市場增長的觀點。 Intel 將 2022 年與用於數據中心執行 AI 加速的 FPGA 的 TAM 預測,由 70 億美元調高至 80 億美元。

而同時我們也注意到:

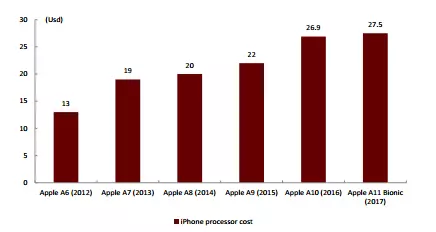

1)手機 SoC 價格不斷上升、 AI 向中端機型滲透都將為行業創造更廣闊的市場空間。

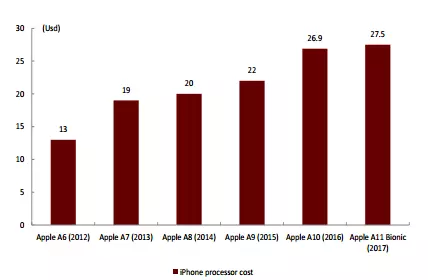

歷代 Apple 手機晶片成本趨勢

2)安防晶片受益於現有設備的智能化升級,晶片需求擴大。

自動駕駛算力需求加速晶片升級

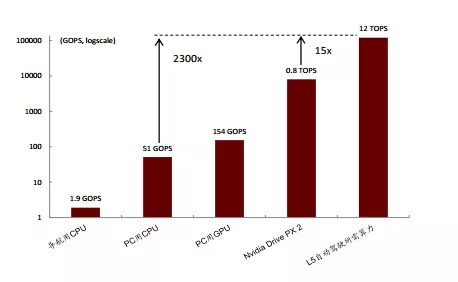

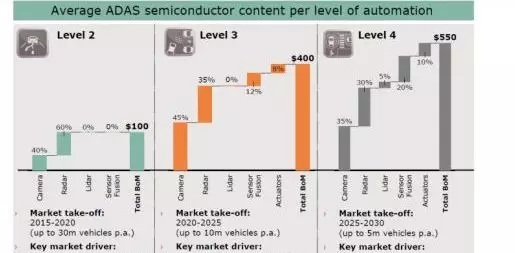

3)自動駕駛方面,針對豐田公司提出的算力需求,我們看到當下晶片算力與 L5 級自動駕駛還有較大差距。 英飛凌公司給出了各自動駕駛等級中的半導體價值預測, 可以為我們的 TAM 估算提供參考。

英飛凌對各自動駕駛等級中半導體價值的預測

結合以上觀點,及我們對 AI 在各應用場景下滲透率的分析,我們預測:

► 雲端訓練晶片市場規模在 2022 年將達到 172 億美元, CAGR~54%。

► 雲端推斷晶片市場規模在 2022 年將達到 72 億美元, CAGR~84%。

► 用於智慧型手機的邊緣推斷晶片市場規模 2022 年將達到 38 億美元, CAGR~59%。

► 用於安防錄影頭的邊緣推斷晶片市場規模 2022 年將達到 18 億美元, CAGR~41%。

► 用於自動駕駛汽車的邊緣推斷晶片市場規模 2022 年將達到 52 億美元, CAGR~44%。

雲端訓練晶片: TPU 很難撼動 Nvidia GPU 的壟斷地位

訓練是指通過大量的數據樣本,代入神經網路模型運算並反復迭代,來獲得各神經元「正確」權重參數的過程。 CPU 由於計算單元少,並行計算能力較弱,不適合直接執行訓練任務,因此訓練一般採用「CPU+加速晶片」的異構計算模式。目前 Nvidia 的 GPU+CUDA計算平台是最成熟的 AI 訓練方案,除此還有:

AI 晶片工作流程

► 第三方異構計算平台 OpenCL + AMD GPU 或 OpenCL+Intel/Xilinx 的 FPGA。

► 雲計算服務商自研加速晶片(如 Google 的 TPU) 這兩種方案。各晶片廠商基於不同方案,都推出了針對於雲端訓練的 AI 晶片。

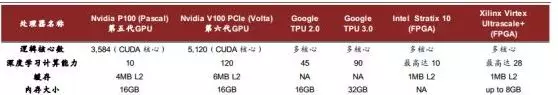

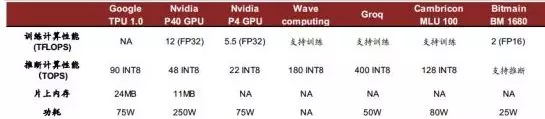

雲端訓練晶片對比

在 GPU 之外,雲端訓練的新入競爭者是 TPU。 Google 在去年正式發布了其 TPU 晶片,並在二代產品中開始提供對訓練的支持,但比較下來, GPU 仍然擁有最強大的帶寬(900GB/s,保證數據吞吐量)和極高的深度學習計算能力(120 TFLOPS vs. TPUv2 45 TFLOPS),在功耗上也並沒有太大劣勢(TPU 進行訓練時,引入浮點數計算,需要逾 200W 的功耗,遠不及推斷操作節能)。目前 TPU 只提供按時長付費使用的方式,並不對外直接銷售,市占率暫時也難以和 Nvidia GPU 匹敵。

► Intel

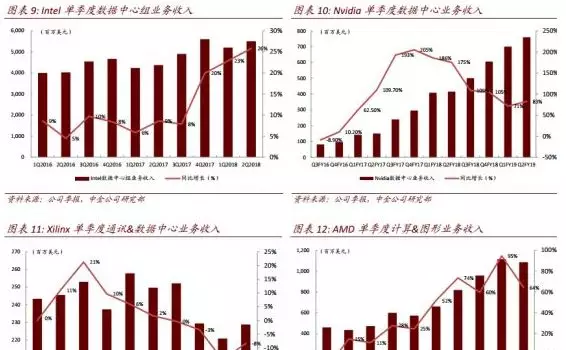

雖然深度學習任務主要由 GPU 承擔,但 CPU 目前仍是雲計算晶片的主體。 Intel 於 2015年底年收購全球第二大 FPGA 廠商 Altera 以後,也積極布局 CPU+FPGA 異構計算助力 AI,並持續優化 Xeon CPU 結構。 2017 年 Intel 發布了用於 Xeon 服務器的,新一代標準化的加速卡,使用戶可以 AI 領域進行定制計算加速。得益於龐大的雲計算市場支撐, Intel 數據中心組業務收入規模一直位於全球首位, 2016-17 年單季保持同比中高個位數增長。 2017年 4 季度起,收入同比增速開始爬坡至 20%左右,但相比 Nvidia 的強勁增長態勢仍有差距。

► AMD

AMD 雖未單獨拆分數據中心收入,但從其計算和圖像業務的收入增長情況來看, GPU 銷量向好。目前 AMD GPU 也開始切入深度學習訓練任務,但市場規模落後於 Nvidia。

雲端推斷晶片:百家爭鳴,各有千秋

推斷是指借助現有神經網路模型進行運算, 利用新的輸入數據來一次性獲得正確結論的過程。 推斷過程對響應速度一般有較高要求, 因此會採用 AI 晶片(搭載訓練完成的神經網路模型)進行加速。

相比訓練晶片,推斷晶片考慮的因素更加綜合:單位功耗算力,時延,成本等等。初期推斷也採用 GPU 進行加速,但由於應用場景的特殊性,依據具體神經網路算法優化會帶來更高的效率, FPGA/ASIC 的表現可能更突出。除了 Nvidia、 Google、 Xilinx、 Altera(Intel)等傳統晶片大廠涉足雲端推斷晶片以外, Wave computing、 Groq 等初創公司也加入競爭。中國公司裡,寒武紀、比特大陸同樣積極布局雲端晶片業務。

主要雲端推斷晶片對比

我們認為, 雲端推斷晶片在未來會呈現百花齊放的態勢。 具體情況如下:

► Nvidia

在雲端推斷晶片領域, Nvidia 主打產品為 P40 和 P4, 二者均採用 TSMC 16nm 制程。 TeslaP4 擁有 2560 個流處理器,每秒可進行 22 萬億次(TOPS) 計算(對應 INT 8)。而性能更強的 Tesla P40 擁有 3840 個流處理器,每秒可進行 47 萬億次(TOPS)計算(對應 INT 8)。從單位功耗推斷能力來看, P4/P40 雖然有進步,但仍遜於 TPU。 GPU 在推斷上的優勢是帶寬。

Google TPU 1.0 為雲端推斷而生,其運算單元對神經網路中的乘加運算進行了優化,並採用整數運算。 TPU 1.0 單位功耗算力在量產雲端推端晶片中最強,達 1.2TOPS/Watt,優於主流 Nvidia GPU。 TPU 2.0 在推斷表現上相比於 1 代並沒有本質提升,主要進步是引入對浮點數運算的支持,及更高的片上記憶體。正如前文所述,支持訓練的 TPU 功耗也會變得更高。

► Wave Computing

Wave computing 於 2010 年 12 月成立於加州,目前累計融資 1.2 億美元,是專注於雲端深度學習訓練和推理的初創公司。Wave computing 的一代 DPU 深度學習算力達 180 TOPS,且無需 CPU 來管理工作流。目前公司正與 Broadcomm 合作在開發二代晶片,將採用 7nm制程。

► Groq

Groq 是由 Google TPU 初始團隊離職創建的 AI 晶片公司,計劃在 2018 年發布第一代 AI晶片產品,對標英偉達的 GPU。其算力可達 400 TOPs(INT 8),單位能耗效率表現搶眼。

► 寒武紀科技

寒武紀在 2017 年 11 月發布雲端晶片 MLU 100,同時支持訓練和推斷,但更側重於推斷。MLU 100 在 80W 的功耗下就可以達到 128 TOPS(對應 INT 8)的運算能力。

► 比特大陸

比特大陸的計算晶片 BM 1680,集成了深度學習算法硬體加速模塊(NPUs),應用於雲端計算與推理。 BM1680 還提供了 4 個獨立的 DDR4 通道,用於高速數據緩存讀取,以提高系統的執行速度。其典型功耗只有 25W,在單位能耗推斷效率上有一定優勢。

應用場景#1:雲端推斷晶片助力智能語音識別

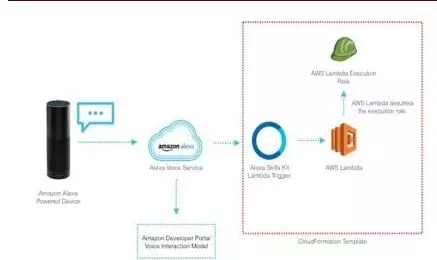

雲端推斷晶片提升語音識別速度。 語音識別是推斷晶片的工作場景之一,如 Amazon 的語音助手 Alexa,其「智能」來自於 AWS 雲中的推斷晶片。 Alexa 是預裝在亞馬遜 Echo內的個人虛擬助手,可以接收及相應語音命令。通過將語音數據上傳到雲端,輸入推斷晶片進行計算,再返回結果至本地來達到與人做到交互的目的。原先雲端採用 CPU 進行推斷工作,由於算力低,識別中會有 300-400ms 的延遲,影響用戶體驗。

智能音箱通過雲端推斷晶片工作

而現今 AWS 雲中採用了 Nvidia 的 P40 推斷晶片,結合 Tensor RT 高性能神經網路推理引擎(一個 C++庫),可以將延遲縮減到 7ms。 此外, AI 晶片支持深度學習,降低了語音識別錯誤率。 目前, 借助雲端晶片的良好推斷能力,百度語音助手的語音識別準確度已達到 97%之高。

Nvidia 雲端推斷晶片提升語音識別速度

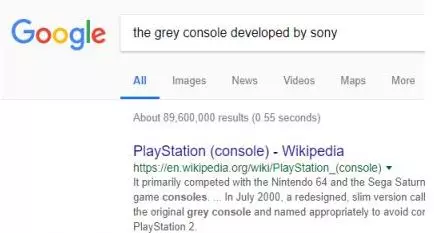

應用場景#2:推斷晶片應用於智能搜索

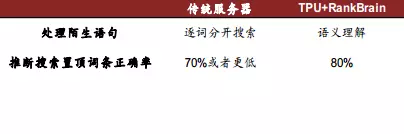

RankBrain 是 Google 眾多搜索算法的一部分,它是一套計算機程序,能把知識庫中上十億個頁面進行排序,然後找到與特定查詢最相關的結果。 目前, Google 每天要處理 30 億條搜索,而其中 15%的詞語是 Google 沒有見過的。 RankBrain 可以觀察到看似無關複雜搜索之間的模式,並理解它們實際上是如何彼此關聯的, 做到了對輸入的語義理解。 這種能力離不開 Google 雲端推斷晶片 TPU 的輔助。

推斷晶片助力深度學習做到語義識別

先前,在沒有深度學習情況下,單純依靠 PageRanking 及 InvertedIndex, Google 也能做到一定程度的對搜索詞條排序的優化,但準確率不夠。 TPU 利用 RankBrain 中的深度學習模型,在 80%的情況下計算出的置頂詞條,均是人們最想要的結果。

TPU+RankBrain 在推斷正確率上獲得提高

用於智慧型手機的邊緣推斷晶片:競爭格局穩定,傳統廠商持續受益

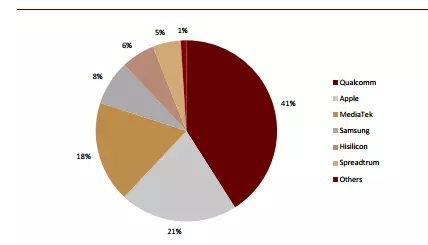

手機晶片市場目前包括:(1)蘋果,三星,華為這類採用晶片+整機垂直商業模式的廠商,以及(2)高通,聯發科,展銳等獨立晶片供應商和(3) ARM, Synopsys、 Cadence 等向晶片企業提供獨立 IP 授權的供應商。 採用垂直商業模式廠商的晶片不對外發售,只服務於自身品牌的整機,性能針對自身軟體做出了特殊優化,靠效率取勝。獨立晶片供應商以相對更強的性能指標,來獲得剩餘廠商的市場份額。

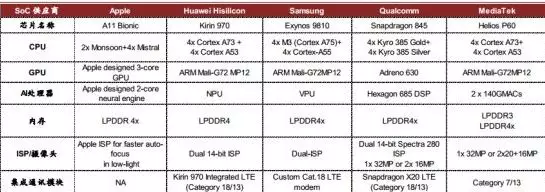

從 2017 年開始,蘋果,華為海思,高通,聯發科等主要晶片廠商相繼發布支持 AI 加速功能的新一代晶片(如下圖), AI 晶片逐漸向中端產品滲透。由於手機空間有限, 獨立的AI 晶片很難被手機廠採用。在 AI 加速晶片設計能力上有先發優勢的企業(如寒武紀)一般通過 IP 授權的方式切入。

手機 AI 晶片對比

對這些廠商來說,我們認為 AI 化的主要作用是提升晶片附加價值與產品單價。根據 IHS的數據,隨著硬體性能的增強及針對於 AI 的運算結構不斷滲透,蘋果 A11 晶片的成本已達到 27.5 美元。

智慧型手機 SoC 市占率分析(2017)

晶片成本持續上漲有望帶動垂直模式廠商整機售價走高,在出貨量相同的情況下為現有晶片廠商貢獻更多的營業收入。高通、聯發科、展銳等獨立晶片供應商則會受益於晶片本身 ASP 的提升。

歷代 Apple 手機晶片成本趨勢

應用場景#1:推斷晶片為 AI 拍照技術提供硬體支持

智慧型手機通過 AI 算法+終端推斷晶片,可做到對於現實世界圖像的智能識別,並在此基礎上進行實時優化:

1)從整個場景識別,到特殊優化過程中,推斷晶片為算法運行提供硬體支持。

2)手機推斷晶片中 GPU、 NPU 等單元的協同工作,做到了對邊緣虛化更準確的處理,使小尺寸感光元件的手機獲得「單反」 級的景深效果,增加相片的層次感。

3)人臉結構的識別也離不開邊緣推斷晶片,晶片性能的提升直接導致了 AI 美顏、 3D 光效等特殊效果變得更加自然。 如果缺少終端晶片的支持,一旦運行高負載的 AI 任務手機就需要呼喚雲端。而雲端的相應速度不夠,導致 AI 攝影的識別率和準確率下降,用戶體驗將大打折扣。

手機 AI 晶片輔助圖片渲染優化

應用場景#2:推斷晶片助力語音助手處理複雜命令

從「聽清」到「聽懂」,自然語言理解能力提升與推斷晶片硬體的支持分不開:多麥克風方案的普及解決了「聽清」的問題,而到「聽懂」的跨越中自然語言理解能力是關鍵。這不僅對雲端訓練好的模型質量有很高要求,也必須用到推斷晶片大量的計算。隨著對話式 AI 算法的發展,手機 AI 晶片性能的提升,語音助手在識別語音模式、分辨模糊語音、剔除環境噪聲干擾等方面能力得到了優化,可以接受理解更加複雜的語音命令。

手機 AI 晶片輔助 Vivo Jovi 處理複雜命令

用於安防邊緣推斷晶片: 海思、安霸與 Nvidia、 Mobileye 形成有力競爭

視頻監控行業在過去十幾年主要經歷了「高清化」、「網路化」的兩次換代,而隨著 2016年以來 AI 在視頻分析領域的突破,目前視頻監控行業正處於第三次重要升級周期——「智能化」的開始階段。 前端錄影頭裝備終端推斷晶片,可以實時對視頻數據進行結構化處理,「雲+邊緣」的邊緣計算解決方案逐漸滲透。 我們預計, 應用安防錄影頭的推斷晶片市場規模,將從 2017 年的 3.3 億美元,增長至 2022 年的 18 億美元, CAGR~41%。

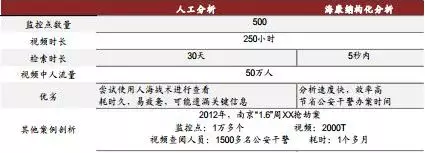

應用場景:安防邊緣推斷晶片做到結構化數據提取,減輕雲端壓力

即便採用 H.265 編碼,目前每日從錄影機傳輸到雲端的數據也在 20G 左右,不僅給存儲造成了很大的壓力,也增加了數據的傳輸時間。 邊緣推斷晶片在安防端的主要應用,基於將視頻流在本地轉化為結構化數據。 這樣既節省雲端存儲空間, 也提升系統工作效率。「視頻結構化」,簡言之即從視頻中結構化提取關鍵目標,包括車輛、人及其特徵等。雖然這種對數據的有效壓縮要通過算法做到,但硬體的支持不可或缺。

視頻結構化數據提取實例

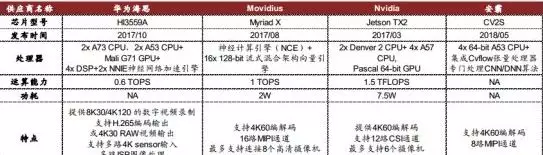

根據海康威視提供傳統視頻解碼晶片廠商積極布局 AI 升級。 華為海思、安霸(Ambarella)都在近一年內推出了支持 AI 的安防邊緣推斷晶片。海思的 HI3559A 配備了雙核神經網路加速引擎,並成為第一款支持 8k 視頻的晶片;安霸也通過集成 Cvflows 張量處理器到最新的 CV2S 晶片中,以做到對 CNN/DNN 算法的支持。

AI 晶片助力結構化分析做到工作效率提升

打入視頻監控解決方案龍頭海康威視,做到前裝的 Nvidia,Movidius 同樣不甘示弱, Movidius 發布的最新產品 Myriad X 搭載神經計算引擎,在 2W的功耗下可做到 1TOPS 的算力。Nvidia TX2 是 TX1 的升級產品,算力更強,達到 1.5TFLOPS,存儲能力也有提升。

安防 AI 晶片對比

我們認為,目前整個安防 AI 晶片市場競爭格局穩定,現有廠商憑借與下遊客戶長期的合作,有望繼續受益於安防智能化的升級,屬於新進入者的市場空間有限。 安防 AI 晶片下遊客戶穩定,為海康威視、大華股份等視頻監控解決方案提供商。客戶與傳統視頻解碼晶片廠商的長期合作具有黏性,同樣推出新產品,初創公司的競爭優勢弱一些,尤其是在安防 AI 晶片性能差異化很難做到很大的情況下。

用於自動駕駛的邊緣推斷晶片:一片藍海,新競爭者有望突圍

除了智慧型手機, 安防外, 自動駕駛汽車也是人工智能的落地場景之一。 車用半導體強大需求已經使供給端產能開始吃緊,而用於自動駕駛的推斷晶片需求,同樣有望在未來 5年內做到高速增長。我們預計,其市場規模將從 2017 年的 8.5 億美元,增長至 2022 年的 52 億美元,CAGR~44%。若想使車輛做到真正的自動駕駛,要經歷在感知-建模-決策三個階段,每個階段都離不開終端推斷晶片的計算。

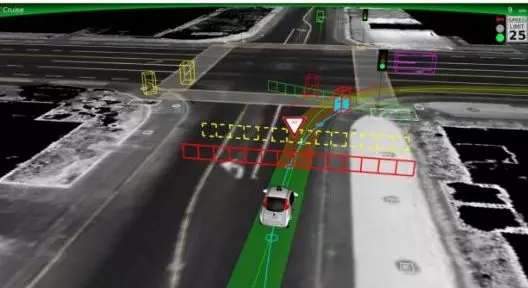

應用場景#1:自動駕駛晶片助力環境感知

在車輛感知周圍環境的過程中,融合各路傳感器的數據並進行分析是一項艱巨的工作,推斷晶片在其中起到了關鍵性作用。 我們首先要對各路獲得的「圖像」數據進行分類,在此基礎之上,以包圍盒的(bounding box) 形式辨別出圖像中的目標具體在什麼位置。

但這並不能滿足需求:車輛必須要辨別目標到底是其他車輛,是標誌物,是信號燈,還是人等等,因為不同目標的行為方式各異,其位置、狀態變化,會影響到車輛最終的決策,因而我們要對圖像進行語義分割(segmantation,自動駕駛的核心算法技術)。語義分割的快慢和推斷晶片計算能力直接相關,時延大的晶片很顯然存在安全隱患,不符合自動駕駛的要求。

自動駕駛推斷晶片+算法做到視頻的像素級語義分割

應用場景#2:自動駕駛晶片助力避障規劃

避障規劃是車輛主要探測障礙物, 並對障礙物的移動軌跡跟蹤(Moving object detection and tracking,即 MODAT)做出下一步可能位臵的推算,最終繪制出一幅含有現存、及潛在風險障礙物地圖的行為。出於安全的要求,這個風險提示的時延應該被控制在 50ms級。

隨著車速越來越快,無人車可行駛的路況越來越複雜,該數值在未來需要進一步縮短,對算法效率及推斷晶片的算力都是極大的挑戰。 例如,在複雜的城區路況下,所需算力可能超過 30TOPS。未來 V2X 地圖的加入,將基本上確保了無人車的主動安全性,但同樣對推斷晶片的性能提出了更高的要求。

自動駕駛推斷晶片+算法做到自動駕駛避障規劃

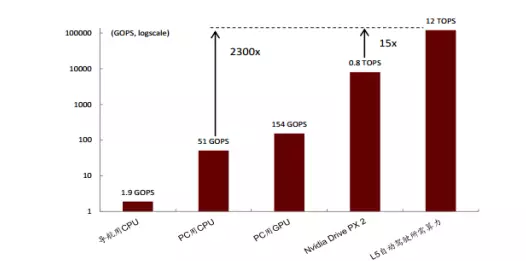

從以上應用場景不難看出, 自動駕駛對晶片算力提出了很高的要求, 而受限於時延及可靠性,有關自動駕駛的計算不能在雲端進行,因此邊緣推斷晶片升級勢在必行。根據豐田公司的統計數據,做到 L5 級完全自動駕駛,至少需要 12TOPS 的推斷算力,按現行先進的 Nvidia PX2 自動駕駛平台測算,差不多需要 15 塊 PX2 車載計算機,才能滿足完全自動駕駛的需求。

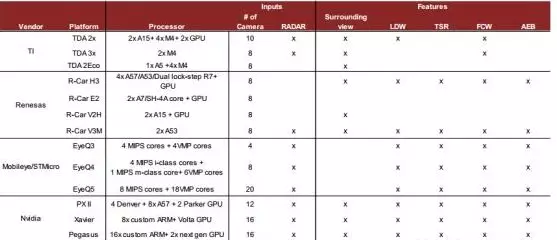

自動駕駛算力需求加速晶片升級

傳統車載半導體廠商積極布局自動駕駛。 近些年來,各傳統車載半導體供應商紛紛涉獵自動駕駛業務,推出了各自的自動駕駛,或輔助駕駛平台,如 TI 推出了面向於 L1/2 級的平價產品,而 Renesas 和 NXP 步入中高端市場。 V3M 與 Bluebox 分別是兩家的代表性產品,均滿足客戶 L3 級自動駕駛需求。目前 NXP 的 Bluebox 2.0 也在測試中。

老牌廠商中Mobileye(被 Intel 收購) 在自動駕駛邊緣推斷晶片上表現最為搶眼,其 EyeQ3 晶片已經被集成於新一代量產 Audi A8 中的 zFAS 平台上,而 A8 也因此成為第一款支持 L3 級自動駕駛的車型。

下一代產品中, Mobileye 和新秀 Nvidia 有望做到領先。 Mobileye 更注重算法端, 強調軟硬體結合帶來的效率提升,其開發的最新 EyeQ5 晶片在 10W 的功耗下就能達到 24TOPS的算力。 英偉達作為傳統硬體廠商,借助於 GPU 圖形處理的優勢,也在自動駕駛市場取得了相應的領先地位,其晶片更注重絕對算力表現。將於今年三季度流片, 2019 年三季度量產的「算力怪獸」 Pegasus 平台,搭載了兩塊 Nvidia 下一代的 GPU,將做到 320TOPS的超強計算能力,完全覆蓋 L5 級別應用的需求。

自動駕駛平台對比

對比其他終端應用場景,自動駕駛不僅計算複雜程度最高,車規級要求也為晶片設立了更高的準入門檻, 其硬體升級落地相對緩慢。 目前各廠商下一代的自動駕駛平台最早計劃於 2019 年量產,現今上市平台中,晶片大多只支持 L2/3 級。之前 Uber 的無人車事故,也對整個行業的發展造成了拖累。

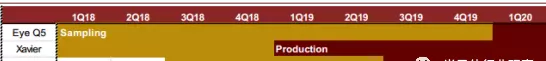

下一代自動駕駛 AI 晶片流片及投產時間預估

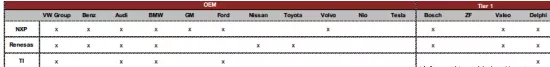

自動駕駛晶片市場仍處於初期起步階段。 雖然 NXP 等傳統半導體廠商深耕於汽車電子多年,獲得了一定的客戶黏性,但在自動駕駛業務上,整個市場還未形成非常明顯的競爭格局。客戶也在不斷測試晶片廠商的產品,來做到最優選擇。根據各公司披露的數據,目前各大晶片廠商與整車廠(OEM)及 Tier 1 廠商都開展了緊密的合作,但客戶數量不相上下。

從客戶的偏好來看,傳統大廠願意自行搭建平台, 再採購所需晶片,而新車廠偏向於直接購買自動駕駛平台。 介於做到完全自動駕駛非常複雜,目前還在起步階段,我們認為初創公司在整個行業的發展中是有機會的,並看好技術領先,能與車廠達成密切合作的初創公司。

各晶片廠商合作方比較

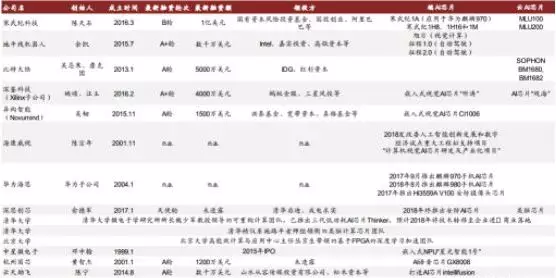

主要中國 AI 晶片公司介紹

中國大陸目前有超 20 家企業投入 AI 晶片的研發中來。 除了像華為海思、紫光展銳這種深耕於晶片設計多年的企業之外,也有不少初創公司表現搶眼,如寒武紀、比特大陸等。此外,台灣地區的 GUC(創意電子)是一家 IC 後端設計公司,憑借 20 年的行業經驗,和投資方晶圓製造巨頭台積電的鼎力支持,在 AI 晶片高速發展的大環境下也有望受益。

中國大陸主要 AI 晶片設計公司至少有 20 家

以下企業值得關注:

海思半導體(Hisilicon)

海思半導體成立於 2004 年 10 月,是華為集團的全資子公司。海思的晶片產品覆蓋無線網路、固網及數字媒體等多個領域,其 AI 晶片為 Kirin 970 手機 SoC 及安防晶片 Hi3559A V100。 Kirin 970 集成 NPU 神經處理單元,是全球第一款手機 AI 晶片, 它在處理靜態神經網路模型方面有得天獨厚的優勢。而 Hi3559A V100 是一款性能領先的支持 8k 視頻的 AI晶片。

清華紫光展銳 (Tsinghua UNISOC)

清華紫光集團於 2013 年、 2014 年先後完成對展訊及銳迪科微電子的收購, 2016 年再將二者合併,成立紫光展銳。紫光展銳是全球第三大手機基帶晶片設計公司,是中國領先的 5G 通信晶片企業。 Gartner 的數據顯示,紫光展銳手機基帶晶片 2017 年出貨量的全球占比為 11%。除此之外,展銳還擁有手機 AI 晶片業務,推出了採用 8 核 ARM A55 處理器的人工智能 SoC 晶片 SC9863,支持基於深度神經網路的人臉識別技術, AI 處理能力比上一代提升 6 倍。

GUC(台灣創意電子, 3443 TT)

公司介紹: GUC 是彈性客制化 IC 主管廠商(The Flexible ASIC LeaderTM),主要從事 IC 後端設計。後端設計工作以布局布線為起點,以生成可以送交晶圓廠進行流片的 GDS2 文件為終點,需要很多的經驗,是晶片做到流片的重要一環。初創公司同時完成前後端設計難度較大。在 AI 晶片設計發展的大環境下,加上大股東台積電的支持, GUC 有望獲得大的後端訂單。 公司已在台灣證券交易所掛牌上市,股票代號為 3443。

以下為初創公司:

寒武紀科技(Cambricon Technologies)

寒武紀創立於 2016 年 3 月,是中科院孵化的高科技企業,主要投資人為國投創業和阿里巴巴等。公司產品分為終端 AI 晶片及雲端 AI 晶片。終端 AI 晶片採用 IP 授權模式,其產品 Cambricon-1A 是全球首個做到商用的深度學習處理器 IP。去年年底公司新發布了第三代機器學習專用 IP Cambricon-1M,採用 7nm 工藝,性能差不多高出 1A 達 10 倍。雲端產品上,寒武紀開發了 MLU 100 AI 晶片,支持訓練和推斷,單位功耗算力表現突出。

比特大陸(Bitmain)

比特大陸成立於 2013 年 10 月, 是全球第一大比特幣礦機公司,目前占領了全球比特幣礦機 60%以上的市場。由於 AI 行業發展迅速及公司發展需要,公司將業務拓展至 AI 領域,並於與 2017 年推出雲端 AI 晶片 BM1680,支持訓練和推斷。目前公司已推出第二代產品BM1682,相較上一代性能提升 5 倍以上。

地平線機器人(Horizon Robotics)

成立於 2015 年 7 月,地平線是一家注重軟硬體結合的 AI 初創公司,由 Intel、嘉實資本、高瓴資本領投。公司主攻安防和自動駕駛兩個應用場景,產品為征程 1.0 晶片(支持 L2自動駕駛)和旭日 1.0(用於安防智能錄影頭),具有高性能(實時處理 1080P@30 幀,並對每幀中的 200 個目標進行檢測、跟蹤、識別)、低功耗(典型功耗在 1.5W)、和低延遲的優勢(延遲小於 30 毫秒)。公司二代自動駕駛晶片將於 1Q19 流片,做到語義建模。

雲天勵飛(Intellifusion)

公司創立於 2014 年 8 月,由山水從容傳媒、松禾資本領投,主攻安防 AI 晶片。其自研IPU 晶片是低功耗的深度學習專用處理器,內含專用圖像處理加速引擎,通過級聯擴展最多可處理 64 路視頻。能耗比突出,超過 2Tops/Watt。

異構智能(NovuMind)

異構智能創立於 2015 年 8 月,由洪泰基金、寬帶資本、真格基金和英諾天使投資。 2018年公司展示了其首款雲端 AI 晶片 NovuTensor,基於 FPGA 做到,性能已達到目前最先進的桌面服務器 GPU 的一半以上,而耗電量僅有 1/20。公司即將推出的第二款 ASIC 晶片,能耗不超 5W, 計算性能達 15 TOPs,將被用於安防和自動駕駛應用中。

龍加智(Dinoplus)

創立於 2017 年 7 月龍加智是專注於雲端晶片的 AI 初創公司,由摯信資本和翊翎資本領投。其產品 Dino-TPU 在 75W 功耗下,計算能力超過除最新款 Nvidia Volta 之外的所有 GPU,時延僅為 Volta V100 的 1/10。同時, Dino-TPU 提供市場上獨一無二的冗餘備份和數據安全保障。 公司計劃於 2018 年底完成第一款晶片的流片。

請加微信公眾號:工業智能化(robotinfo) 馬雲都在關注