尋夢新聞LINE@每日推播熱門推薦文章,趣聞不漏接❤️

摘要:在本文中,我們介紹了一種培訓生成對抗性網路(GAN)的新模式。我們不是最小化證據分布p~(x)和生成分布q(x)的距離,而是使p~(xr)q(xf)和p~(xf)q(xr)的距離最小化。這種對抗模式可以解釋為GAN中的圖靈測試。它允許我們在訓練生成器期間使用真實樣本的信息並加速整個訓練過程。我們甚至發現只需按比例增加鑒別器和發生器的大小,它就可以在256×256分辨率下成功,而無需仔細調整超參數。

1.3Problems

GAN取得了巨大的成功,但仍有一些問題有待解決。不同的是,GAN的訓練在大規模數據集上將非常不穩定,例如256×256圖像和更高。簡單地增加鑒別器和發生器的大小總是無法做到這一目標。它總是需要某些技巧和精心設計的超參數用於鑒別器和發生器,甚至需要大量的計算資源(Karras等,2017; Brock等,2018; Peng等,2018)。

2新GAN模式

SGAN和WGAN之間有兩個共同點:1。它們都試圖最小化p~(x)和q(x)之間的一種分布距離; 2.在更 新髮生器時,只有來自生成分布的假樣本可用。因此,生成器的更新取決於鑒別器是否能夠記住實際樣本的特徵。換句話說,發電機只是通過鑒別器的存儲器來改善其產量,不直接使用實際樣品的信號。鑒別器可能太難以降低發電機的收斂速度。在這里,我們演示了一種新的GAN模式:最小化p~(xr)q(xf)和p~(xf)q(xr)的距離。這個想法可以在更 新髮生器時使真實圖像可用,並且可以集成到所有當前的GAN中。培養所有生成模型而不是一個特定的GAN是一種新的思路。

2.3與圖靈測試有關

對於最小化p~(xr)q(xf)和p~(xf)q(xr)的距離存在非常直觀的解釋:圖靈測試(圖靈,1995)。眾所周知,圖靈測試是對機器表現出與人類相當或無法區分的智能行為的能力的測試。測試儀在不可預測的情況下與機器人和人進行通信。如果測試人員無法將人與機器人區分開來,我們可以說機器人(在某些方面)具有人類智能。

在GAN中怎麼樣?如果我們從真實分布p~(xr)和xf從假分布q(xf)中抽取xr,然後混合它們。我們能確定它們的來源嗎?也就是說,p~(xr)q(xf)和p~(xf)q(xr)之間的差異有多大?一個好的生成器意味著我們到處都有p~(x)q(x),所以我們無法區分p~(xr)q(xf)和p~(xf)q(xr),(xr,xf)和(xf,xr)。

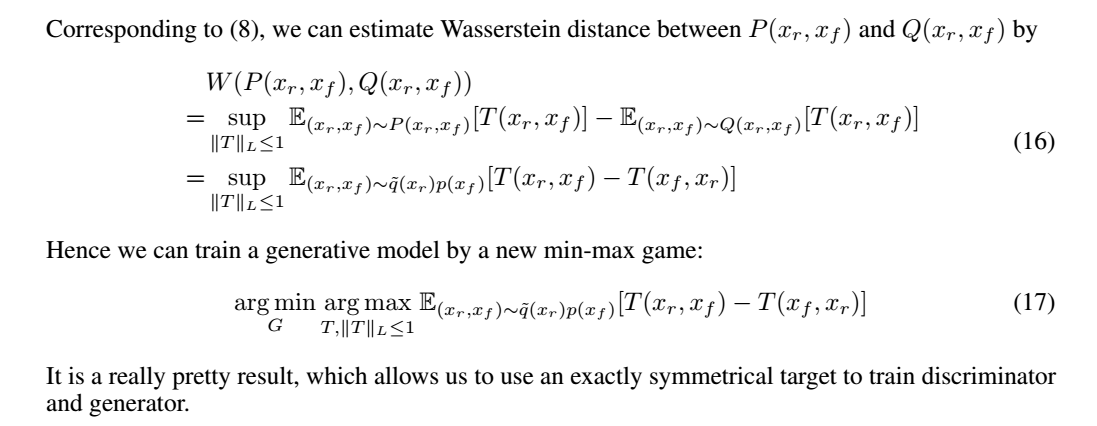

因此,最小化p~(xr)q(xf)和p~(xf)q(xr)的距離就像GAN中的圖靈測試一樣。我們將實際樣本和假樣本混合,使得鑒別器必須通過成對比較來區分它們,並且生成器必須通過成對比較來改進自身。我們將此模式中的GAN稱為Turing GAN(T-GAN),相應地,(14)稱為T-SGAN,(17)稱為T-WGAN。

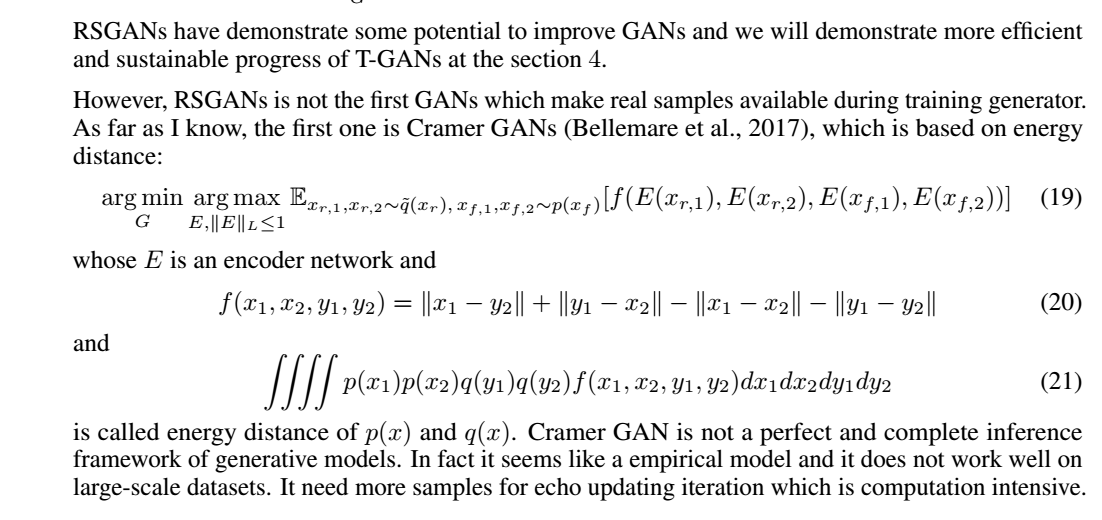

3相關作品

(14)和(17)都允許優化器直接獲得實際樣本的信號以更 新髮生器。形式上,與SGAN和WGAN相比,T-GAN的鑒別器是雙變量函數,需要實數和假樣本作為輸入。這意味著鑒別器需要成對比較才能做出合理的判斷。

4Experiments

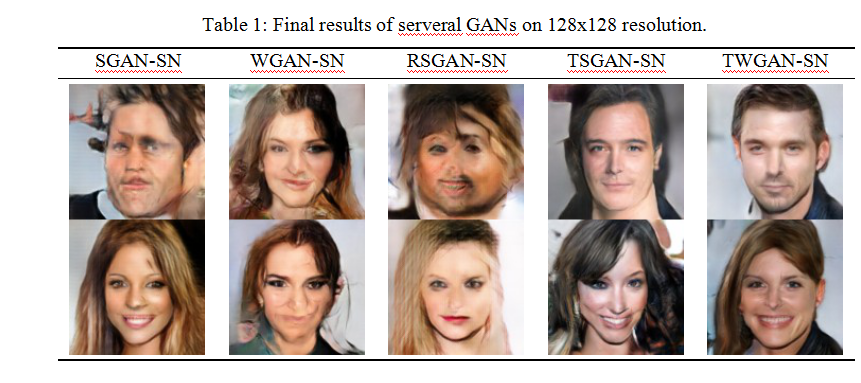

我們的實驗在CelebA HQ數據集(Liu et al。,2015)和cifar10數據集(Krizhevsky&Hinton,2009)上進行。我們在CelebA HQ上測試了64×64,128×128和256×256分辨率的(14)和(17)。 cifar10是一個額外的輔助實驗,用於證明T-GAN比當前的GAN更好地工作。代碼是用Keras編寫的(Chollet等,2015),可以在我的repository1中找到。從DCGAN修改了模型的體系結構(Radford等,2015)。使用Adam優化器(Kingma&Ba,2014)訓練模型,學習率為0.0002,動量為0.5。在GTX 1060上運行64×64和128×128分辨率的實驗,並在GTX 1080Ti上運行256×256分辨率的實驗。

4.1鑒別者的設計

理論上,任何具有雙輸入xr,xf的神經網路都可以用作T(xr,xf)。但為簡單起見,受RSGAN的啟發,我們將T(xr,xf)設計為以下形式:其中E()是輸入圖像的編碼器,D()是多層感知,隱藏差分向量為E(xr),E(xf)為輸入,標量為輸出。它也可以被視為比較xr和xf隱藏特徵的相對論判別器,而不是比較RSGAN中的最終標量輸出。如果我們使用T-SGAN(14),理論上對T沒有約束。但正如我們所知,梯度消失通常發生在SGAN中,光譜歸一化是預防它的有效策略。因此,無論SGAN還是WGAN,頻譜歸一化都是一種流行的識別器技術,T-SGAN和T-WGAN也是如此。我們的實驗證明(14)和(17)具有相似的性能,而光譜歸一化應用於它們的鑒別器T(xr,xf)。

4.2結果分析

在64×64分辨率的實驗中,我們發現T-SGAN和T-WGAN具有比流行的GAN更快的收斂速度,例如DCGAN,DCGAN-SN,WGAN-GP,WGAN-SN,RSGAN。

在128×128分辨率下,我們找到了最受歡迎的GAN不起作用或只能在非常特殊的超參數和收斂下工作,但是T-GAN仍然運行良好並且具有與64×64分辨率相同的收斂速度。我們甚至發現只是按比例增加鑒別器和發生器的大小,它在256×256上成功解析度。非常不可思議的是,在高分辨率下訓練生成對抗模型不需要在T-GAN框架下仔細調整超參數.4.2.1更快的收斂速度圖1顯示了不同GAN的收斂速度的比較。所有這些GAN都具有相同的鑒別器和發生器架構。它們實際上具有相同的最終性能但收斂速度不同。我們發現T-SGAN和T-WGAN的收斂速度幾乎是其他GAN的兩倍。其他GAN需要大約20k次迭代才能達到與T-GAN在10k迭代中相同的性能。需要指出的是,WGAN-GP似乎具有與T-GAN類似的性能,但實際上它需要更多的時間進行回聲迭代。在回聲迭代期間,我們更新鑒別器5次並在訓練WGAN-GP和WGAN-SN時更 新髮生器1次,但更新鑒別器1次並在訓練其他GAN(包括T-SGAN和T-WGAN)的同時更 新髮生器2次。實驗關於cifar10還進一步證明了這一結論(圖2).4.2.2高質量生成現在我們將關注高質量的生成。在128×128分辨率下,我們比較了幾個GAN,但很少有效。表1顯示T-GAN仍能很好地工作,同時提高分辨率,只需要擴大模型的大小。我們還測試了256×256分辨率的T-GAN,T-GAN也運行良好,但其他所有人都沒有做到(圖3) 。值得一提的是,無論是64×64,128×128還是256×256分辨率的T-GAN在12000次迭代後將獲得良好的性能。 也就是說,大規模不會影響T-GAN的收斂。

5Conclusion

在本文中,我們提出了一種新的對抗模式,用於訓練稱為T-GAN的生成模型。 這種對抗模式可以解釋為GAN中的圖靈測試。 它是訓練GAN而不是特定GAN模型的指導思想。 它可以與當前流行的GAN(如SGAN和WGAN)集成,從而做到T-SGAN和T-WGAN。我們的實驗表明,T-GAN在從小規模到大規模的數據集上具有良好且穩定的性能。 它表明在GAN中更 新髮生器時,實際樣本的信號非常重要。 然而,T-GAN提高穩定性和收斂速度的機制仍有待進一步探索

原文標題:Training Generative Adversarial Networks Via Turing Test

開源關鍵詞:T-GANs