尋夢新聞LINE@每日推播熱門推薦文章,趣聞不漏接❤️

機器之心整理

參與:李澤南、杜偉

新春快樂!2019 年剛剛過去,去年有哪些最重要的研究是必須要記住的?本文將帶你一並回顧

新春快樂!2019 年剛剛過去,去年有哪些最重要的研究是必須要記住的?本文將帶你一並回顧

2019 年可以說是「預訓練模型」流行起來的一年。自 BERT 引發潮流以來,相關方法的研究不僅獲得了 EMNLP 大會最佳論文等獎項,更是在 NLP、甚至圖像領域里引領了風潮。

去年也有很多遊戲 AI 取得了超越人類的水平。人工智能不僅已經玩轉德州撲克、星際爭霸和 Dota2 這樣複雜的遊戲,還獲得了 Nature、Science 等頂級期刊的肯定。

機器之心整理了去年全年在人工智能、量子計算等領域里最為熱門的七項研究。讓我們以時間的順序來看:

OpenAI 發布 15 億參數量的通用語言模型 GPT-2

第一個重磅研究出現在 2 月,繼發布刷新 11 項 NLP 任務記錄的 3 億參數量語言模型 BERT 之後,Google OpenAI 於 2019 年 2 月再次推出了一種更為強大的模型,而這次的模型參數量達到了 15 億。 這是一種大型無監督語言模型,能夠生產連貫的文本段落,在許多語言建模基準上取得了 SOTA 表現。此外,在沒有任務特定訓練的情況下,該模型能夠做到初步的閱讀理解、機器翻譯、問答和自動摘要。

該模型名為 GPT-2,它是基於 Transformer 的大型語言模型,包含 15 億參數、在一個 800 萬網頁數據集上訓練而成。訓練 GPT-2 有一個簡單的目標:給定一個文本中前面的所有單詞,預測下一個單詞。GPT-2 是對 GPT 模型的直接擴展,在超出 10 倍的數據量上進行訓練,參數量也多出了 10 倍。

- GitHub 項目地址: https://github.com/openai/gpt-2

- 論文鏈接: https://d4mucfpksywv.cloudfront.net/better-language-models/language_models_are_unsupervised_multitask_learners.pdf

GPT-2 展示了一系列普適而強大的能力,包括生成當前最佳質量的條件合成文本,其中我們可以將輸入饋送到模型並生成非常長的連貫文本。此外,GPT-2 優於在特定領域(如維基百科、新聞或書籍)上訓練的其它語言模型,而且還不需要使用這些特定領域的訓練數據。在知識問答、閱讀理解、自動摘要和翻譯等任務上,GPT-2 可以從原始文本開始學習,無需特定任務的訓練數據。雖然目前這些下遊任務還遠不能達到當前最優水平,但 GPT-2 表明如果有足夠的(未標註)數據和計算力,各種下遊任務都可以從無監督技術中獲益。

展開全文

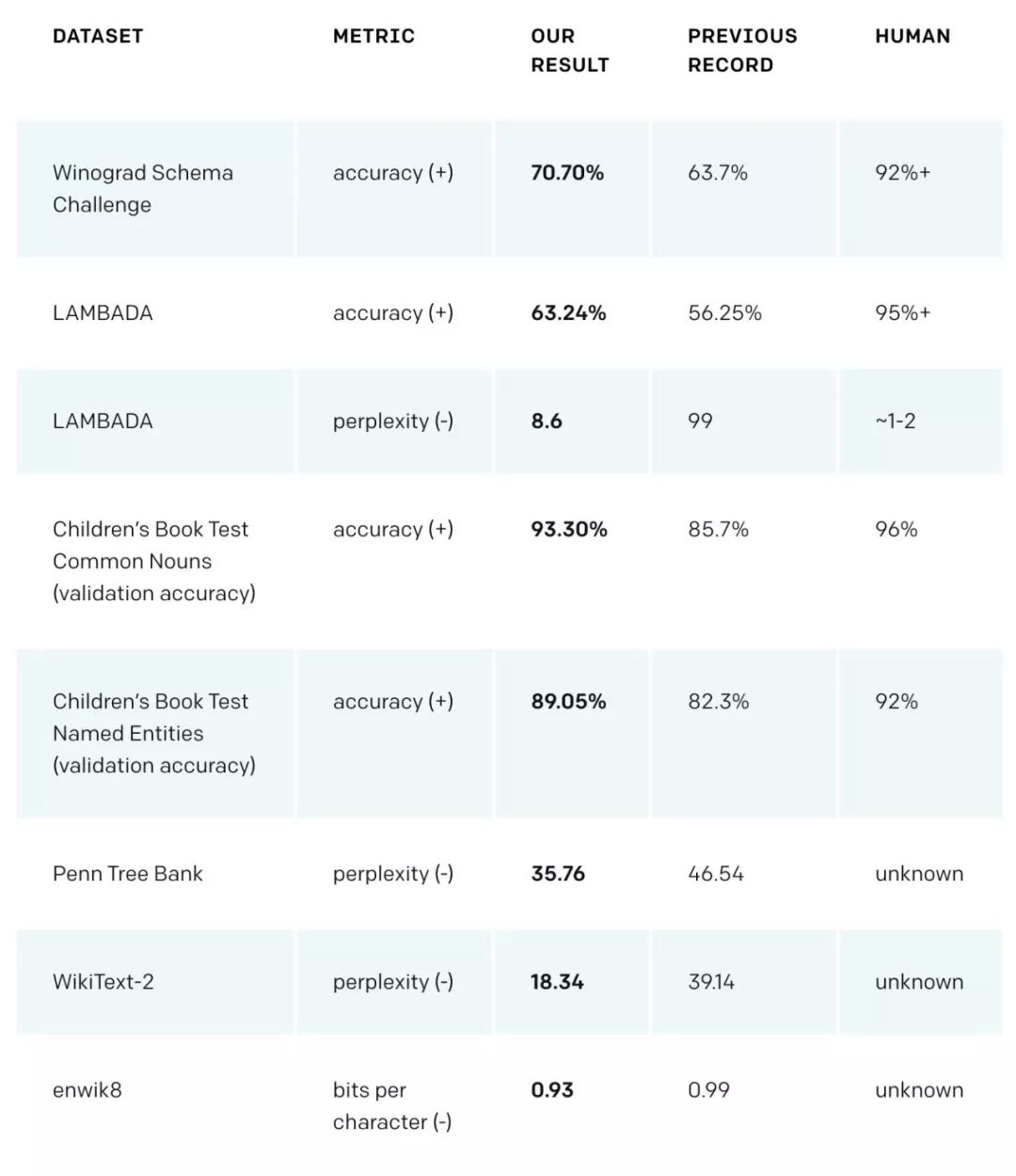

GPT-2 在 Winograd Schema、LAMBADA 和其他語言建模任務中達到了當前最佳性能。

最後,基於大型通用語言模型可能會產生巨大的社會影響,也考慮到模型可能會被用於惡意目的,在發布 GPT-2 時,OpenAI 採取了以下策略:僅發布 GPT-2 的較小版本和示例代碼,不發布數據集、訓練代碼和 GPT-2 模型權重。

延伸閱讀:

ICML 2019 最佳論文:擁有解耦表征的無監督學習是不可能的

機器學習頂會的最佳論文,總會引起人們的廣泛討論。在今年 6 月於美國加州舉辦的 ICML 2019(國際機器學習大會)上,由蘇黎世聯邦理工學院(ETH)、德國馬普所、Google大腦共同完成的《Challenging Common Assumptions in the Unsupervised Learning of Disentangled Representations》獲得了其中一篇 最佳論文 。 研究者在論文中提出了一個與此前學界普遍預測相反的觀點:對於任意數據,擁有相互獨立表征(解耦表征)的無監督學習是不可能的。

論文鏈接:https://arxiv.org/abs/1811.12359

在這篇論文中,研究者冷靜地審視了該領域的最新進展,並對一些常見的假設提出了質疑。

首先,研究者表示從理論上來看,如果不對模型和數據進行歸納偏置,無監督學習解耦表征基本是不可能的;然後他們在七個不同數據集進行了可復現的大規模實驗,並訓練了 12000 多個模型,包括一些主流方法和評估指標;最後,實驗結果表明,雖然不同的方法強制執行了相應損失「鼓勵」的屬性,但如果沒有監督,似乎無法識別完全解耦的模型。此外,增加的解耦似乎不會導致下遊任務學習的樣本複雜度的下降。

研究者認為,基於這些理論,機器學習從業者對於超參數的選擇是沒有經驗法則可循的,而在已有大量已訓練模型的情況下,無監督的模型選擇仍然是一個很大的挑戰。

神經網路架構搜尋新方法無需顯式權重訓練即可執行各種任務

去年 6 月,來自德國波恩-萊茵-錫格應用技術大學和Google大腦的研究者發表了一篇名為《Weight Agnostic Neural Networks》的論文,進而引爆了機器學習圈。在該論文中,他們提出了一種神經網路架構搜尋方法,這些網路可以在不進行顯式權重訓練的情況下執行各種任務。

論文鏈接:https://arxiv.org/pdf/1906.04358.pdf

通常情況下,權重被認為會被訓練成 MNIST 中邊角、圓弧這類直觀特徵,而如果論文中的算法可以處理 MNIST,那麼它們就不是特徵,而是函數序列/組合。對於 AI 可解釋性來說,這可能是一個打擊。很容易理解,神經網路架構並非「生而平等」,對於特定任務一些網路架構的性能顯著優於其他模型。但是相比架構而言,神經網路權重參數的重要性到底有多少?

來自德國波恩-萊茵-錫格應用技術大學和Google大腦的一項新研究提出了一種神經網路架構搜尋方法,這些網路可以在不進行顯式權重訓練的情況下執行各種任務。

為了評估這些網路,研究者使用從統一隨機分布中采樣的單個共享權重參數來連接網路層,並評估期望性能。結果顯示,該方法可以找到少量神經網路架構,這些架構可以在沒有權重訓練的情況下執行多個強化學習任務,或 MNIST 等監督學習任務。

CMU 預訓練模型 XLNet

BERT 帶來的影響還未平復,CMU 與Google大腦 6 月份提出的 XLNet 在 20 個任務上超過了 BERT 的表現,並在 18 個任務上取得了當前最佳效果。

來自卡耐基梅隆大學與Google大腦的研究者提出新型預訓練語言模型 XLNet,在 SQuAD、GLUE、RACE 等 20 個任務上全面超越 BERT。

作者表示,BERT 這樣基於去噪自編碼器的預訓練模型可以很好地建模雙向語境信息,性能優於基於自回歸語言模型的預訓練方法。然而,由於需要 mask 一部分輸入,BERT 忽略了被 mask 位置之間的依賴關係,因此出現預訓練和微調效果的差異(pretrain-finetune discrepancy)。

基於這些優缺點,該研究提出了一種泛化的自回歸預訓練模型 XLNet。XLNet 可以:1)通過最大化所有可能的因式分解順序的對數似然,學習雙向語境信息;2)用自回歸本身的特點克服 BERT 的缺點。此外,XLNet 還融合了當前最優自回歸模型 Transformer-XL 的思路。

延伸閱讀:

AI 攻陷多人德州撲克登上 Science

2019 年 7 月,在無限制德州撲克六人對決的比賽中,德撲 AI Pluribus 成功戰勝了五名專家級人類玩家。Pluribus 由 Facebook 與卡耐基梅隆大學(CMU)共同開發,做到了前輩 Libratus(冷撲大師)未能完成的任務,該研究已經登上了當期《科學》雜誌。

據介紹,Facebook 和卡內基梅隆大學設計的比賽分為兩種模式:1 個 AI+5 個人類玩家和 5 個 AI+1 個人類玩家,Pluribus 在這兩種模式中都取得了勝利。如果一個籌碼值 1 美元,Pluribus 平均每局能贏 5 美元,與 5 個人類玩家對戰一小時就能贏 1000 美元。職業撲克玩家認為這些結果是決定性的勝利優勢。這是 AI 首次在玩家人數(或隊伍)大於 2 的大型基準遊戲中擊敗頂級職業玩家。

在論文中,Pluribus 整合了一種新的在線搜尋算法,可以通過搜尋前面的幾步而不是只搜尋到遊戲結束來有效地評估其決策。此外,Pluribus 還利用了速度更快的新型 Self-Play 非完美信息遊戲算法。綜上所述,這些改進使得使用極少的處理能力和內存來訓練 Pluribus 成為可能。訓練所用的雲計算資源總價值還不到 150 美元。這種高效與最近其他人工智能里程碑項目形成了鮮明對比,後者的訓練往往要花費數百萬美元的計算資源。

Pluribus 的自我博弈結果被稱為藍圖策略。在實際遊戲中,Pluribus 使用搜尋算法提升這一藍圖策略。但是 Pluribus 不會根據從對手身上觀察到的傾向調整其策略。

實驗中 Pluribus 與人類玩家對抗時的界面。

Pluribus 在 10000 手實驗中對職業撲克玩家的平均勝率。直線表示實際結果,虛線表示一個標準差。

Pluribus 在與頂尖玩家對戰時的籌碼數量變化。

延伸閱讀:

Google宣布做到量子優越性

在人工智能之外的量子計算領域,去年也有重要的研究突破。2019 年 9 月,Google提交了一篇名為《Quantum supremacy using a programmable superconducting processor》的論文自 NASA 網站傳出,研究人員首次在實驗中證明了量子計算機對於傳統架構計算機的優越性:在世界第一超算 Summit 需要計算 1 萬年的實驗中,Google的量子計算機只用了 3 分 20 秒。因此,Google宣稱做到「量子優越性」。之後,該論文登上了《自然》雜誌 150 周年版的封面。

Google的「量子優越性」論文登上《自然》雜誌 150 周年版封面。

這一成果源自科學家們不懈的努力。Google在量子計算方向上的研究已經過去了 13 年。2006 年,Google科學家 Hartmut Neven 就開始探索有關量子計算加速機器學習的方法。這項工作推動了 Google AI Quantum 團隊的成立。2014 年,John Martinis 和他在加利福尼亞大學聖巴巴拉分校(UCSB)的團隊加入了Google的工作,開始構建量子計算機。兩年後,Sergio Boixo 等人的論文發表,Google開始將工作重點放在做到量子計算優越性任務上。

如今,該團隊已經構建起世界上第一個超越傳統架構超級計算機能力的量子系統,可以進行特定任務的計算。

Google CEO 桑達爾·皮查伊和聖芭芭拉實驗室中Google的量子計算機。

量子優越性實驗是在一個名為 Sycamore 的 54 量子比特的完全可編程處理器上運行的。該處理器包含一個二維網格,網格中的每個量子比特與其他四個相連。量子優越性實驗的成功歸功於Google改進了具有增強並行性的雙量子比特門,即使同時操作多個門,也能可靠地做到記錄性能。Google使用一種新型的控制旋鈕來做到這一性能,該旋鈕能夠關閉相鄰量子比特之間的交互。此舉大大減少了這種多連通量子比特系統中的誤差。此外,通過優化晶片設計來降低串擾,以及開發避免量子比特缺陷的新控制校準,Google進一步提升了性能。

延伸閱讀:

DeepMind 星際爭霸 AI 登上 Nature

雖然 AI 沒有打敗最強人類玩家 Serral,但其研究的論文仍然登上了 Nature。2019 年 10 月底,DeepMind 有關 AlphaStar 的論文發表在了當期《Nature》雜誌上,這是人工智能算法 AlphaStar 的最新研究進展,展示了AI 在「沒有任何遊戲限制的情況下」已經達到星際爭霸Ⅱ人類對戰天梯的頂級水平,在 Battle.net 上的排名已超越 99.8%的活躍玩家。

DeepMind 發推稱已達到 Grandmaster 水平。

回顧 AlphaStar 的發展歷程,DeepMind 於 2017 年宣布開始研究能進行即時戰略遊戲星際爭霸Ⅱ的人工智能——AlphaStar。2018 年 12 月 10 日,AlphaStar 擊敗 DeepMind 公司里的最強玩家 Dani Yogatama;12 月 12 日,AlphaStar 已經可以 5:0 擊敗職業玩家 TLO 了(TLO 是蟲族玩家,據遊戲解說們認為,其在遊戲中的表現大概能有 5000 分水平);又過了一個星期,12 月 19 日,AlphaStar 同樣以 5:0 的比分擊敗了職業玩家 MaNa。至此,AlphaStar 又往前走了一步,達到了主流電子競技遊戲頂級水準。

根據《Nature》論文描述,DeepMind 使用通用機器學習技術(包括神經網路、借助於強化學習的自我博弈、多智能體學習和模仿學習)直接從遊戲數據中學習。AlphaStar 的遊戲方式令人印象深刻——這個系統非常擅長評估自身的戰略地位,並且準確地知道什麼時候接近對手、什麼時候遠離。此外,論文的中心思想是將遊戲環境中虛構的自我博弈擴展到一組智能體,即「聯盟」。

聯盟這一概念的核心思想是:僅僅只是為了贏是不夠的。相反,實驗需要主要的智能體能夠打贏所有玩家,而「壓榨(exploiter)」智能體的主要目的是幫助核心智能體暴露問題,從而變得更加強大。這不需要這些智能體去提高它們的勝率。通過使用這樣的訓練方法,整個智能體聯盟在一個端到端的、完全自動化的體系中學到了星際爭霸Ⅱ中所有的複雜策略。

延伸閱讀:

2019 年在 AI 領域的各個方向上都出現了很多技術突破。新的一年,我們期待更多進展。

此外,機器之心於 2019 年 9 月底推出了自己的新產品 SOTA 模型,讀者可以 根據自己的需要尋找機器學習對應領域和任務下的 SOTA 論文,平台會提供論文、模型、數據集和 benchmark 的相關信息。

:22大領域、127個任務,機器學習 SOTA 研究一網打盡。