尋夢新聞LINE@每日推播熱門推薦文章,趣聞不漏接❤️

為了輔助人類,AI已經練就了「十八般武藝」

如寫詩作詞、繪畫、修圖,編輯視訊等等,樣樣精通。

但如果人類只想——在凌亂的櫥櫃裡找到一罐豆子?AI還能幫上忙嗎?

也許真的可以!

最近,加州大學伯克利研究團隊公布了一項最新成果,他們開發了一種AI系統,

「該系統將預測目標物體位置的可感知管道與機械搜索策略相結合,可依次選擇遮擋物體並推到一邊,以盡可能的展示目標物體。」

「該系統將預測目標物體位置的可感知管道與機械搜索策略相結合,可依次選擇遮擋物體並推到一邊,以盡可能的展示目標物體。」

簡單來說,就是他們訓練了一個AI機器人可以在狹窄的空間內移除遮擋物,並找到目標物體。

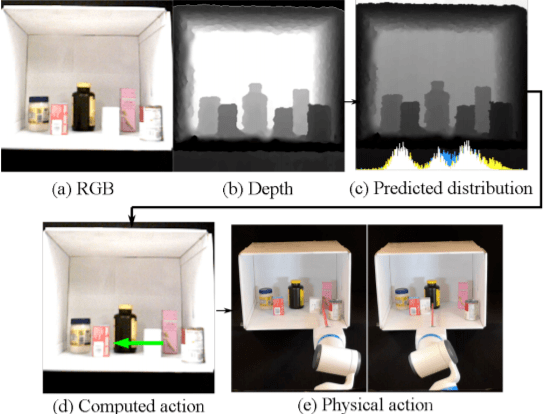

他們還提供了一段Demo範例:

圖中,AI機器臂順利移開了前面白色和紅色的遮擋物,發現了隱藏背後的豆子罐頭,研究人人員介紹,目前該系統的準確率最高可達到87%以上。

看到這裡你可能會好奇,為什麼要研發這個看起來很簡單又很日常的AI呢?

廚房裡的AI:LAX-RAY

事實上,龐雜環境中的目標對象搜索是AI機器人技術的重點研究方向之一,其相幹研究成果也不再少數,但總體而言,針對諸如貨架、廚房、壁櫥等環境下的研究卻很少。

然而,它卻在現實世界中有著廣泛的應用場景。

例如,醫院藥房的服務機器人可能需要從櫥櫃中找到耗材;工業機器人可能需要從倉庫貨架上找到成套工具;又或者零售商店的服務機器人可能需要在貨架上搜索所需物品等。

這項研究是伯克利和Google研究團隊共同開展的,Google研究人員稱:

我們一直在研究將AI應用於最日常的活動場景中去,因為改善搜索和選擇對象的方法是工業應用,科學實驗,醫療保健,零售業務以及無數商業場景和制造過程的核心。

我們一直在研究將AI應用於最日常的活動場景中去,因為改善搜索和選擇對象的方法是工業應用,科學實驗,醫療保健,零售業務以及無數商業場景和制造過程的核心。

需要說明的是,以上看似簡單的操作背後有著龐雜的技術需求。

如研究人員介紹,醫院、倉庫或零售貨架等場景,因為空間有限、存在視野障礙,為AI系統的搜索與檢測任務帶來了極大的挑戰。

為此,他們提出了一種新型預測目標位置系統:LAX-RAY(Lateral Access maXimal Reduction of occupancY),該系統支持查找貨架上被遮擋的物體,並解決物體之間「密集接觸」的操縱任務。

具體來說,研究人員基於該系統提出了:分布區域縮減(DAR),分布熵縮減(DER),以及Uniform三種搜索策略。

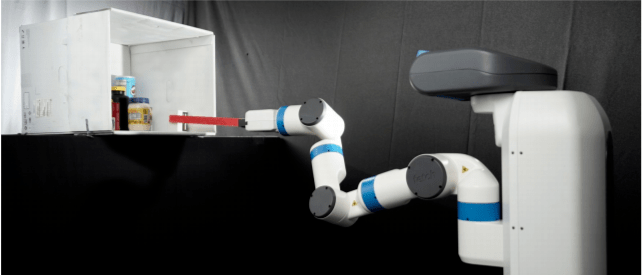

為了測試這些策略的性能,研究人員利用一個開放框架——一階貨架模擬器(FOSS)生成了800個難度各異的隨機貨架環境,然後將LAX-RAY系統和嵌入式深度感應照相頭部署到了Fetch機器人中進行了測試。

結果顯示,與DER相比,DAR和DER-MT策略的表現更好。在模擬中,LAX-RAY系統準確度達到了87.3%。而在實際應用環境中,準確率也達到了大約80%。這表明LAX-RAY可以在現實環境中有效地查找被遮擋的目標對象。

技術原理及結果

LAX-RAY檢測系統分為兩個主要部分,一是預測目標物體空間占有率感知管道;二是利用該資訊有效地解決查找問題的搜索策略。搜索策略結合感知模塊的輸出結果和每個步驟的觀察結果做出移除動作,從而可以有效地發現目標對象。

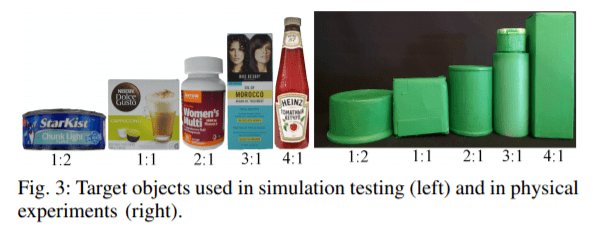

在感知管道預測之前,需要對被遮擋物體進行深度識別和目標對象分割。在這裡,研究人員從Google掃描數據集中,渲染了5個目標物體的30000多個圖像進行了訓練,其中,大約50%的圖像包含完全遮擋的目標物體。

此外,研究人員還從一組單獨的目標模型中渲染了10000幅圖像,這些目標與測試集具有相似的縱橫比。

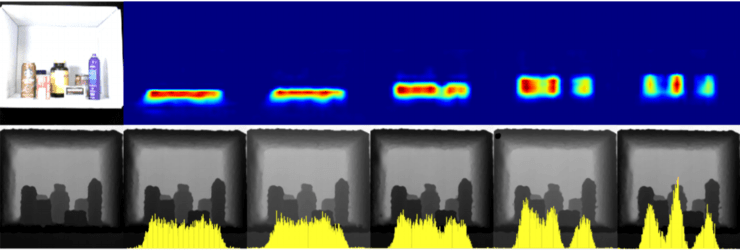

如圖,測試數據集中的遮擋對象具有不同的類別和不同的形狀。研究人員使用動量為0.99的隨機梯度下降法訓練了一個完全連接的網路(FCN),該網路以目標物體分割掩模和當前貨架的深度圖像為輸入,可輸出目標物體的位置分布密度圖。

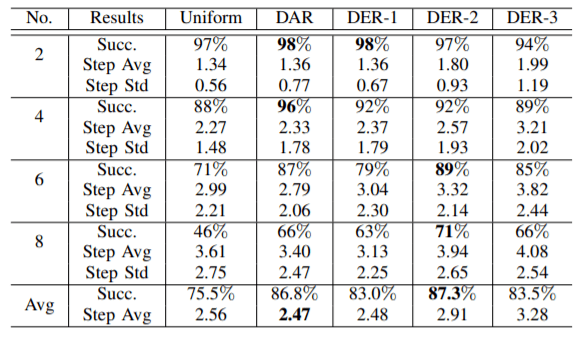

實驗結果如下:

研究人員把隨機的物體放在一個白色的架子上,使用嵌入在機器人上的PrimeSense RGBD相機來獲得顏色和深度圖像。在彩色圖像上使用一種顏色檢測算法,通過設置RGB值的閾值來檢測被塗成綠色的目標對象。

如下圖顯示了在完全遮擋情況下,架子上隨機排列的目標對象的預測結果。

圖中,5個不同的目標物體(長寬比為1:2到4:1)。左側顯示了隨機物體在架子上的顏色和PrimeSense相機拍攝的深度圖像。第一行顯示了來自預訓練模型的二維占用率分布,第二行顯示了覆蓋深度觀測的1D占用率分布。

在實際應用中,每個長寬比的預測值有顯著差異,再次驗證了預訓練模型的準確性。

基於感知位置資訊,研究人員提出了三種搜索策略:

- 分布區域縮減(DAR):使用當前深度圖像對可用操作進行排序,並針對每個對象計算對象掩碼,預測最小位置分布的重疊區域。

- 分布熵縮減(DER-n):通過在當前深度圖像上分割掩模的深度值來預測Pˆt+n,可得到新的深度圖像的占有率分布,從而得到預測狀態。

- Uniform:通過DAR中預測的占用率分布來創建均勻分布,以代替具有遮擋對象的位置。

實驗結果如下:

研究人員在800個場景上測試了DER-n(n∈{1,2,3})DAR和Uniform策略。目標物體使用的是長寬比為1:1的綠色立方體。如果在10個操作中至少有90%的目標物體展示出來,則認為策略成功。

表中可以看出,DAR、DER-n策略的性能優於Uniform策略,尤其是當對象數量增加時。當遮擋對象數目增加時,所有策略的性能都會下降,因為AI機器臂需要更多的操作步驟來顯示目標。

當遮擋對象少於6個時,DAR的性能最好。但在6個及更多個對象的場景中,DER-2表現最好,達到了最高87.3%。其中,與DER-2相比,DER-1的性能較差,是因為沒有足夠的目標資訊被預測出來,而DER-3較差的原因,是由於預測誤差的累積。

也就是說,當遮擋對象數較少時,預測誤差占主導地位,這可以解釋DAR比DER-2性能更好的原因。

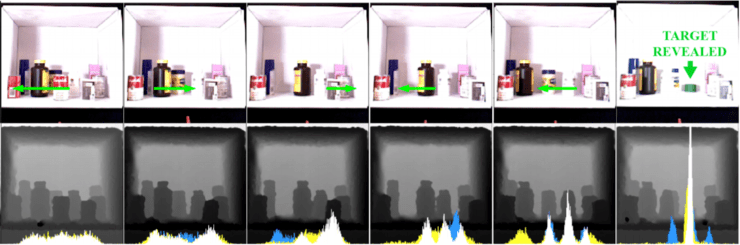

以下是DER-1查找9個遮擋物中的目標物體的序列圖。

頂部綠色箭頭的RGB圖像,表示推進方向和距離。底部是占用率分布的深度圖像。

每個深度圖像底部繪制的占用率分布包括三部分:上一個時間步長的預測分布(藍色)、當前時間步長的預測分布(黃色)以及兩個分布中的最小值(白色)。

總之,本次研究證明了基於LAX-RAY系統檢測策略的可行性和準確性。研究人員表示,在未來的工作中計劃研究更龐雜的深度模型,並使用平行於相機的推力來為側向推力創造空間,或者使用氣動吸盤來拉動混亂貨架上遮擋物體。

更多論文詳細內容,請參見:https://arxiv.org/abs/2011.11696

引用鏈接:

https://techxplore.com/news/2020-11-ai-items-constricted-regions.html

Robotics researchers propose AI that locates and safely moves items on shelves

http://ai.stanford.edu/mech-search/shelf/

雷鋒網雷鋒網雷鋒網