尋夢新聞LINE@每日推播熱門推薦文章,趣聞不漏接❤️

你知道嗎?人類有 70%的信息獲取來自於視覺。但目前存在兩個問題: ①人眼本身只能看到物理世界,無法看到其背後複雜的信息世界; ②人類的記憶力有限,視野有限,於是會出現看了就忘、視野窄等各種問題。

科幻片里常見這樣一種「人肉外掛」:通過一系列的技術改造,主人公(比如史塔克)眼前出現的一切物體都會被自動識別,什麼名稱、用途、用法用量,全都可以秒速反饋回來,並被即時載入到記憶中,過目不忘。

如今,百度識圖在百度 App 和簡單搜尋 App 上推出的最新版,通過應用Lens技術把這種科幻場景往現實生活中拉得更近了一點!

一、百度識圖可以做什麼?

作為目前全球識別能力最廣的AI視覺產品,百度識圖已支持超過 30+場景的認知。

例如:掃商品找同款比價格,掃植物學辨認技巧看養護知識,掃人臉測面相運勢,掃菜品/食材看熱量知功效做法、掃明星看八卦追行程、掃汽車了解型號價格、掃紅酒查酒莊年份、掃題目搜答案看解析。

此外還有AR翻譯、文字、圖書、海報、藥品、貨幣、電影等多品類的認知能力。

二、Lens技術是什麼?

Lens技術是一種基於移動端實時感知和雲端視覺搜尋的類人眼視覺 AI 能力,能夠做到所見即所得的信息瀏覽體驗。

應用Lens技術後,打開百度識圖,無需拍照,毫秒內自動掃描並鎖定鏡頭內檢測到的全部物體,即刻反饋「它是什麼」,「它背後的相關信息」,讓你隨時隨地擁有「移動的百科全書」。

三、本次升級有什麼重要意義?

從行為層面,它將深度強化人眼視覺理解能力,改變人類認知事物的習慣並為未來的智能眼鏡奠定堅實基礎。你可以借助百度識圖真正做到邊走邊看,不間斷瀏覽,同時,依托於百度識圖背後的超級百度大腦,將確保為每個實物提供精準、深度的信息介紹,讓你邊看邊學。

從技術層面,它首次做到了類人眼的對實時視頻流數據的感知和認知能力。百度識圖具備了目前全球最快最穩定的跨平台實時視覺 AI 能力,可以嵌入到 Android/iOS 系統部署,依靠百度移動端深度學習預測框架Paddle-mobile,支持 ios,android,linux-arm,fpga 等平台的編譯和部署,使深度學習模型能夠在移動端和智能硬件中運行,並保持業內遙遙領先的性能和效果指標。

四、百度識圖的Lens技術攻克了哪些難題?

為了達到類人眼的視力,人工智能必須充分調動起複雜且涉及眾多環節的能力。在這一過程中,百度識圖的Lens技術遇到並解決了4個核心問題。

1、快速連續穩定地發現新物體

人眼對視覺信號反應時間170ms~400ms,新進入視野的物體能夠被快速的看見,當視角發生變化時新視野的物體在被發現的同時,也能夠建立與舊視野內物體的對應關係。具體到技術上,分為兩個問題:單幀圖像的物體檢測的性能和連續幀圖像物體檢測的穩定性。

① 單幀物體檢測的性能包含準確率、召回率和檢測速度。過深的 CNN,相應地耗時也都較長。而且終端 GPU 相比服務器 GPU 的性能還要拉開十倍以上的差距,耗時更長。

因此,我們選擇構建輕量級的 MobileNet 網路結構做到移動端物體檢測,並且構建覆蓋通用場景的百萬級別通用物體檢測圖片數據集。針對基礎模型進行壓縮,進一步提升預測速度,同時模型運行在百度自研的移動端深度學習預測框架Paddle-mobile上,作為PaddlePaddle的移動端預測引擎,針對嵌入式手機等平台的計算晶片做了大量優化,最終可支持在手機端做到單幀多目標檢測耗時60 ms 以內,主要物體檢測準確率和召回率均在95%以上。

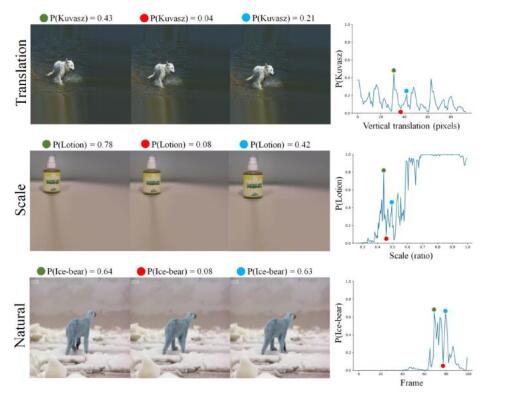

② 連續幀圖像物體檢測的穩定性是我們面臨的一個新挑戰,它關注解決的問題是如何量化衡量在連續幀上不斷的進行物體檢測時,物體是否被檢測到的狀態變化。

在圖像上物體的微小平移、尺度、姿態變換,都導致 CNN 輸出變化劇烈

百度提出了一種移動終端基於視覺跟蹤的連續幀多目標檢測方法專利,在實時連續幀數據上,用跟蹤完成短時的物體狀態保持,並在視野物體發生變化時,在檢測模型中融合跟蹤算法的輸出,給出最終的穩定的連續幀物體檢測結果。最終幀錯誤率從16.7%降低到2%。

2、連續實時跟蹤物體

為了讓反饋信息像放置在真實世界中的一樣穩定,百度採用了 SLAM(Simultaneous Localization and Mapping)技術。在未知環境中,通過對環境的觀測確定自身的運動軌跡,同時構建出環境三維地圖。

針對文字跟蹤的場景,還涵蓋了 Texture Mapping 技術,將文字的翻譯結果,無縫地融合到源語言文字位置處,達到原生視覺效果。

3、視覺信號多層認知,

先粗看再細看

人眼會對視野內的物體先產生初步理解,例如左前方有輛汽車。當眼睛注意力集中到汽車時,再由具體認知環節分辨是BMW320還是賓士C200。

粗粒度語義理解模型的訓練,整理構建涵蓋辦公、家庭生活、商場、超市、戶外園區和街道等主要場景的300+標籤分類標籤體系,包含百萬級物體局部圖的數據集。

細粒度物體認知是由一整套複雜的雲端系統構成,包含萬級別大規模細粒度分類模型,以及基於 ANN 最近鄰向量檢索構建的百度新一代視覺檢索技術,支持相似圖、同款商品、名人臉等檢索。

4、無縫連接以上三個環節

人眼在接收到視覺信號後,由大腦完美地調度,發現、跟蹤和多層認知三個環節做到無縫銜接。在技術做到上,卻需要考慮非常多的因素,包括用戶注意力判斷、注意力集中時的選幀算法、跟蹤和檢測算法的調度切換策略。

通過精細的組合調度算法,我們將百度識圖的耗電量控制在 2%/10min 以內,滿足了移動端部署對能耗的要求。

最終,物體的發現感知、連續跟蹤、粗粒度語義理解,以及根據用戶行為和視覺場景動態組合和調度以上模型的 multi-task planning 算法,整體構成感知計算模塊 Walle SDK,可以支持在 IOS、Android 以及服務器等多種平台部署。

五、未來還有哪些新期待?

1. 在用戶行為及信息理解層面,未來的百度識圖,將會融合:多模態的交互方式、多形態的信息呈現方式以及多縱深角度的信息識別結果,帶來更聰明的視覺理解體驗。那個時候,借助智能設備,我們只需要動動眼睛,說一句話,我們所需要的信息就會以 AR 的方式疊加到我們面前。

2. 在技術應用層面,百度識圖將會成為跨平台應用、並持續豐富物體高級感知能力的維度,促進全人類的人眼視覺能力強化。目前百度識圖能力由純C++做到的跨平台運行庫,核心庫大小300KB,幾乎可以嵌入任何支持深度學習模型運行的終端平台,例如智能硬件、一些智能錄影頭、無人駕駛汽車等等。

六、怎樣體驗百度識圖黑科技?

說了這麼多,你是不是也想趕緊體驗一下呢?升級到最新版百度識圖,就可以體驗黑科技啦,iPhone用戶可以在百度 App(11.2版本) 和簡單搜尋 App(3.1版本) 的「自動拍」 入口體驗,安卓用戶需要耐心等待一下哦,百度App 安卓端將在1月份發布的11.3版本上線黑科技,簡單搜尋的安卓版後續也會很快上線!後續還會推廣到其他場景。

下面以百度 App 為例,帶你一起體驗!

未來,我們會將百度識圖的Lens技術開放給開發者,幫助大家以極小的開發成本即可讓自己的錄影頭具備類人眼能力。

而今天,你可以打開百度 App 和簡單搜尋 App,體驗移動端深度學習框架Paddle Mobile的應用,運用Paddle Mobile重新認識你身邊的視界。