尋夢新聞LINE@每日推播熱門推薦文章,趣聞不漏接

機器之心報導

機器之心編輯部

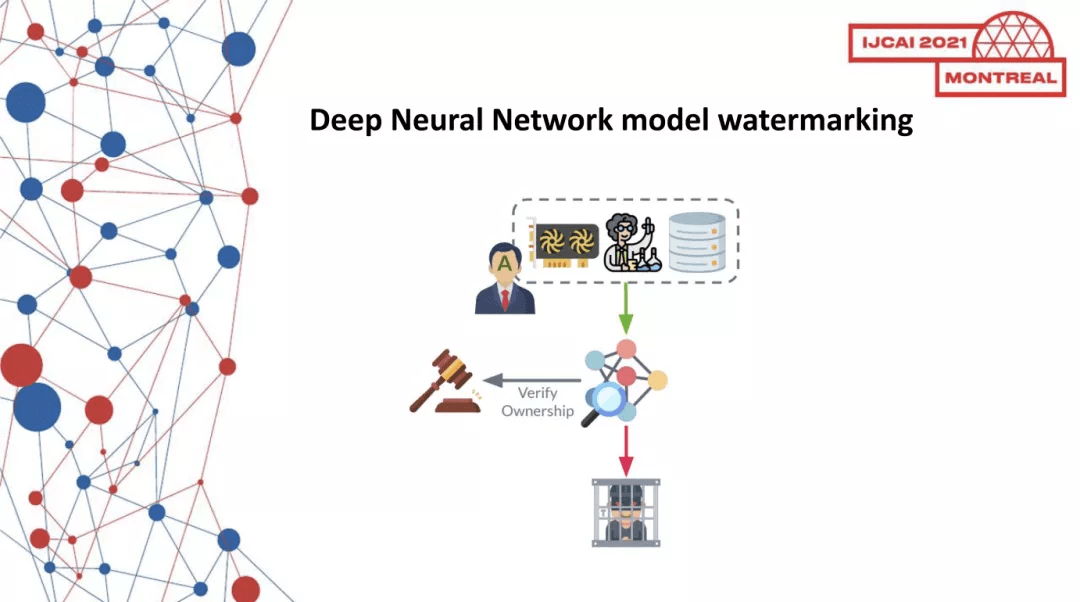

在剛剛結束的 IJCAI 2021 大會上,「深度學習模型智慧財產權保護國際研討會(DeepIPR-IJCAI’21)」正式舉行,這場研討會由微眾銀行、馬來亞大學、香港科技大學、上海交通大學共同主辦。

機器學習,尤其是深度神經網路(DNN)技術,近年來在諸多領域取得了巨大成功,許多科技公司都將神經網路模型部署在商業產品中,提高效益。訓練先進的神經網路模型需要大規模數據集、龐大的計算資源和設計者的智慧。這具體體現在:(1)深度學習模型應用的訓練模型規模巨大,以 GPT-3 為例,其預訓練所用的數據量達到 45TB,訓練費用超過 1200 萬美元,有著極高的經濟成本(2)深度學習模型在訓練部署到工業應用場景過程中(比如智慧金融,智慧醫療應用),需要引入金融、醫療等領域專有先驗知識,因此在模型設計過程就需要引入專家的知識和經驗來訂制模型,這體現了人腦力的智慧財產權。(3)深度學習模型的訓練過程,需要特定領域的海量數據作為訓練資源,存在數據本身價值和知識屬性。以上屬性決定了經過訓練的深度學習模型具有很高的商業價值和知識屬性,必須將其納入合法所有者(即創建它的一方)的智慧財產權。因此,從技術上迫切需要保護深度神經網路(DNN)模型不被非法復制、重新分發或濫用。

深度學習模型智慧財產權保護問題,是一個跨學科的綜合性議題,涉及計算機安全,人工智慧理論與方法、智慧財產權保護、法律等諸多方面。深度學習模型的盜用、非法復制、分發等,攻擊者可以採用技術手段或者非技術手段;但要確認盜用且聲明模型所有權,則是完全從技術端來提取證據,以便從法規的角度來認證模型所有權。具體而言,(1)從計算機安全角度出發,技術手段需要採取密碼學可信的協議,來保證模型的智慧財產權驗證和發布過程是嚴密可信的;(2)從人工智慧理論方法角度出發,模型的所有權認證技術需要保證不犧牲模型可用性前提下,提供可靠且魯棒的智慧財產權保護方法;(3)在法規層面,從技術端對模型所有權提取證據之後,這些證據能成為模型所有權的依據。最終監管方要通過法規的保護,來裁定模型所有者的智慧財產權,這需要相幹法規來指導如何從技術判據,來判定模型所有權。據筆者所知,目前尚未有相幹的立法具體到深度學習模型知識這一子領域,模型智慧財產權保護不僅需要科技工作者的參與,也需要智慧財產權保護領域工作者的關註和努力。

本次研討會定位於深度神經網路智慧財產權保護研究的前沿,展示研究機構及高校實驗室在此領域進行的最前沿的工作。分別來自德國、芬蘭、馬來西亞和中國的 8 位學者,就深度學習模型智慧財產權保護問題,從算法、協議、安全等多個角度出發,分享了他們對模型智慧財產權保護的思考和工作。

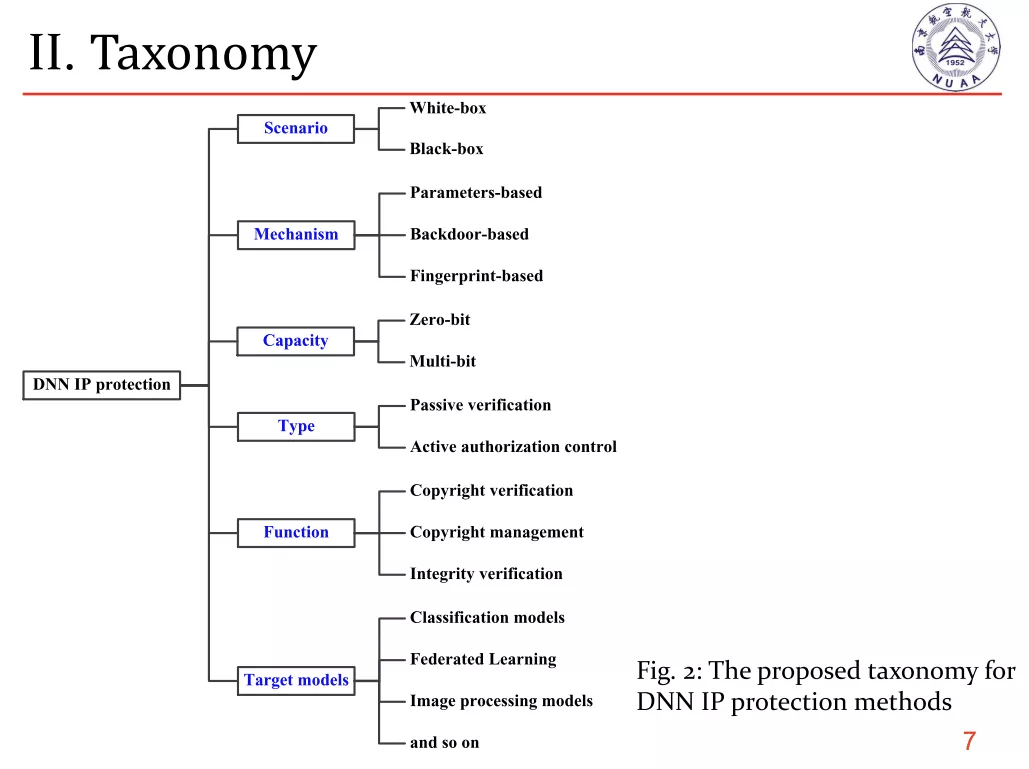

在 Talk 1 中,南京航空太空大學的薛明富老師帶來了《DNN Intellectual Property Protection: Taxonomy, Attacks and Evaluations》的主題講座,他對深度學習模型保護方法進行了分類性的總結,從模型場景、保護機制、保護能力、目標模型等維度,對模型智慧財產權保護研究進行了梳理,並且總結了針對已有的方法,存在的攻擊和挑戰,並給出了系統評估的相幹建議。這場講座為模型保護領域總結了研究現狀和發展脈絡。

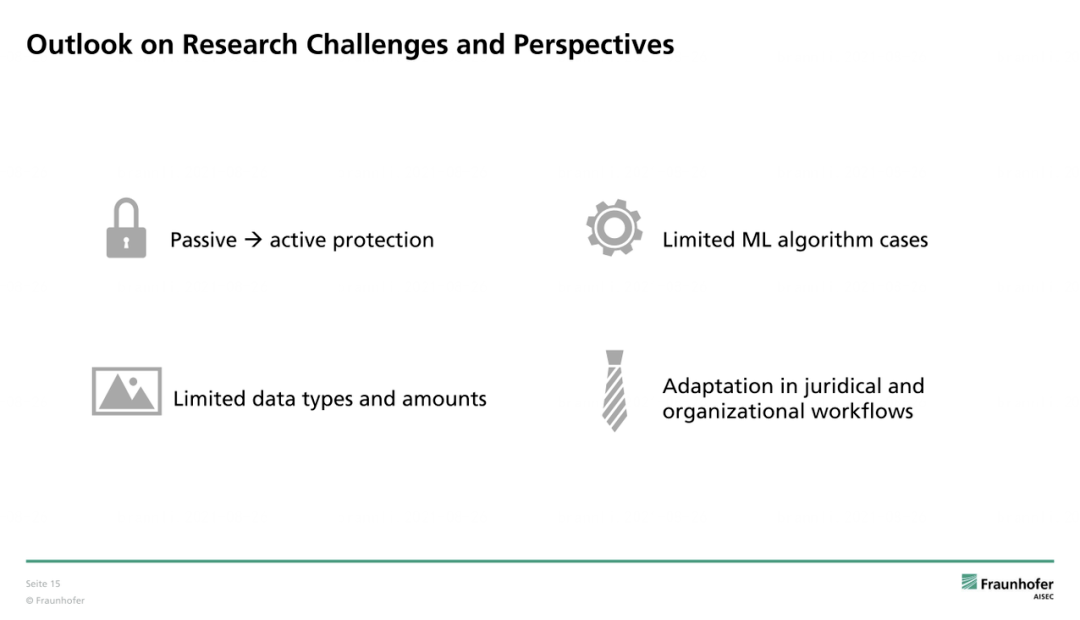

來自德國 Fraunhofer AISEC 研究院的 Franziska Boenisch,同樣針對神經網路水印技術分享了視角下的模型智慧財產權保護的綜述研究工作。Franziska 從神經網路水印技術的需求、算法應用、威脅模型等角度回顧了現有的研究工作,以神經網路水印技術的可用性、魯棒性、可靠性、完整性等要求為主線,串聯回顧了已有的模型水印研究,指出了現有的研究存在幾大待解決的問題,包括缺乏主動保護機制,算法數據類型案例有限和司法保障和技術研究並軌。

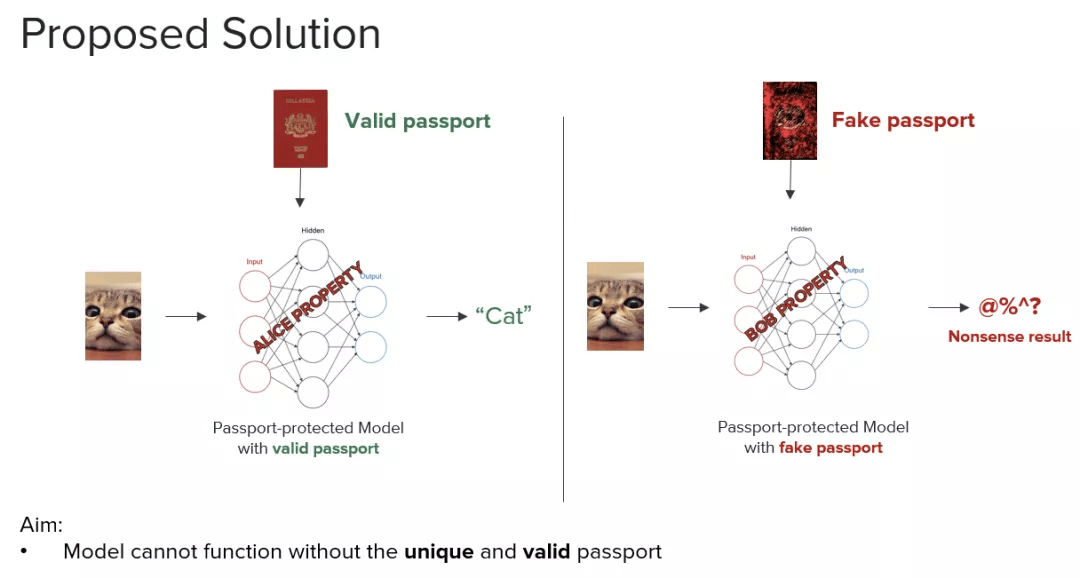

作為深度學習模型智慧財產權保護的資深研究者,畢業自馬來亞大學以及微眾銀行 AI 項目組算法研究員 Kam Woh Ng 分享了他所提出的用數字護照保護模型智慧財產權的方法。Kam Woh Ng 分析了神經網路模型智慧財產權保護的相幹研究的最新進展後發現,一種旨在通過偽造水印來對所有權驗證產生疑問的模糊攻擊,對多種基於水印的 DNN 所有權驗證方法對 DNN 的智慧財產權保護構成了嚴重威脅。

針對上述安全漏洞,Kam Woh Ng 提出了一種新穎的基於數字護照的 DNN 所有權驗證方案,該方案既對網路剪枝及微調等修改具有魯棒性,又能夠抵抗模糊攻擊。嵌入數字護照的關鍵在於,以一種巧妙的方式設計和訓練 DNN 模型,從而使原 DNN 的工作性能在使用偽造護照時大大降低。也就是說,真正的數字護照不僅可以依據預定義的數字簽名來進行驗證,而且還可以根據 DNN 模型的工作性能來認定。Kam Woh Ng 詳細分享如何使用數字護照保護 DNN 以及抵抗模糊攻擊。

Kam Woh Ng 的 Passport 模型保護方法提供了一大類通用的模型保護思路,在本次研討會中,還有其他研究者也分享了模型水印方法具體應用在圖像生成、圖像概述等模型中的工作。

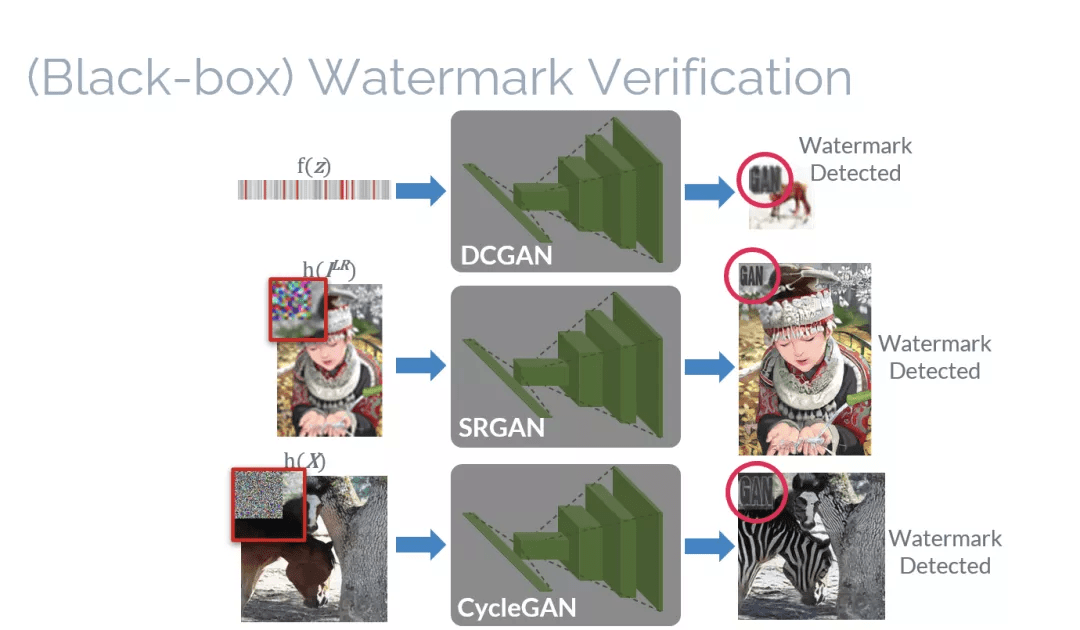

來自馬來西亞馬來亞大學的 Ding Sheng Ong,針對圖像生成深度學習模型,分享了題為《Protecting Intellectual Property of Generative Adversarial Networks From Ambiguity Attacks(GAN 的智慧財產權保護方法)》的講座。

雖然目前已有用於卷積神經網路(CNN)的 IPR 保護方法,但是卻不能直接使用在生成對抗網路(GANs)——另一種被廣泛用於生成逼真圖像的深度學習模型。因此,本文提出了一種基於黑盒與白盒的 GAN 模型 IPR 保護方法。實驗結果表明,本方法並不會損害 GAN 本來的性能(如圖像生成、圖像超分辨率以及樣式轉換)。本方法也能夠抵抗去除嵌入的水印(removal)和模糊(ambiguity)攻擊。分享中解說了如何基於黑盒與白盒的方式保護對抗生成網路(GANs),以及如何抵抗各種水印攻擊。

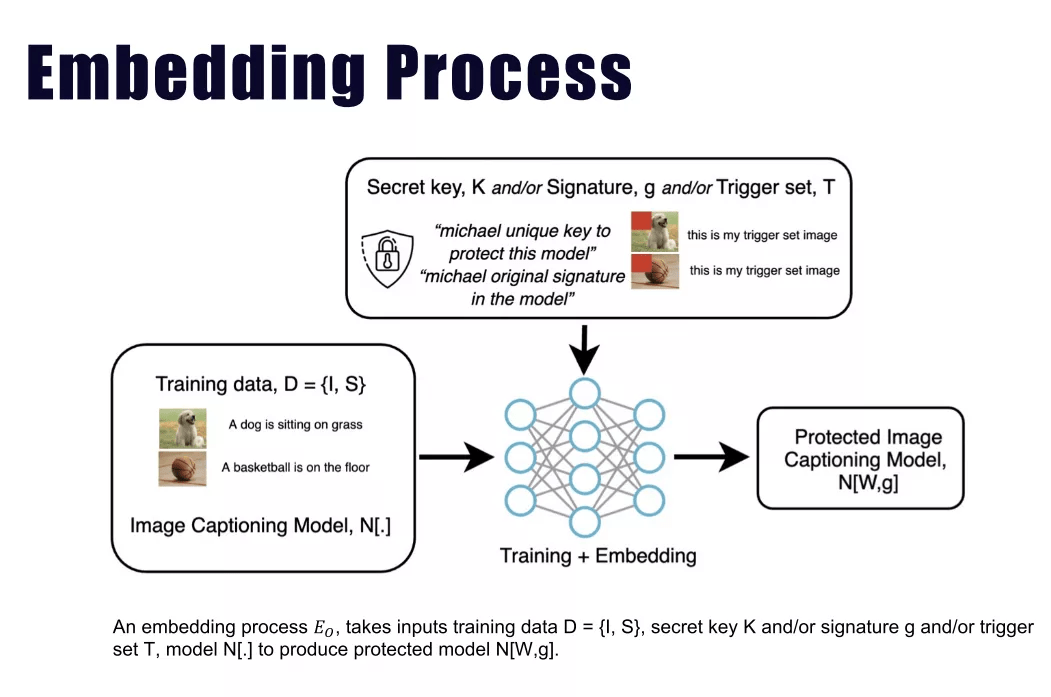

來自馬來西亞馬來亞大學的 Jian Han Lim, 針對圖像標註(image caption)神經網路模型,帶來了題為《Protect, Show, Attend and Tell: Empower Image Captioning Model with Ownership Protection》的分享。Jian Han Lim 指出,現有的深度神經網路智慧財產權 (IPR) 保護通常 i) 僅專註於圖像分類任務,以及 ii) 遵循標準的數字水印框架,該框架通常用於保護多媒體和視訊內容的所有權。Jian Han Lim 論證了當前的數字水印框架不足以保護通常被視為人工智慧前沿之一的圖像標註任務。作為補充,本文研究並提出了在循環神經網路中的兩種不同簽名水印嵌入方案。從理論和經驗的角度來看,其證明偽造的密鑰會產生無法使用的圖像標註模型,從而阻止了侵權的違規行為。該工作是第一個對圖像字幕任務提出所有權保護的工作。此外,大量實驗表明,所提出的方法不會影響 Flickr30k 和 MS-COCO 數據集上所有通用字幕指標的原始圖像標註任務性能,同時它能夠承受去除攻擊和歧義攻擊。

針對深度學習常見任務和模型,已有上述所示多種神經網路保護算法案例提供算法支撐。那麼如何設計可行的通訊協議,指導模型所有權驗證的實際執行?

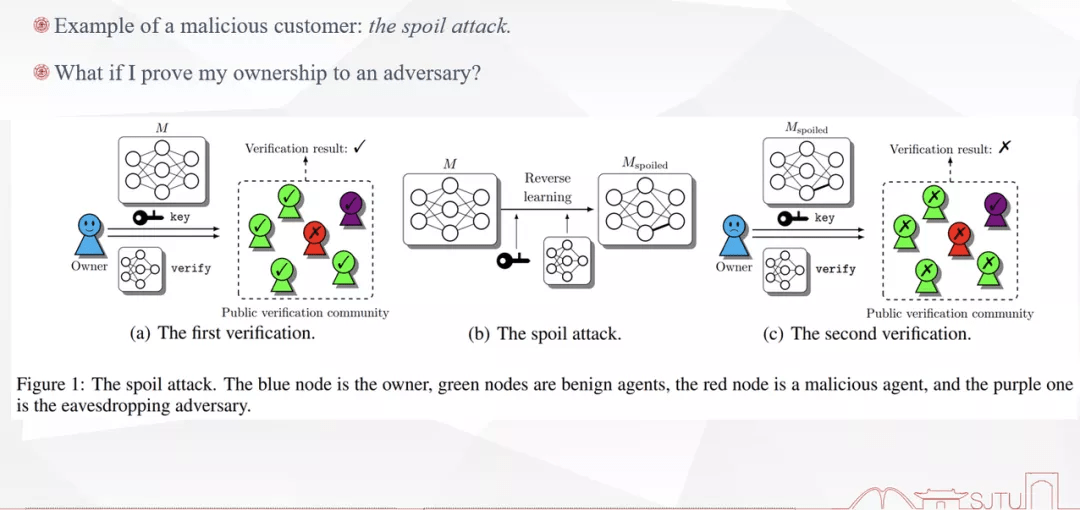

來自上海交通大學的李方圻針對模型所有權驗證的場景、協議和前景進行了題為《Regulating Ownership Verification for Deep Neural Networks: Scenarios, Protocols, and Prospects》的分享。

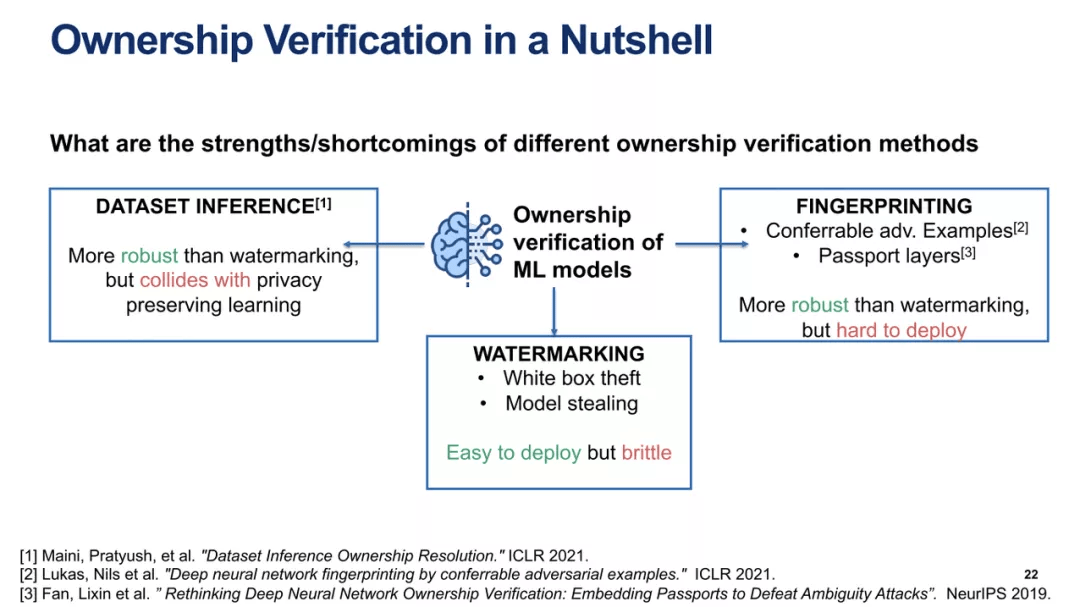

李方圻介紹說,隨著深度神經網路的廣泛應用,將其作為智慧財產權加以保護的必要性變得顯而易見,研究者已經提出了許多水印方案來識別深度神經網路的所有者並驗證所有權。然而,大多數研究都專註於水印嵌入而不是可證明驗證的協議,為了彌合這些建議與現實世界需求之間的差距,李方圻介紹了三種場景下的深度學習模型智慧財產權保護:所有權證明、聯邦學習和智慧財產權轉移,展示了已建立的密碼原語和人工智慧設置之間的結合,這可以構成實用且可證明的機器學習安全性的基礎。

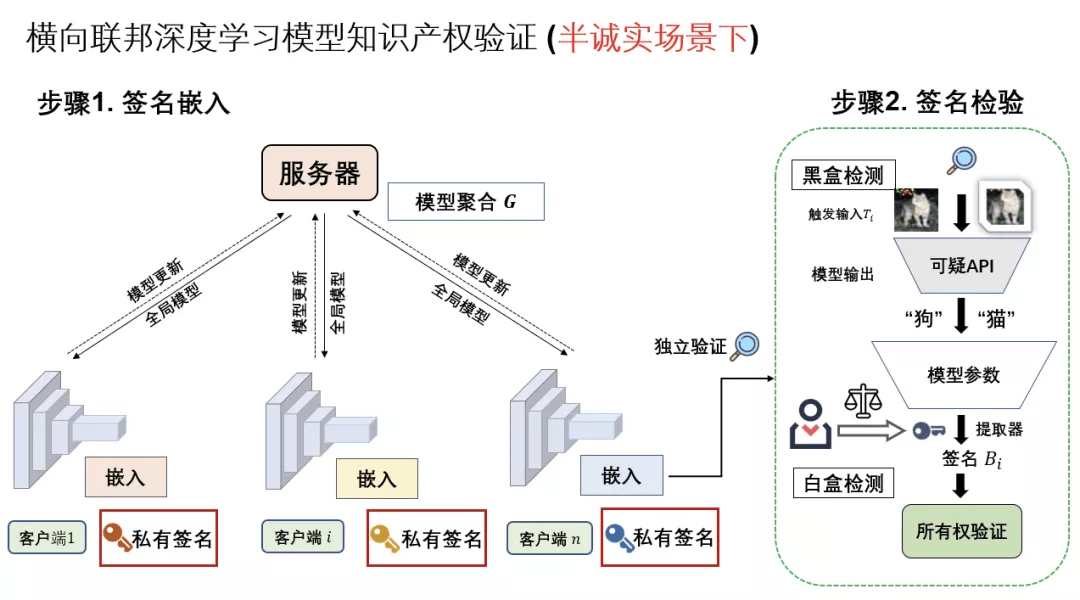

已有的深度學習模型智慧財產權保護方法主要著眼於深度神經網路水印的算法實踐和魯棒性挑戰,目前沒有把模型水印算法實踐到分布式神經網路訓練的研究。來自上海交通大學以及微眾銀行 AI 項目組的李博聞帶來了題為《聯邦深度學習模型所有權保護》的講座:考慮一個不完全信任的聯邦學習系統中,假定各參與方能夠按照聯邦法則來進行模型更新和協同訓練,但彼此不泄露私有本地數據和私密簽名。在這種設定下,李博聞闡述了一種新穎的聯合深度神經網路 (FedDNN) 所有權驗證方案,該方案允許嵌入和驗證所有權簽名,以聲明 FedDNN 模型的合法智慧財產權 (IPR),以防模型被非法復制、重新分發或濫用 . 嵌入式所有權簽名的有效性在理論上是通過證明的條件來證明的,在這種條件下,簽名可以被多個客戶端嵌入和檢測,而無需公開私人簽名。

最後,來自芬蘭 Aalto 大學的 Buse Atli 帶來了題為《Model Stealing and Ownership Verification of Deep Neural Networks》的綜合性分享。最近的一些工作表明,從技術的層面,人們暫時無法完全阻止深度學習模型竊取攻擊,不同的模型竊取檢測預防機制要麼無法對抗強大的對手,要麼對模型性能和良性用戶的效用產生負面影響。因此,模型所有者可以通過證明被盜模型的所有權來減少此類攻擊的動機,而不是防止模型被竊取本身。已經提出的各種模型水印方案被廣泛用於可靠的所有權驗證,水印深度神經網路(DNN)引起了學術界相當大的研究興趣(尤其是在圖像分類方面),因為深度學習模型水印易於部署並且對模型性能的影響可以忽略不計。並且,學術界針對 DNN 水印技術提出了許多不同的攻擊方法,從而對其魯棒性提出了質疑。

在本次演講中,Buse 介紹了針對不同模型竊取攻擊、動態對抗性水印 (DAWN) 作為對模型竊取的威懾以及聯邦學習中模型水印技術 (WAFFLE) 的相幹工作,以根據不同的安全和隱私要求對這些方法進行分析。

聚集頂尖學者,關註深度學習模型智慧財產權保護領域,DeepIPR-IJCAI’21已成為全球模型保護領域最前沿的學術動態窗口。以科技手段解決時代難題,多位行業領軍者的乾貨分享,一定能夠成為當下時代模型智慧財產權保護領域最有力的助推器。

講座視訊回顧及更多資訊可查看研討會官網或者B站