尋夢新聞LINE@每日推播熱門推薦文章,趣聞不漏接

新智元推薦

來源:metalearning.ml

【新智元導讀】Hugo Larochelle是Google大腦的研究員、深度學習領域的專家。他在最近的演講中討論了小樣本學習這個主題,概述了這個領域的一些最新進展,存在的挑戰以及研究機會。

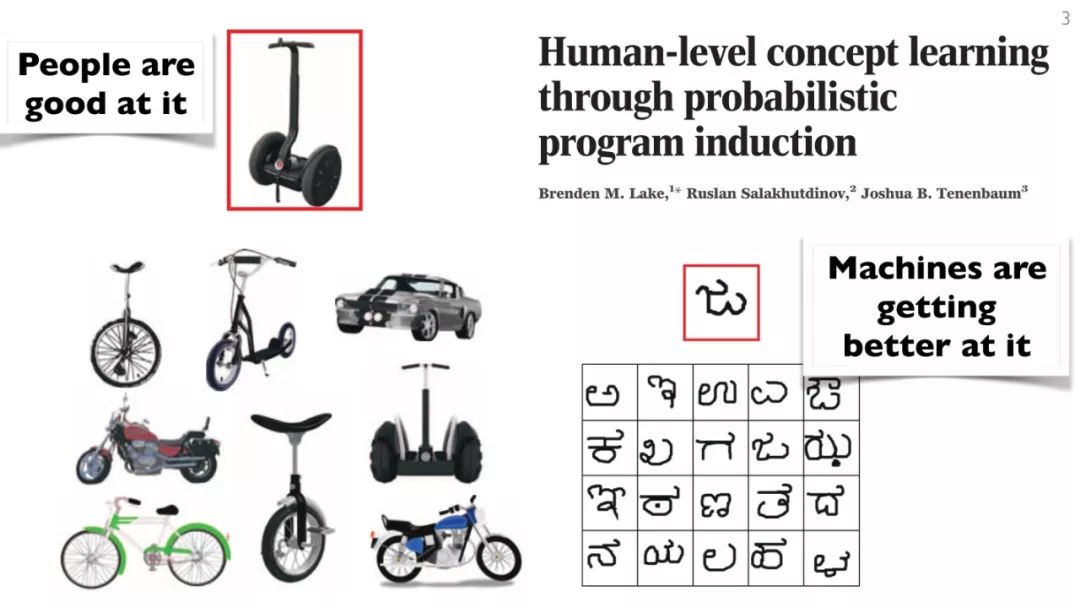

深度學習的成功部分是由於大量有標記數據的可用性。然而,即使在大數據背景下的今天,想獲取具有大量優質的、標籤正確的數據的數據集,仍是一個難題。

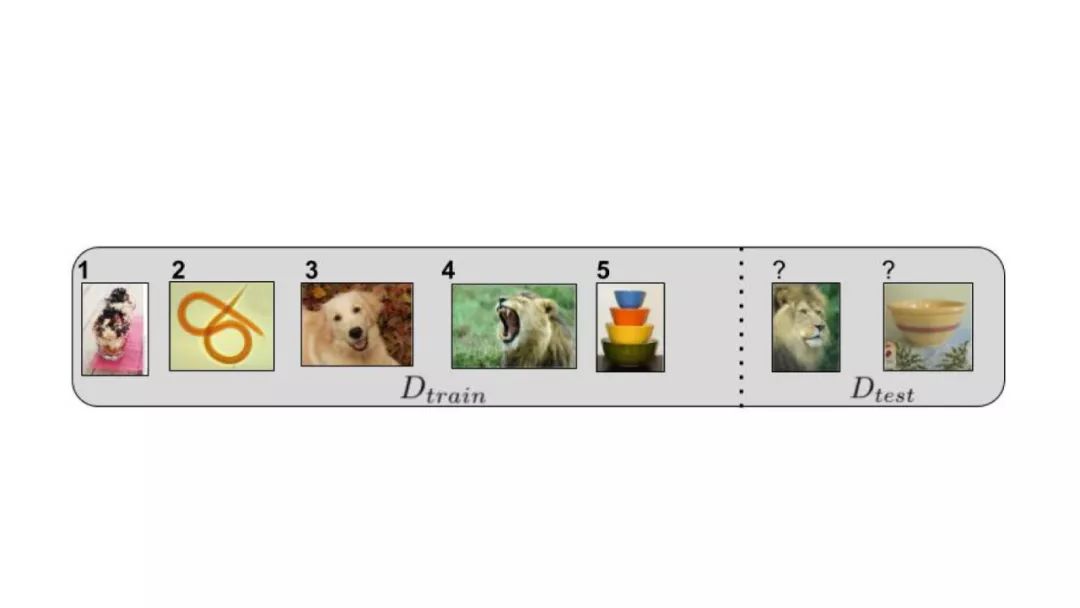

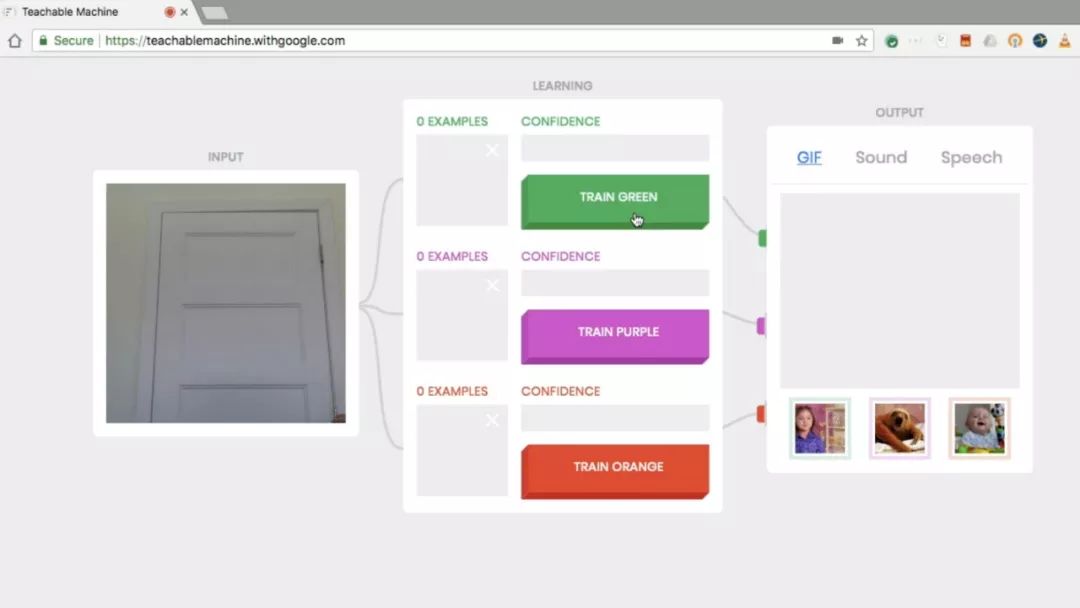

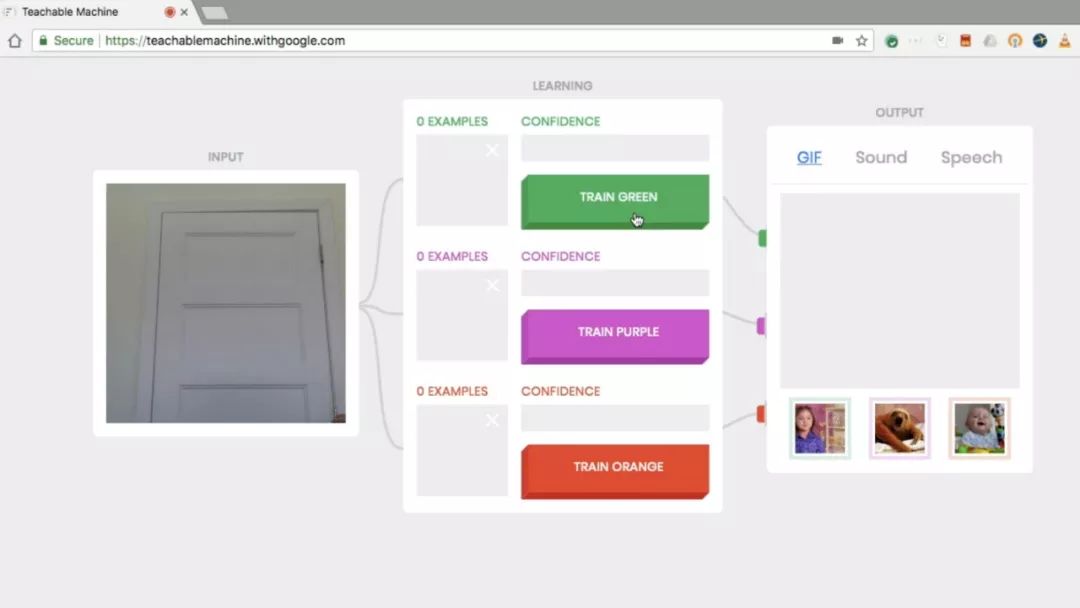

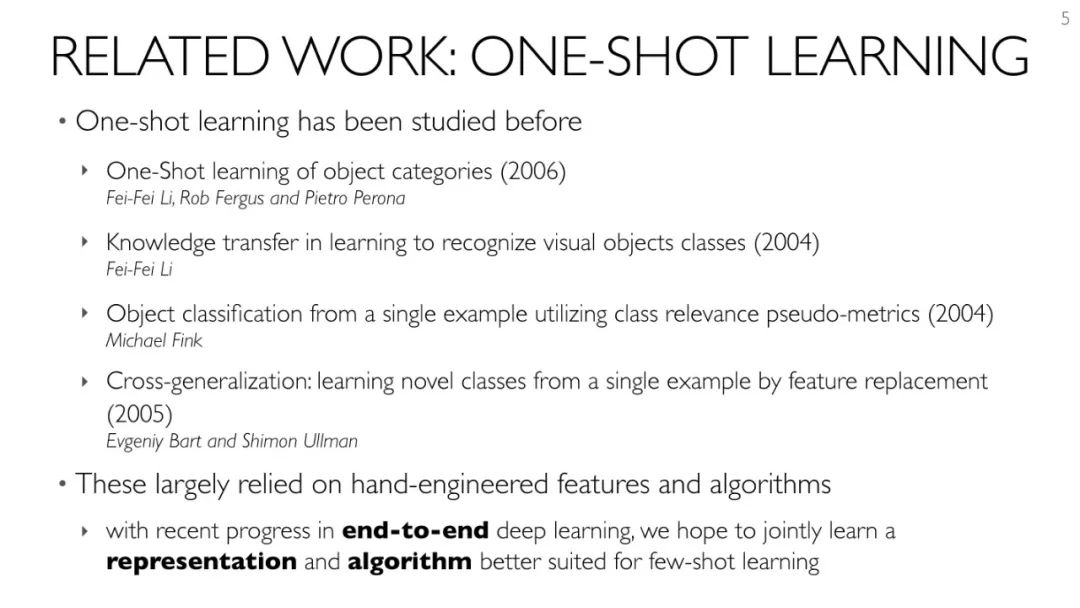

近年小樣本學習(Few-shot Learning)的發展,旨在解決這個問題。小樣本學習屬於遷移學習的一種。顧名思義,小樣本學習是一種能夠讓深度學習(或者任何機器學習算法)通過更少的樣本學習,而不像傳統的那樣使用大量樣本的技術。

Hugo Larochelle是Google大腦的研究員,深度學習領域的專家。他在最近的一個workshop中,討論了元學習(Meta-learning)這個主題。元學習是一個非常有前途的框架,用於解決從少量數據進行泛化的問題,即所謂的小樣本學習。

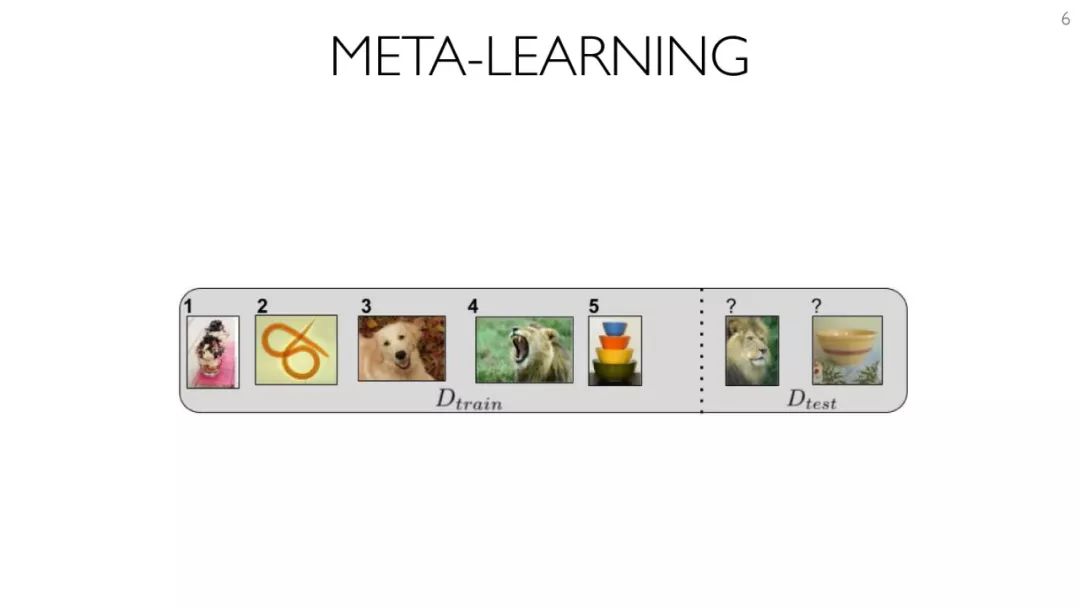

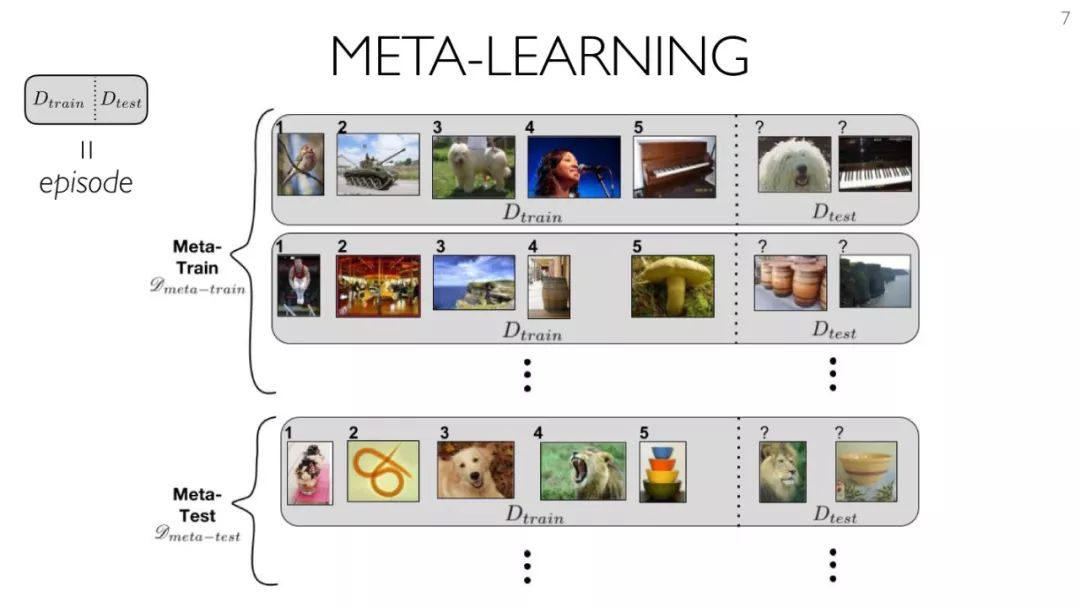

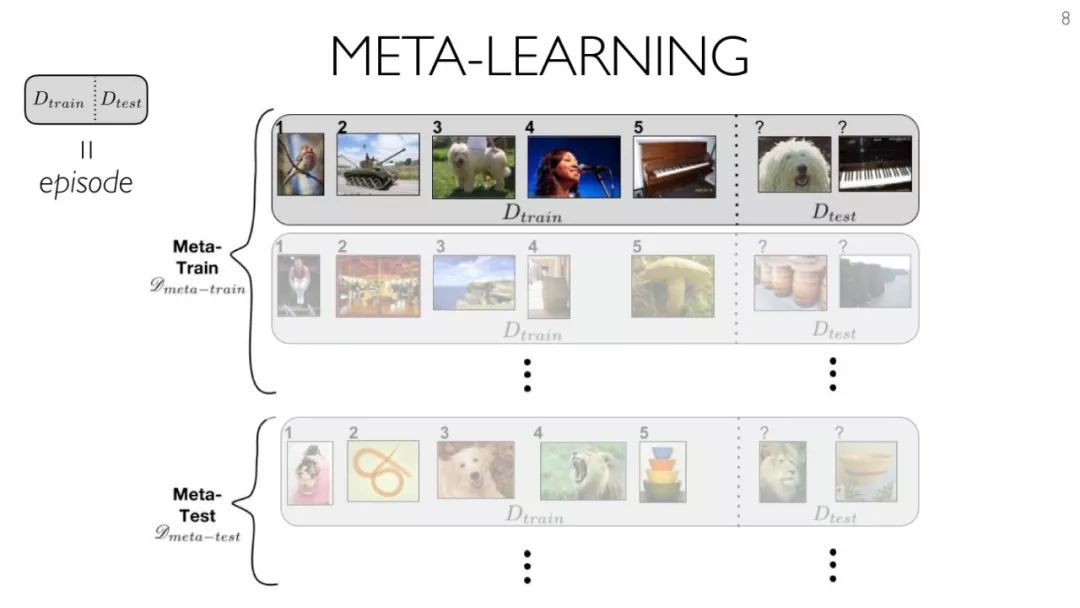

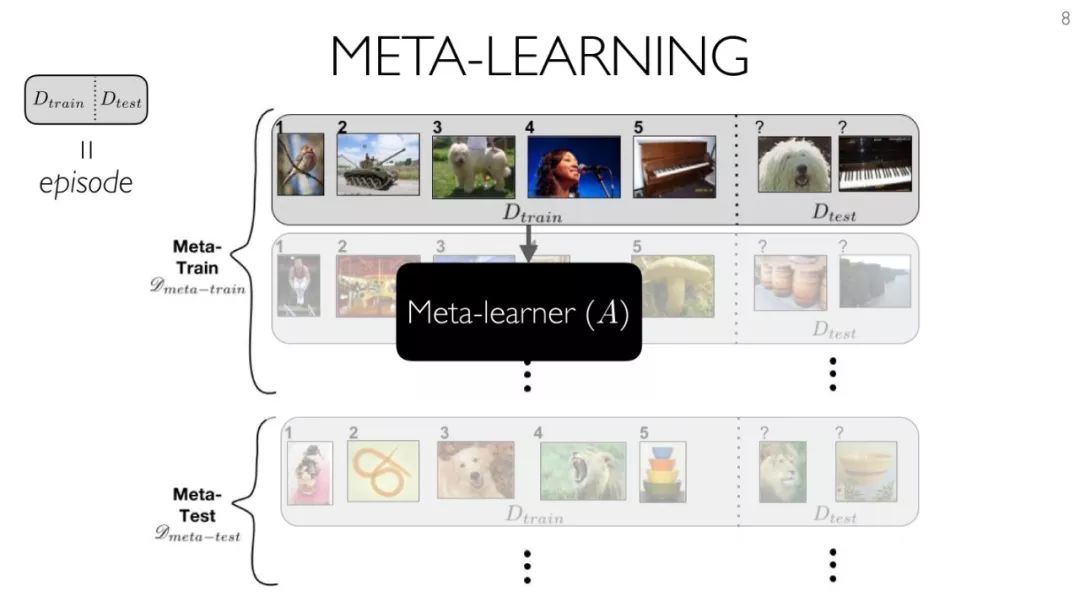

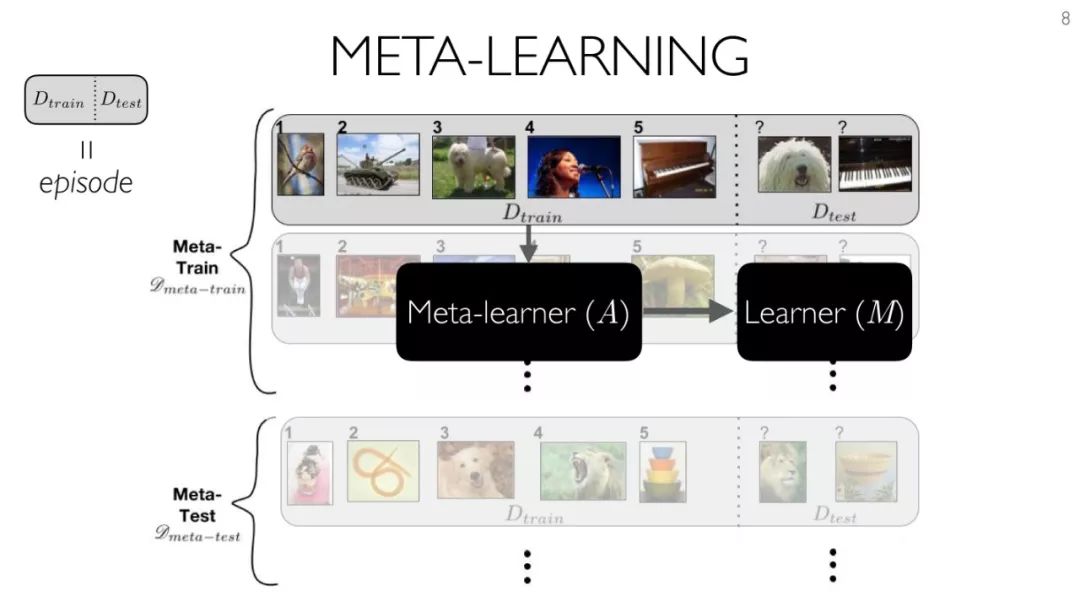

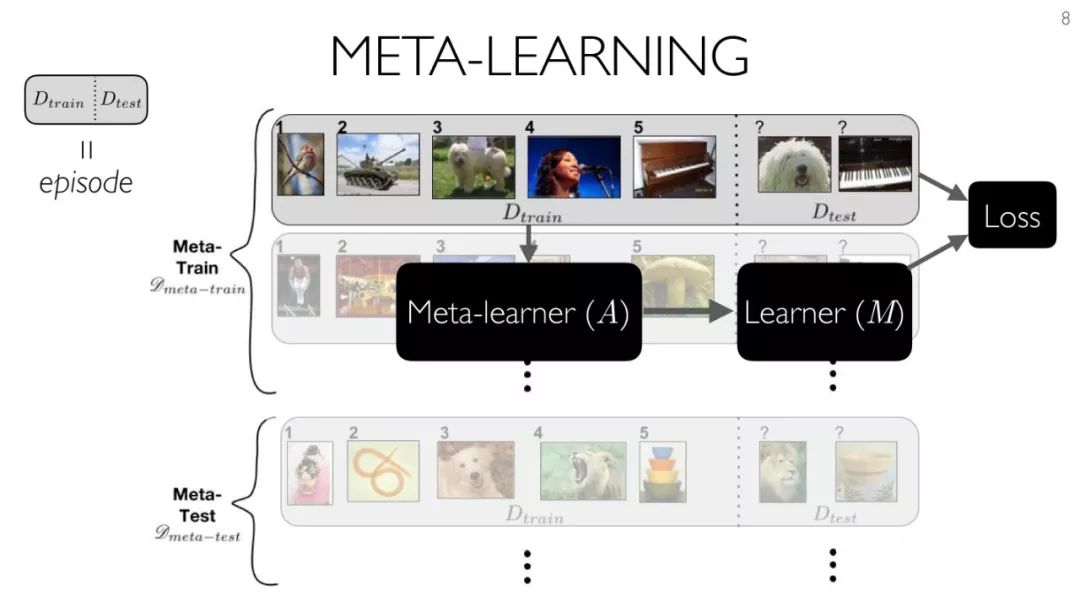

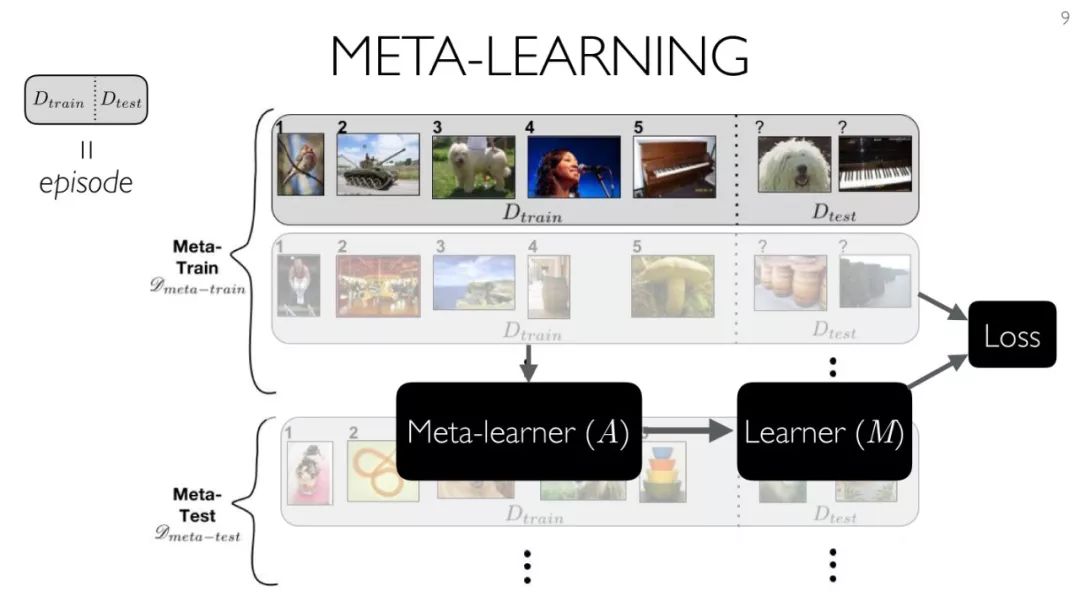

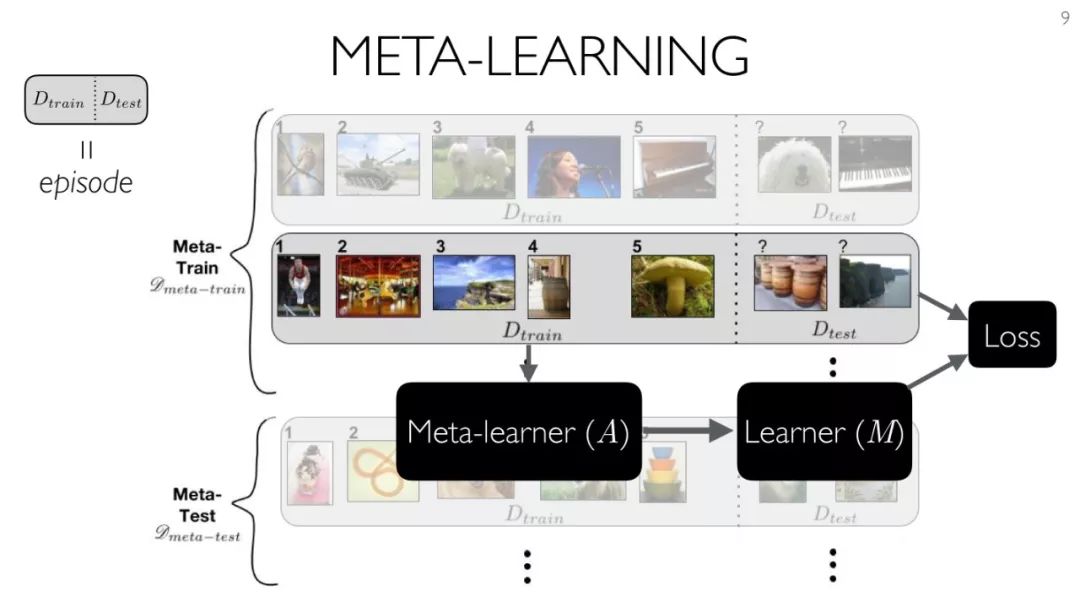

在元學習中,我們的模型本身就是一種學習算法:它將輸入作為訓練集,並輸出一個分類器。對於 few-shot learning,直接訓練產生的分類器具有良好的泛化性能,適用於只有非常少的標記數據的問題。

在這個workshop中,Hugo Larochelle概述了最近這個主題上取得的一些最新進展,並討論了仍然存在的挑戰和研究機會。

以下是Hugo Larochelle講座的PPT,文末附下載鏈接。

內容概要

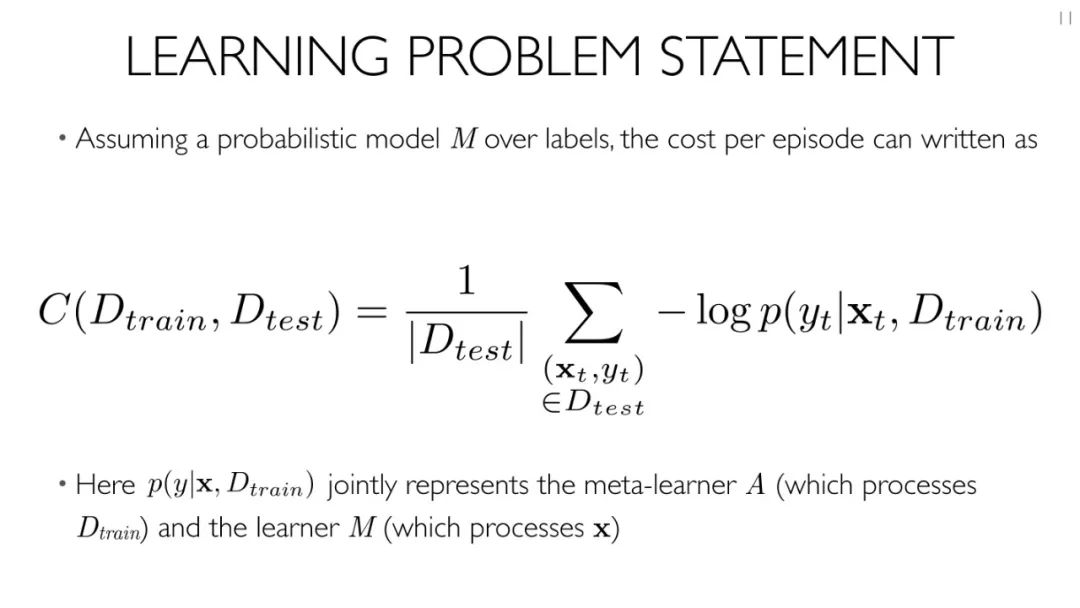

元學習(Meta-learning)

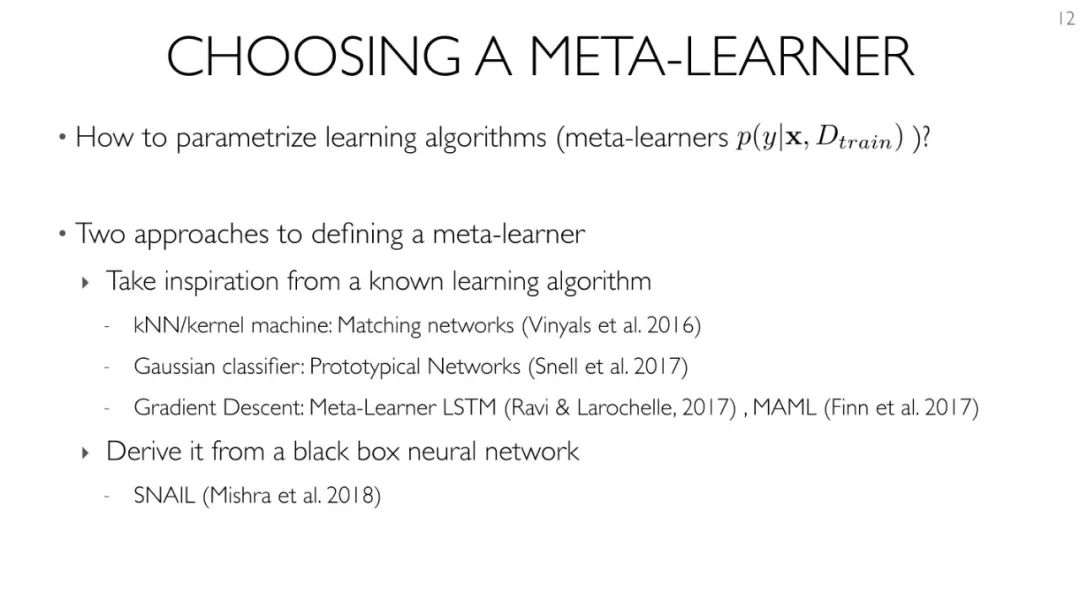

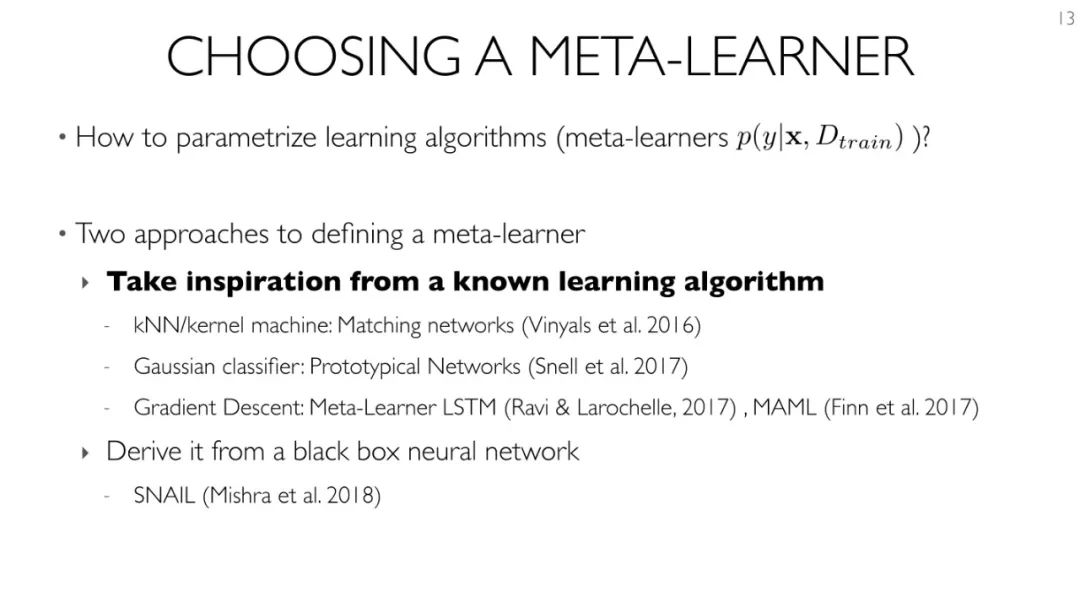

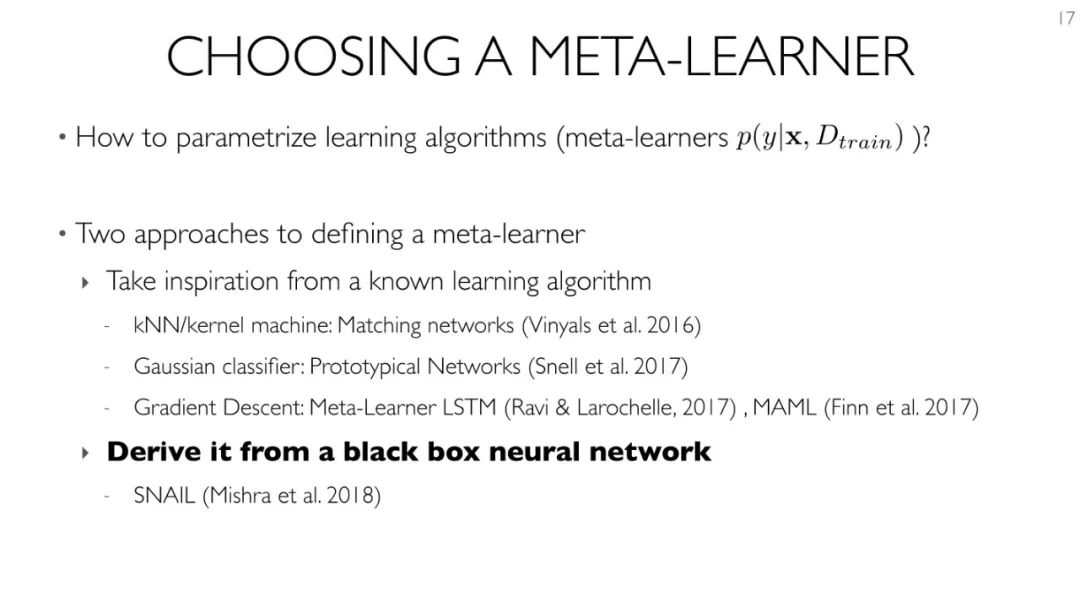

選擇一種Meta-learning

定義meta-learner的兩種方法:

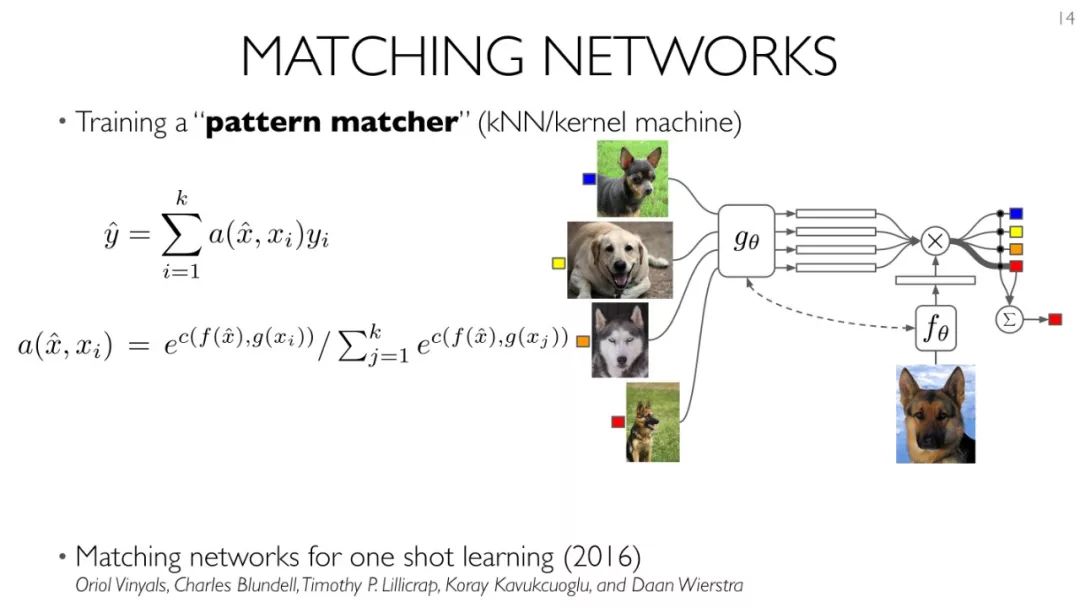

從已知的學習算法得到啟發

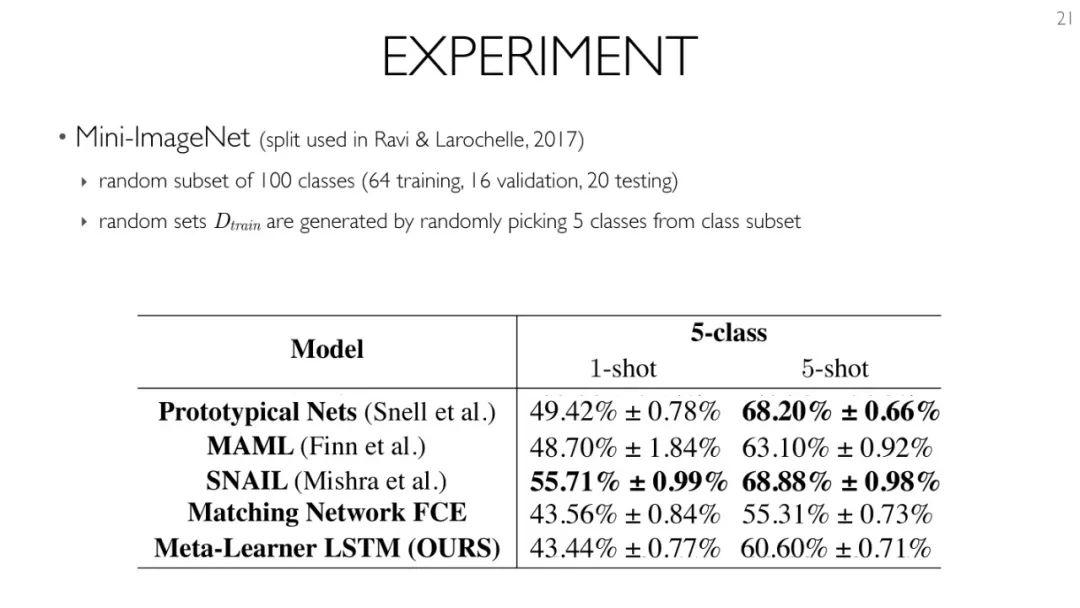

- kNN/kernel machine: Matching networks (Vinyals et al. 2016)

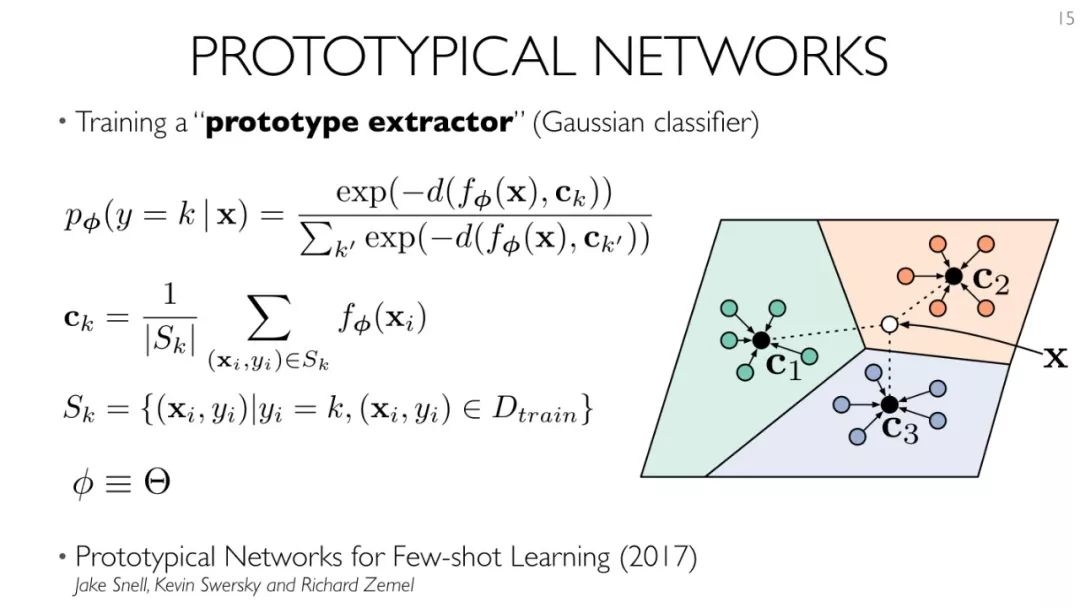

- 高斯分類器:Prototypical Networks (Snell et al. 2017)

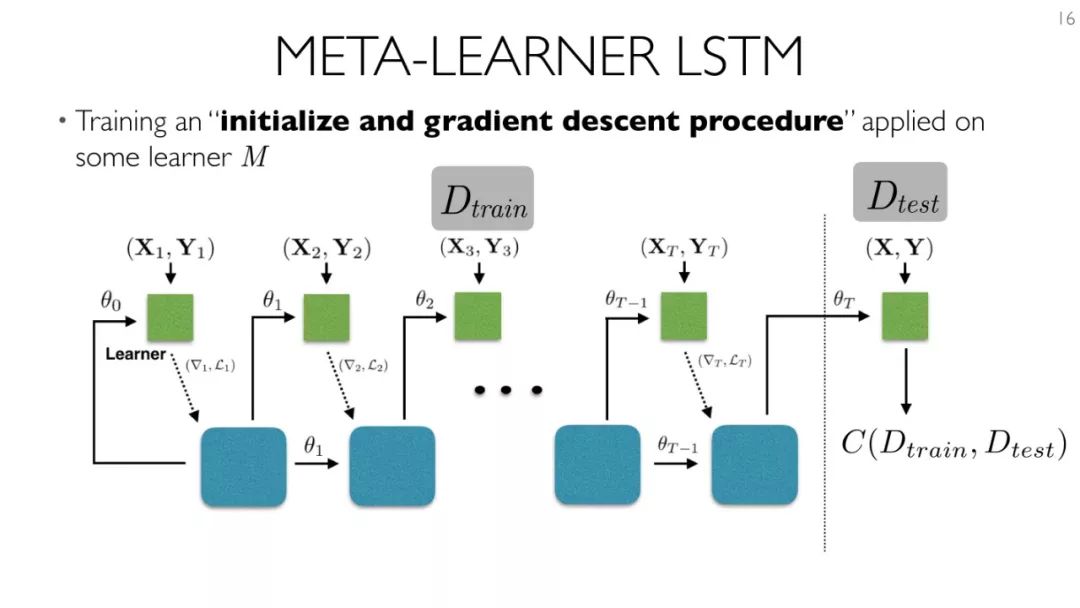

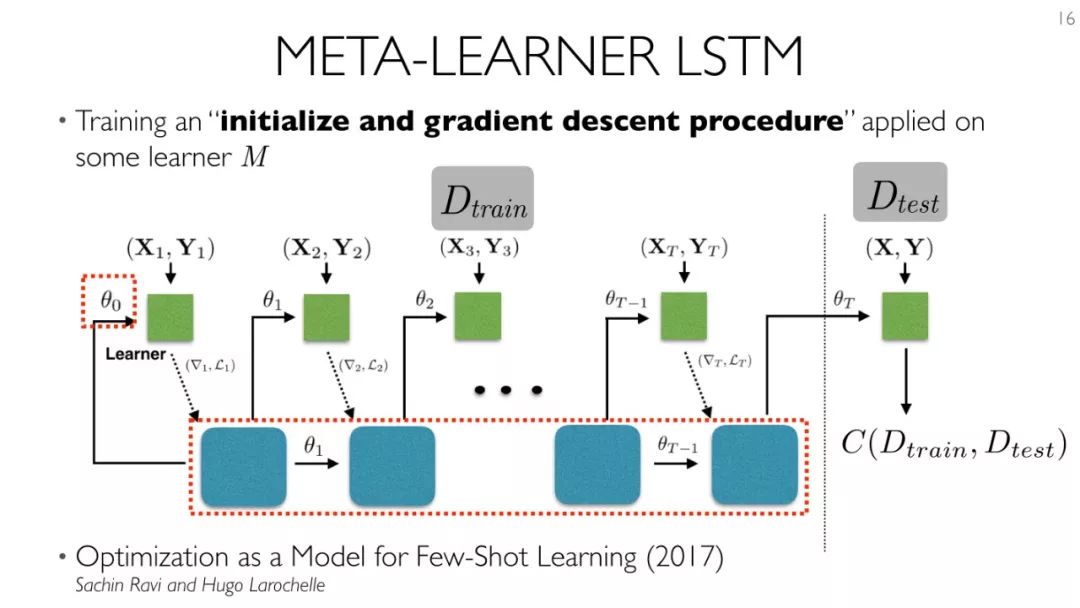

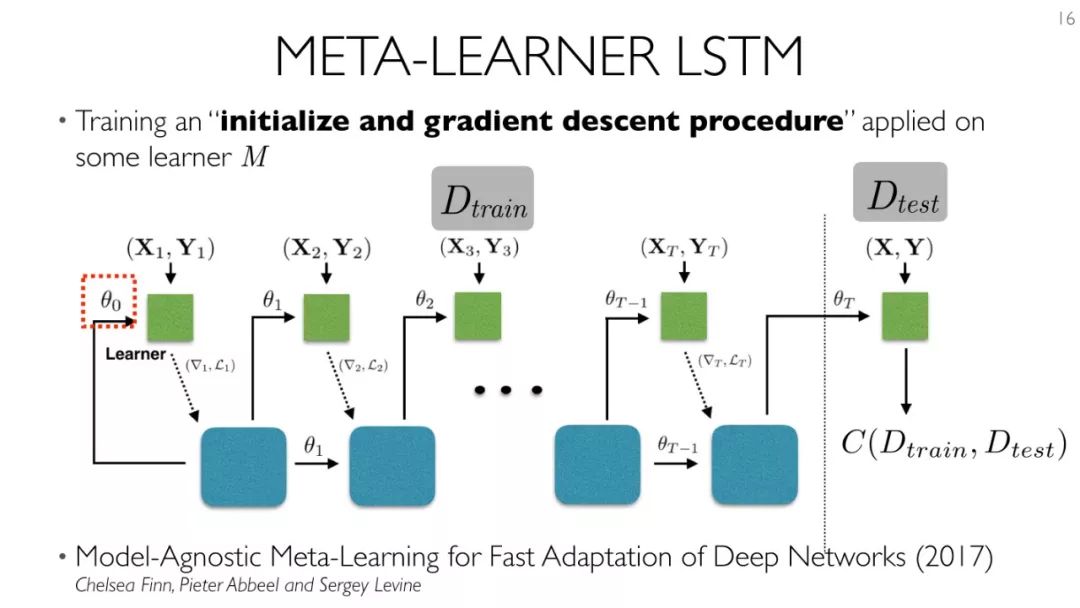

- 梯度下降法:(Ravi & Larochelle, 2017) , MAML (Finn et al. 2017)

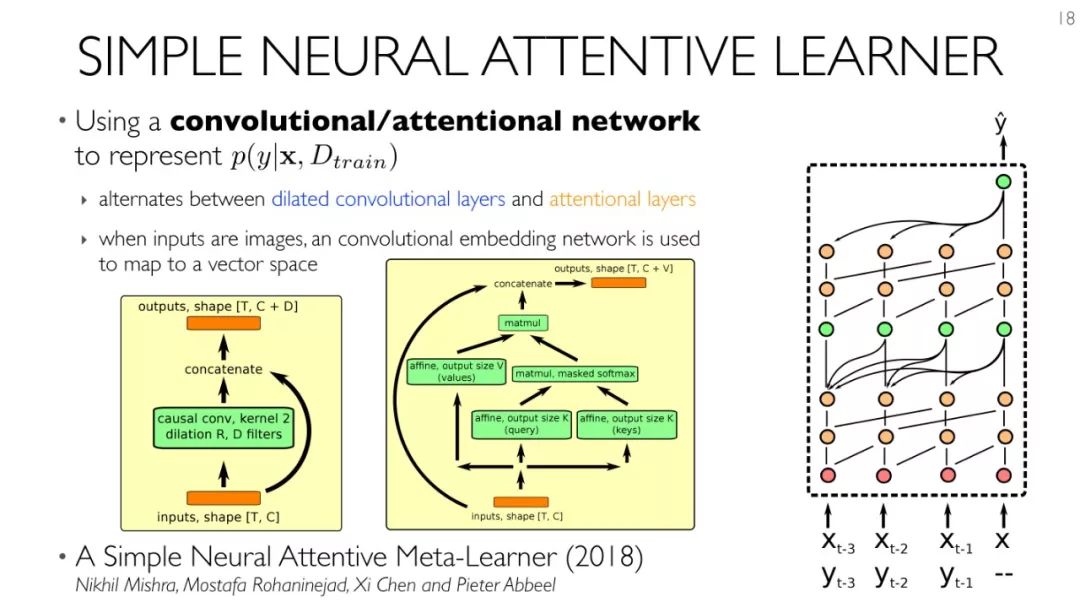

從黑盒神經網路推導

- SNAIL (Mishra et al. 2018)

存在的挑戰:

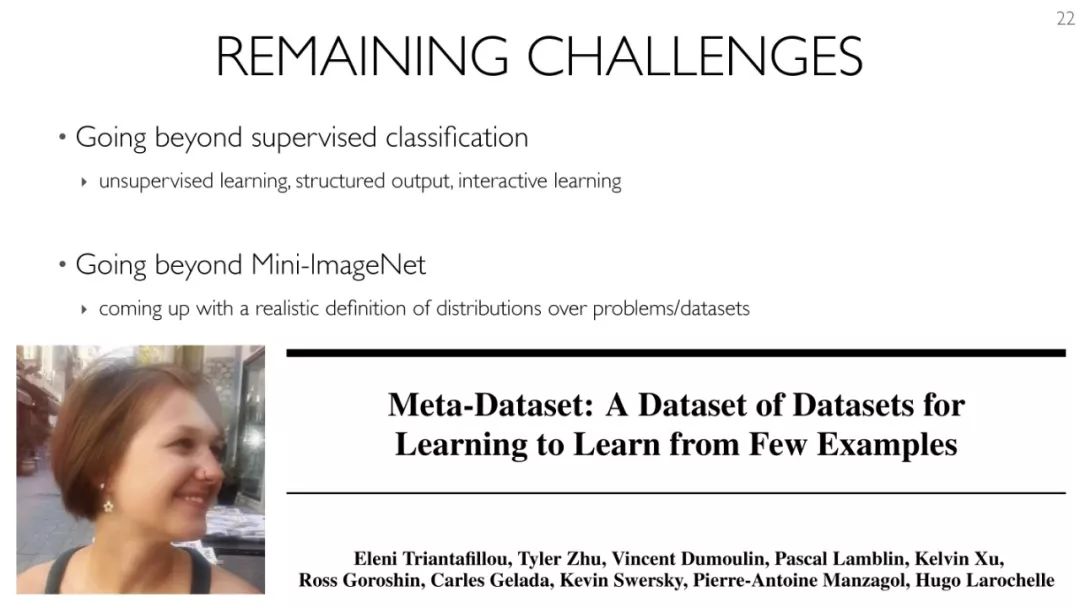

超越有監督分類

- 無監督學習、結構化輸出、互動學習

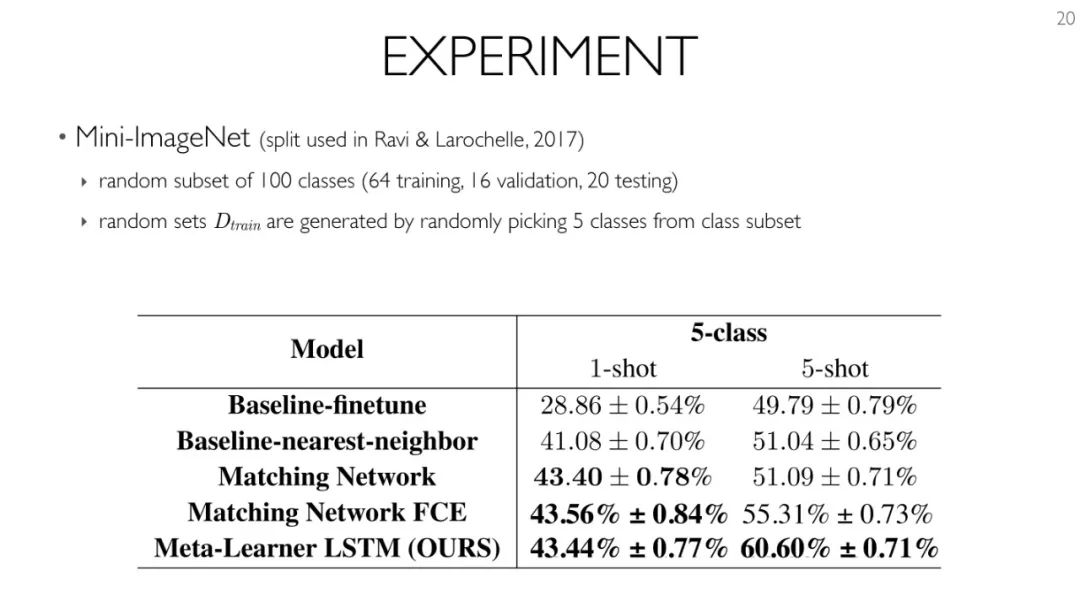

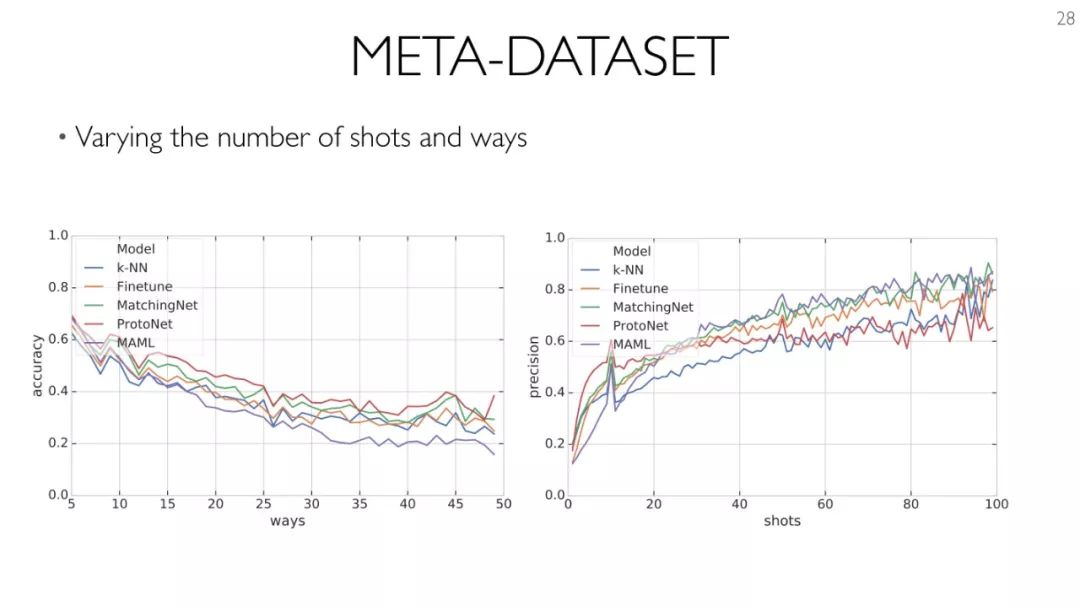

超越Mini-ImageNet

- 對問題/數據集的分布給出一個現實的定義

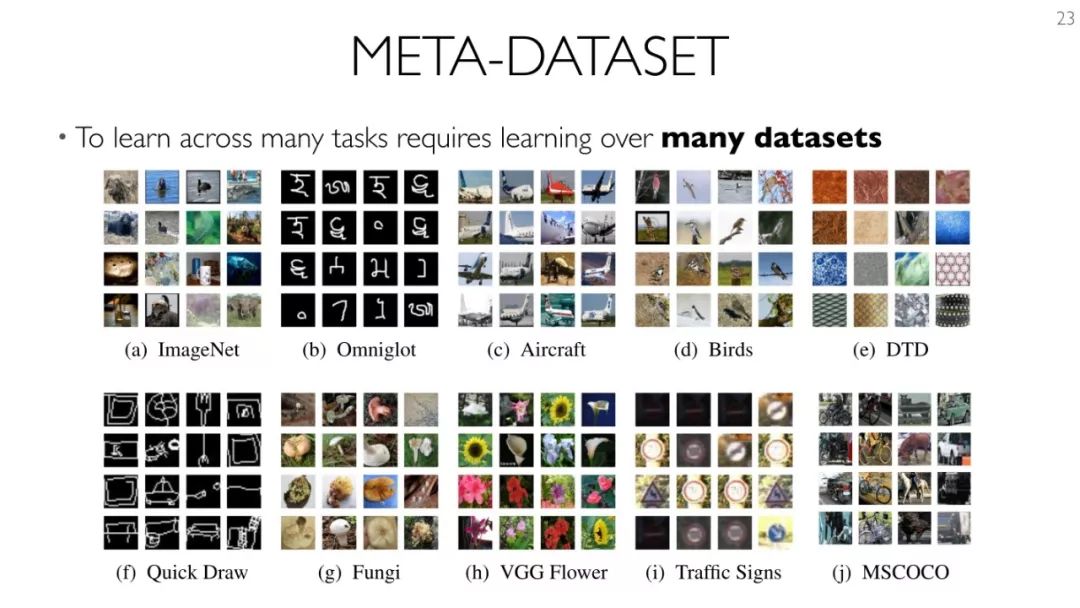

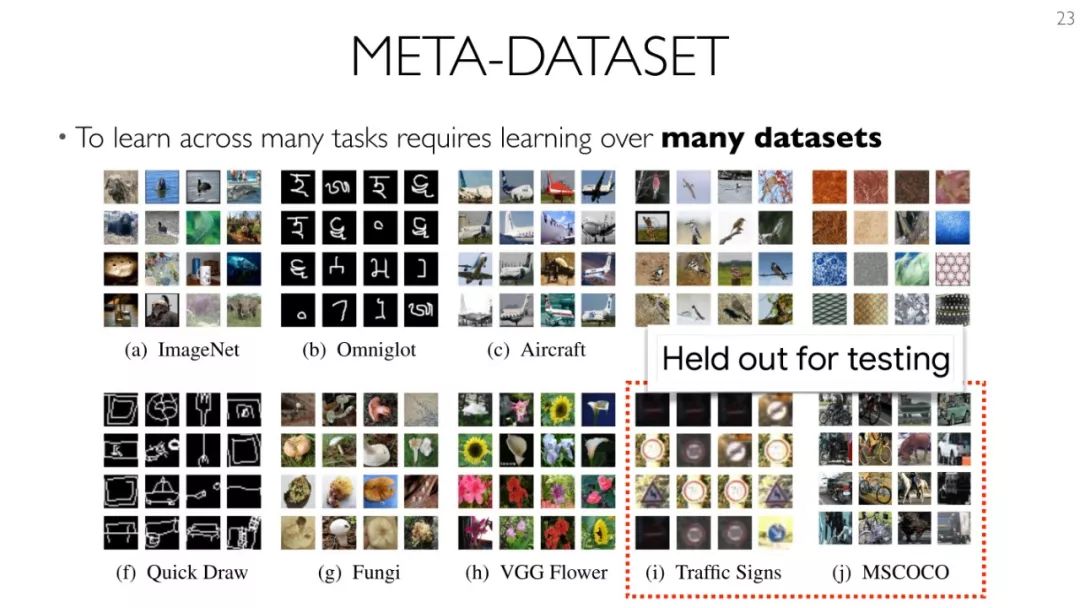

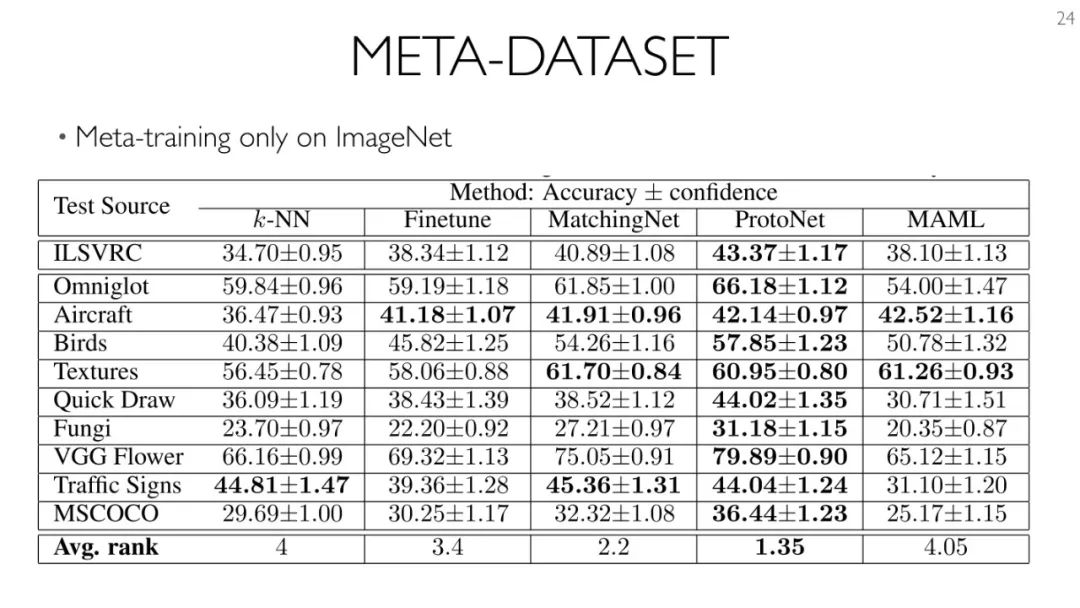

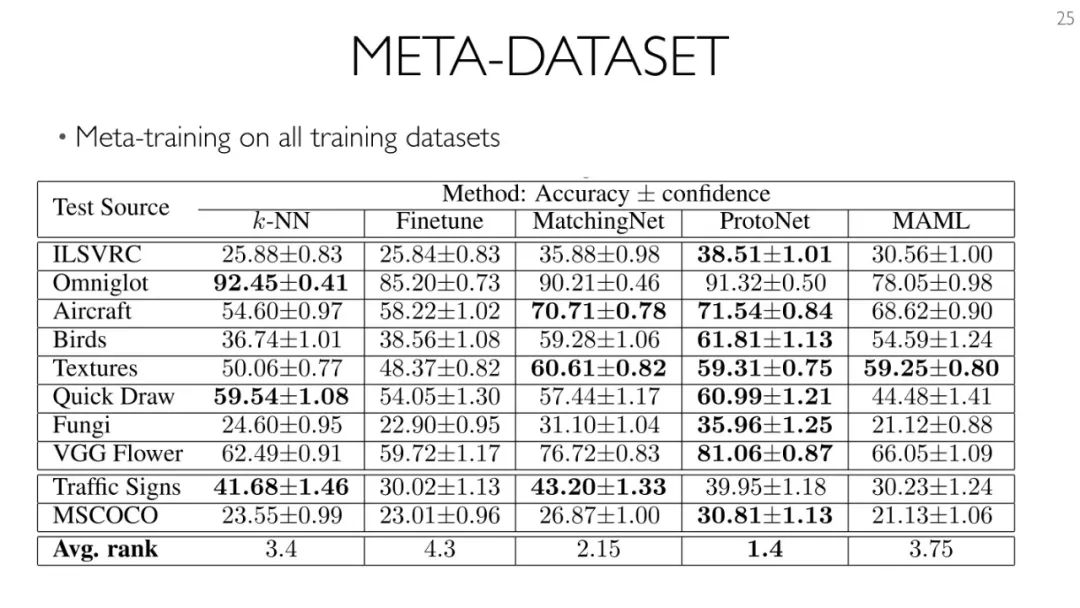

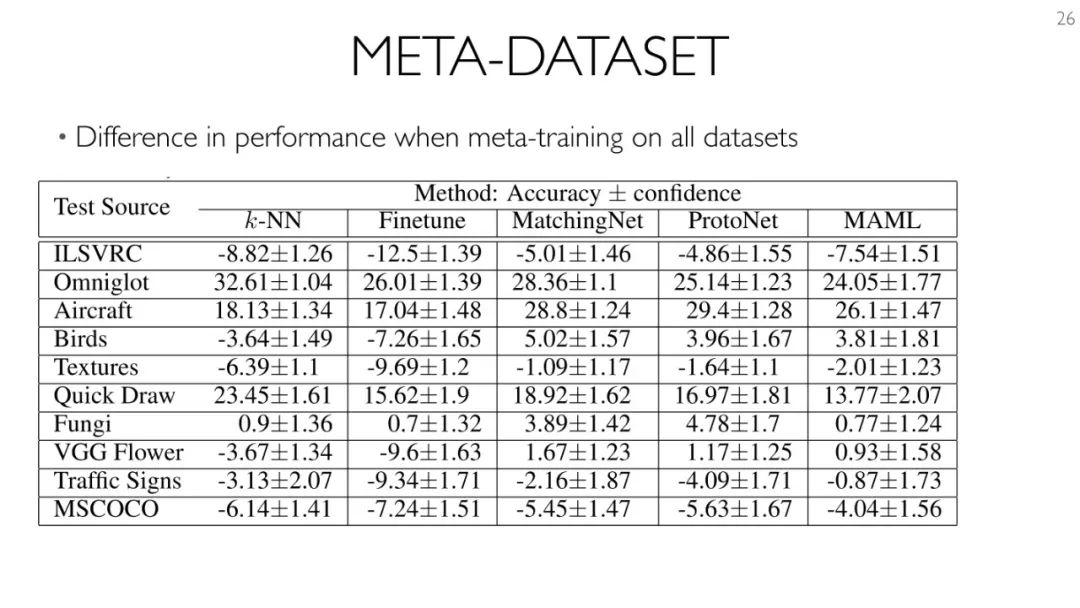

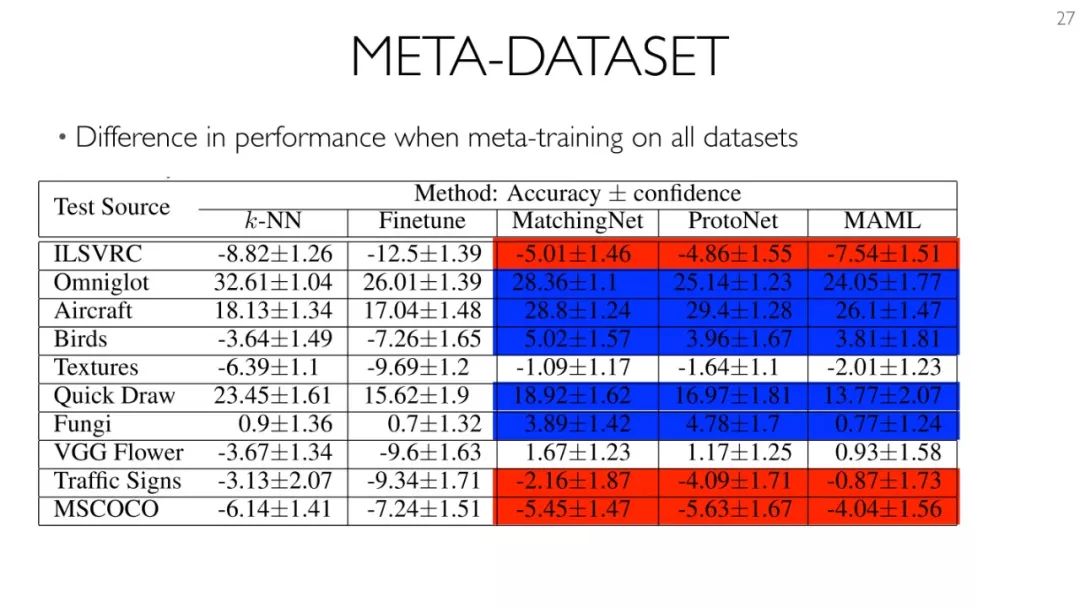

Meta-Dataset

小結:

- Meta-training 的分布可以產生很大的不同(至少對於目前的方法而言)

- 使用「常規訓練」作為初始化會產生很大的不同

- 需要調整MAML以使其更具魯棒性

PPT下載:

http://metalearning.ml/2018/slides/meta_learning_2018_Larochelle.pdf