尋夢新聞LINE@每日推播熱門推薦文章,趣聞不漏接❤️

人工智能領域的最新進展是什麼?我們可以期待 2019 年出現什麼新技術?會有新的人工智能法規嗎?NeurIPS(前稱 NIPS)或許可以對這些問題作出解答。最近,計算機網路安全公司 zvelo 的人工智能架構師 Daniel DeMillard 將其在參加 NeurIPS 2018 時收集到的一些針對人工智能領域的見解、觀點以及 2019 年的趨勢預測匯總成文。AI 科技評論編譯如下。

NeurIPS 匯聚了人工智能和深層學習領域的傑出人才,近年來隨著名氣的上升,門票一度比 Taylor Swift 的演唱會還難買(更多內容回看《聽說 NIPS 2018 門票十分鐘賣光,機器學習圈子炸了鍋》)。該會議主要聚焦於深度學習領域。深度學習是使用多層互聯的人工神經網路對高維數據進行建模的過程,其對於圖像分類、語音識別、自動駕駛汽車、臉部識別,甚至手機的拼寫自動糾正功能等方面的突破具有關鍵作用。由於深度學習已經成為近來人工智能進展的核心部分,NeurIPS 可以被視作更大的人工智能生態系統的標誌性會議。

NeurIPS 由 100 多家公司和 Google、英偉達、微軟、Facebook、IBM、亞馬遜等人工智能領域的巨頭讚助,它們都有展位,並在大會上展示最新技術進展。NeurIPS 為期 6 天,每年舉辦會議的地點各不相同——2018 是在蒙特利爾,其大會內容和論壇主要是偏技術性的。研究人員要花費數天的時間來深入研究最新課題、發表學術論文以及最終展示新技術。由於大會的三個主題(神經科學、機器學習理論和應用機器學習)的議程同時進行,一位研究者(指的是人類)不可能將所有的議程都參加和體驗一遍。這篇文章匯總了我在 NeurIPS 2018 上收集到的一些見解和觀點,以及 一些令人振奮的 2019 年趨勢預測,大家可以進行參考。

▉AI話題&啟發

今年,人工智能領域取得了許多突破,包括生成網路、無監督學習和小樣本學習、元學習和自動機器學習、增強學習,以及一些深度學習成果的理論解釋等方面的改進。

圖像、文本和語音的生成模型

生成模型對整個概率分布進行可能,從而可以生成圖像、文本或語音等新內容。預測模型在給定輸出的情況下,學習一些分類器來預測輸出標籤的概率。例如,當給定 Donald Trump 的原始像素——pr(Trump | pixels),預測模型可以預測圖像為 Trump 的概率。

不同的是,生成模型針對某些期望的輸出——pr (pixels | Trump),來學習輸入上的整個概率分布,從而能夠根據需求生成全新的 Donald Trump 圖像。遞歸神經網路用來生成文本已經有一段時間了,但是最近才在深度學習領域取得進展,改進得足以用來生成圖像。

在過去的幾年里,能夠產生真實感圖像的模型發展得很快,它們現在可以產生一些真正令人印象深刻的圖像。看看下方的幾張圖片,你能分辨出哪些是真實的,哪些是由神經網路生成的嗎?

你能猜出哪些圖像是由神經網路生成的嗎?

其實這是一個故意誤導的問題,因為它們都是算法生成的圖像

(https://arxiv.org/pdf/1807.03039.pdf)——這些人並不真實地存在。

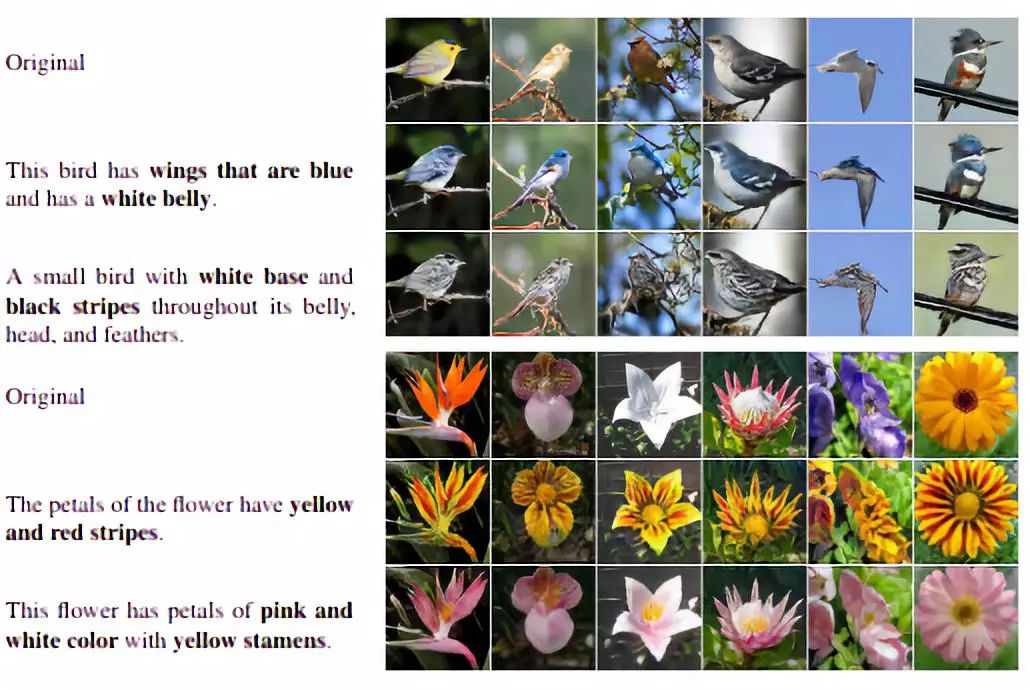

這里的許多演講都有助於推動這個領域的發展,其中就包括做到僅僅使用基於文本的描述來修改圖像(https://arxiv.org/pdf/1 810.11919.pdf)。現在,根據一個簡單的需求,就可以立即編輯鳥類和花的照片。

生成模型讓我們使用基於文本的描述就能修改圖像

這項技術非常厲害且令人興奮。然而,這些生成模型還沒有被真正投入使用,由於還沒有人真的知道用它們來幹什麼… 不過,英偉達在本次會議上展示的 Demo 可能已經開始填補這一缺口了。他們展示了一個用戶對街道場景進行導航的虛擬仿真,該街道場景不是由圖形或視頻遊戲設計師生成的,而是完全由從現場拍攝、然後拼接到一個連貫的 3D 場景中的圖像生成的。

2019 年趨勢預測

公司將使用生成模型來為購房者、博物館參觀自動生成數字化演示,甚至為電子遊戲生成內容。

以更少的標籤學習(以及完全不使用標籤學習)

無監督學習是人工智能的長遠目標。我們往往擁有大量的數據,然而這些數據都是沒有經過標記的。這意味著,除了基本的數據勘探和異常檢測場景,這些數據基本無法使用。遺憾的是,這個問題在 2018 年仍然沒有得到解決,並且在近期內無法解決。不過,這一領域至少在使用未標記的數據來改進(標記數據)監督學習過程方面已經取得了許多進展。

最近一篇題為《無監督神經機器翻譯》(Unsupervised Neural Machine Translation,https://arxiv.org/abs/1 710.11041)的論文表明,無監督學習有助於機器翻譯。給定語言中擁有豐富的文本,所有書籍、博客和信件都可以以你喜歡的任何語言存在,問題是你需要使用平行的句子來展示,深度學習算法如何將原文本(例如法語)的詞語直接標記為目標語言(例如英語)。對於一些特定的語言對,例如斯瓦希里語—老撾語,這些數據太過缺乏且難以獲得。這篇論文展示了,通過在單語料庫上訓練編碼器和解碼器間的共同嵌入空間,可以學習一種弱形式的無監督翻譯。盡管直接的無監督翻譯表現不是很好,但是學習到的共同嵌入可以大大加快監督模型的訓練,從而用更少的標記的句子和更少的訓練就可以提高精度。

會議上的許多演講和論文,都在繼續使用這種思路:以數量更少的標記樣本來獲得最高精確度。其中幾個案例包括:使用少量的音頻記錄來將轉移學習用於克隆語音,以及使用更少得多的樣本來做到每一類別的目標檢測。

2019 年趨勢預測

雖然使用無監督學習直接學習新信息這一方面沒有取得建設性的突破,但是無監督預訓練、遷移學習以及少量學習都加速了在新領域的訓練,也有助於控制學習精確的分類器所需要的訓練時間和樣本數量。

自動機器學習和元學習

當今的趨勢是「解放雙手」,而這一趨勢的點點滴滴都涉及到深度學習,如神經網路架構和超參數調優。元學習致力於「學會如何學習」,然後將學習能力遷移到其尚未涉足的新領域。雖然元學習仍然是一項正在發展中的工作,但是自動機器學習正被有效地應用於快速地完成比窮舉網格搜尋(brute-force grid search)更高效的超參數搜尋,以及自動學習特別的聯結主義架構。甚至最近為自動機器學習發布的常用的 scikit-learn(https://scikit-learn.org/stable/)中也擁有了一個可直接使用的插件。

2019 年趨勢預測

機器學習研究者花在用不同的超參數反復試驗的時間會變少,而是使用自動機器學習所提供的工具去運行單個的實驗。這將加速研究周期,從而讓研究者可以探索更多的課題。

深度學習理論

深度學習模型往往會被喻為「黑盒子」,這是由於深度學習模型現在包含了萬億個以複雜方式關聯的參數。即使是創建了這個模型的研究者,也難以對正在發生的事情進行全面的理解。深度學習其中的一個吸引力就是研究者不一定要手動創建特徵,甚至不需要完全了解他們正在應用算法的領域。我們能非常真切地感受到,比起研究者們,深度學習模型其實更了解正在被解決的問題。

這展示了研究者們對於自動駕駛汽車、醫療影像以及金融交易等關鍵任務系統的關注。

如果我們不知道機器是如何進行工作的,我們能真正說它是安全的嗎?這就是為什麼要在深層學習背後的理論上取得進展如此重要的原因。本次會議上的許多演講和論文就聚焦在了這一領域。

《關於神經元容量》(On neuronal capacity)是一場非常有趣的演講,它從數學上表明了不同尺寸的前饋神經網路可以存儲多少位。這些知識可以用於了解抽象和在神經網路中產生的記憶的各自的水平。例如,20000 張彩色像素為 256×256 的圖像,擁有約為 10 億(20000X2 56X256X3)條信息。如果這個值與網路的神經容量相當,那麼這個模型就太大了,僅通過簡單記憶數據就會使這些數據過度擬合,並且該模型也很難適用於樣本外測試集。研究者在選擇其網路的大小時可以利用這些信息。

此外,《關於詞嵌入的維度》這場演講為在深度學習社區異常大的嵌入大小給出了理論解釋。這些解釋有助於正確地選擇嵌入大小等超參數,而無需高成本的經驗搜尋。

我們甚至有一個神經科學解釋,解釋反向傳播是如何在大腦中發生的。長期以來,人們一直批評深層學習神經網路不能真正模擬大腦中的連接,這是由於使用了反向傳播,這是一種通過網路的權重將分類器中的錯誤傳遞回去的方法。然而,最近一篇關於神經科學的論文概述了一個模型,該模型可以解釋反向傳播類過程是如何在大腦中發生的。這可能為那些相信他們的算法的智能類似於人類智能的人工智能研究人員提供一些撫慰。

強化學習

強化學習(RL)是用於解決遊戲、金融市場和機器人技術中常見的順序決策問題的方法。今年,許多關於強化學習的演講都集中在數據效率這個方面。應用於國際象棋、圍棋、 atari 以及最近的 Dota 等遊戲中的「策略網路」,已經取得了驚人的突破。然而,這些方法都需要大量的資源來模擬遊戲的數百萬次迭代。

對於強化學習主管者 Google 旗下的 DeepMind 等發表的諸多論文,一般的 AI 研究者都無法對其復制,因為他們無法使用 DeepMind 所擁有的成百上千的雲端 GPU。這就是為什麼研究者致力於開發不僅能玩好遊戲,而且可復制、可循環利用以及穩健的強化學習算法。對此,模型必須進行簡化並且變得更加的「數據高效」,這就意味著要求使用更少的仿真迭代(更少的數據),最終得到準確的模型。

2019 年趨勢預測

通過自對弈的方式(無真實世界的例子)自主學習以超人類的水平下圍棋、象棋以及 Shogi 的 DeepMind 算法——AlphaGo Zero,將會被研究社區復制,並且研究者們可以在單個的消費級 GPU 上訓練該算法的某個版本。強化學習算法將開始在星際爭霸(Starcraft)和 多塔(Dota)等更為複雜的現代競技遊戲中打敗人類。

對話式聊天機器人 VS 目標導向的虛擬助手

我參加了「第二屆會話式人工智能論壇:今天的實踐和明天的潛力」(The 2nd Conversational AI Workshop: today’s practice and tomorrow』s potential)。這個論壇對「對話式聊天機器人」和「目標導向的虛擬助手」進行了清晰的描述。對話式聊天機器人包括社交機器人,它們可以就各種領域進行對話,除了可以讓用戶始終參與之外往往沒有目標。一個對話聊天機器人的例子是微軟的 twitterbot Tay 及其第二代 Zo。然而,目標導向的虛擬助手則是聚焦於完成一些預先設定的任務,這類助手包括亞馬遜的 Alexa、蘋果的 Siri、微軟的 Cortana 以及自動化的幫助中心機器人。

對話式聊天機器一直以來都更難創建得多,因為響應的類型是多種多樣的,並且取決於上下語境,甚至與其對話的用戶。這個論壇展示了對話式機器人和虛擬助手的最新進展。

二者遵循與上述技術相似的發展路線。無監督學習、強化學習和記憶網路的改進減少了重復,增強了信息檢索和對語境的理解能力。

2019 年趨勢預測

2019 年,我們還無法成功研發對話式聊天機器人(你可以這類聊天機器人交談任何事情,它的聲音聽起來像人類一樣),不過會有更多水平高的虛擬助手出現,它們可以在人類進行網上購物、車輛預定、與商場導購互動以及參與支援呼叫中心等活動時提供幫助。越來越多的應用設備將會採用語音控制,我們僅用聲音就可以控制烤箱或者大門(而不需要將其連接到 Alexa 上)。

▉擔憂

今年,大家也對 AI 提出了許多擔憂,包括防護、安全、歧視性偏見以及 AI 研究者缺乏包容性和多樣性等。如果企業無法進行自我監管,這些擔憂可能導致監管反彈。

圖像分類器的對抗性攻擊

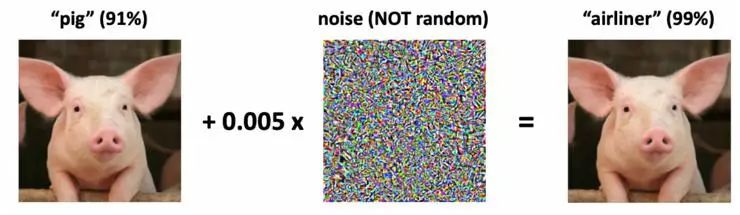

我數了一下,有將近 12 篇論文是關於深度學習模式的「對抗性攻擊」的。對於它們不熟悉的圖像,這些攻擊傾向於集中在圖像分類算法上,並試圖通過向圖像的像素值添加小擾動,來欺騙分類器。

例如,將適量的噪聲添加到「豬」的圖像後,該圖像會發生改變,從而誤導深度學習模型將其歸類為「飛機」。

乍一看,這似乎是一種無害的科學怪癖。然而,想到臉部識別正成為智慧型手機登錄等安全授權的越來越重要的部分。研究者已經表明,通過簡單地更改圖像周圍的像素,分類器可以將你認作其他人。當然,人類可以馬上判斷出某些事情是錯的,但是欺騙自動系統就像戴上某款時髦的數字眼鏡一樣簡單。

或者想一下這對於自動駕駛汽車來說意味著什麼。讓自動駕駛汽車變得可行的許多突破,都來自於深度學習圖像分類器,它能夠準確地讀取路標、檢測行人以及解譯信號。研究已經表明,通過簡單地將黑色帶和白色帶適當地貼在路標上,可以讓這些分類器被「打擾」,從而進行錯誤的分類。

創建不受此類攻擊影響的模型,對於保障人們的安全和防護至關重要。幸運的是,現在已經有許多方法可以構建這些能夠進行自我防衛的模型,例如正則化、數據增強、對數據來源進行警惕(詳細見含毒數據https://arxiv.org/abs/1804.00792)、向模型添加可解釋性、收集更多數據以及構建新型檢測器等。構建不受攻擊的模型的結果是,泛化也得到了改進,這就意味著模型將對與初始訓練集不同的數據進行處理,同時總體的準確性也得到提高。遺憾的是,盡管在創建不受攻擊的模型方面已經取得了許多進展,但並不是每個人按照這一最佳實踐來創建 AI 模型。

2019 年趨勢預測

對於生物識別安全,人臉識別將變得越來越重要。例如,我們會用臉部識別來登錄銀行帳戶。今年,公司將無法採用適當的預防措施來使其網路不受「對抗性攻擊」的影響,並且有人將會成為這種欺騙活動的受害者。

機器學習中的固有偏見和歧視

今年,人工智能所經歷的另一反彈來自於模型,這些模型顯示出了種族和性別歧視。在無法充分代表少數群體以及數據無法提供準確快照等有偏見的數據集上訓練過的模型,已經證實會犯明顯的錯誤,並且不利於針對一個群體。這個問題是雙重的:第一個問題是,當算法正在進行應該批准誰貸款、應該選擇誰來參加面試、甚至確定犯罪活動等關鍵決策時,可解釋性和透明性往往是必要的;第二個問題是,由於缺乏公平性和責任制,不平衡和不完整的數據集最終會把某一些群體孤立起來。

有了龐大的人臉數據庫和不完美的分類器,很容易為與犯罪完全無關的人的肖像找到匹配。美國地區的人臉識別,由於數據集以白人目標為主要特徵,具有嚴重的偏見,其對非洲裔美國人的識別表現更差,並且對亞洲人的識別要比白種人更差。同樣地,亞洲分類器的這種偏見是相反的,由於它們在其數據集中具有相反的偏見。

AI 研究者不是倫理學家,也不應該是公平、對或錯的最終決定者,他們應該做的是努力將責任制、透明性以及可解釋性增加到模型中。遺憾的是,這是正是黑盒深度學習模型最大的弱點之一。它們都是能夠完成表現非常驚人的分類的非常強大的算法,不過在很大程度上仍然難以捉摸。

現在有一些方法可以解決這個問題,例如給因素重要性分析增加特定的特徵,執行消融學習(ablation studies)以及對歧視性偏見進行顯性測試(例如對黑種人和白種人的人臉測試集進行 A/B 測試)。然而,這個問題仍然是一個挑戰,並且至今還沒有一個簡單的解決方案。如果 AI 公司無法對這一問題進行自我監督,那麼隨著公民權受到侵犯,會出現監管反彈。

2019 年 趨勢預測

未來,投訴機器學習模式具有歧視性以及違反了反歧視法律的訴訟數量將會增多。深度學習模型很大程度上仍將保持難以捉摸的特點,但監管壓力、安全性擔憂以及理論進展,會促使研究者將會花更多的時間和資金來提高深度學習模型的可解釋性和透明性。

▉提要&總結

人工智能領域在 2018 年取得了許多驚人的突破;到 2019 年,既有機遇,也面臨的許多挑戰。毫無疑問,未來還會有更多的驚喜,但我希望我們能夠繼續以謹慎和肩負社會責任感的方式,推動技術的發展。

來源:雷鋒網(版權歸原作者及刊載媒體所有)

薦讀

編輯 / 孫浩南審核 / 王欠鑫 孫浩南