尋夢新聞LINE@每日推播熱門推薦文章,趣聞不漏接❤️

蕭簫 發自 凹非寺

量子位 報導 | 公眾號 QbitAI

還記得去年12月, Jeff Dean在網上成為「千夫所指」嗎?

當時Google一名員工 Timnit Gebru準備發表一篇AI倫理論文,結果雙方內部評審上存在著嚴重分歧,Jeff Dean就把她開除了。

這篇論文指出了大語言模型訓練時,造成的碳排放量和能源消耗量過於巨大,還談到了GoogleBERT在AI倫理上的負面影響。

不到幾天,已有1400名Google員工和1900名AI學術圈人士對Google的行為表示訓斥,一向口碑不錯的Jeff Dean,也因此成了眾矢之的。

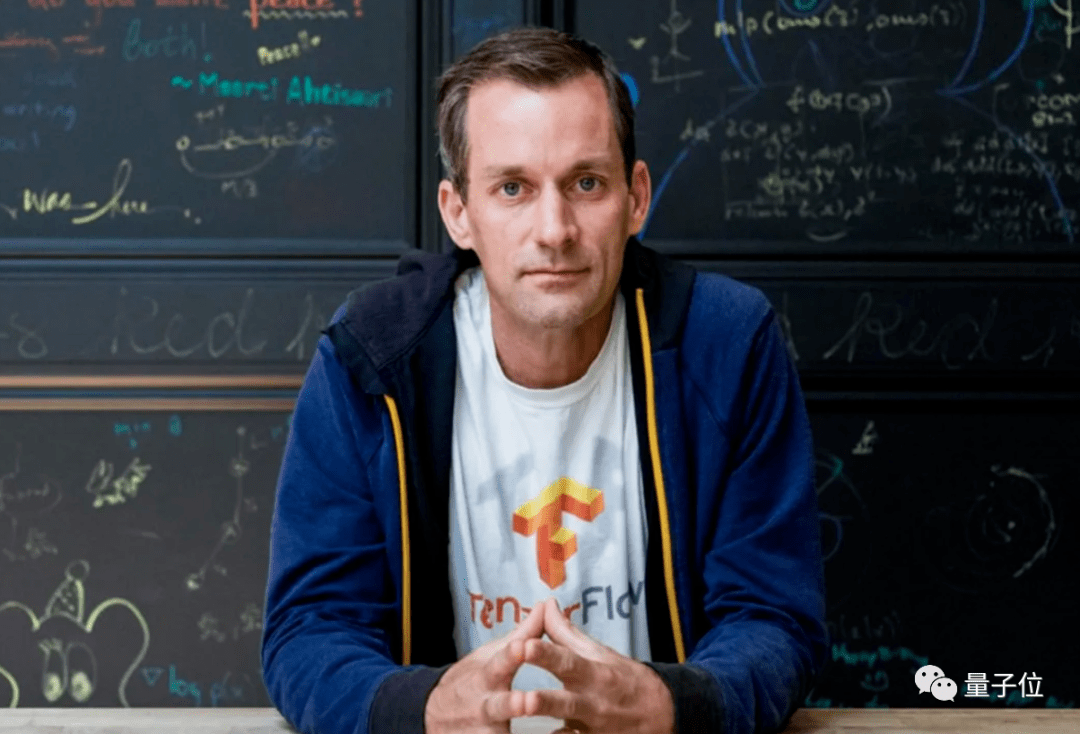

現在,Jeff Dean終於「有理有據」了——

他親自下場,對Gebru的論文進行了指正,表明她統計碳排放量和能源消耗的方法「 不合理」,並將結果寫成了一篇新的論文。

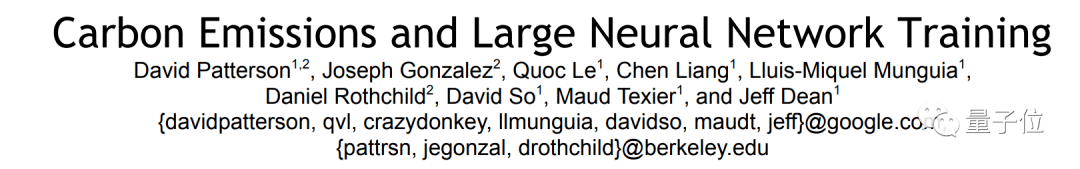

最近,Google聯合加州大學伯克利分校,撰寫了一篇新論文,仔細研究了AI模型對環境的影響,並得出結果表明:

AI模型,不會顯著增加碳排放。

AI模型,不會顯著增加碳排放。

論文指出,Gebru的論文對AI模型產生的碳排放量 估算不合理。

「如果數據中心、處理器和模型選擇得當,甚至能將碳排放量降低為原來的百分之一。」

「此前評估方法不嚴謹」

Jeff Dean的這篇論文,同樣選擇了NLP模型進行研究。

這項研究,將模型的碳排放量定義成 多變量函數, (每個變量都對結果有影響)這些變量包括:

算法選擇、實現算法的程序、運行程序所需的處理器數量、處理器的速度和功率、數據中心供電和冷卻的效率以及供能來源 (如可再生能源、天然氣或煤炭)。

算法選擇、實現算法的程序、運行程序所需的處理器數量、處理器的速度和功率、數據中心供電和冷卻的效率以及供能來源 (如可再生能源、天然氣或煤炭)。

也就是說,碳排放與 很多因素都有關係。

而此前的研究,對模型的評估方法有誤,尤其是對基於NAS的模型訓練方法理解有誤。

以基於NAS方法的Transformer為例,研究者們經過重新評估後,發現碳排放量可以降為原來的 八十八分之一。

研究者們還表示,採用新公式估計機器學習模型的碳排放量的話,淨排放量可以降低10倍。

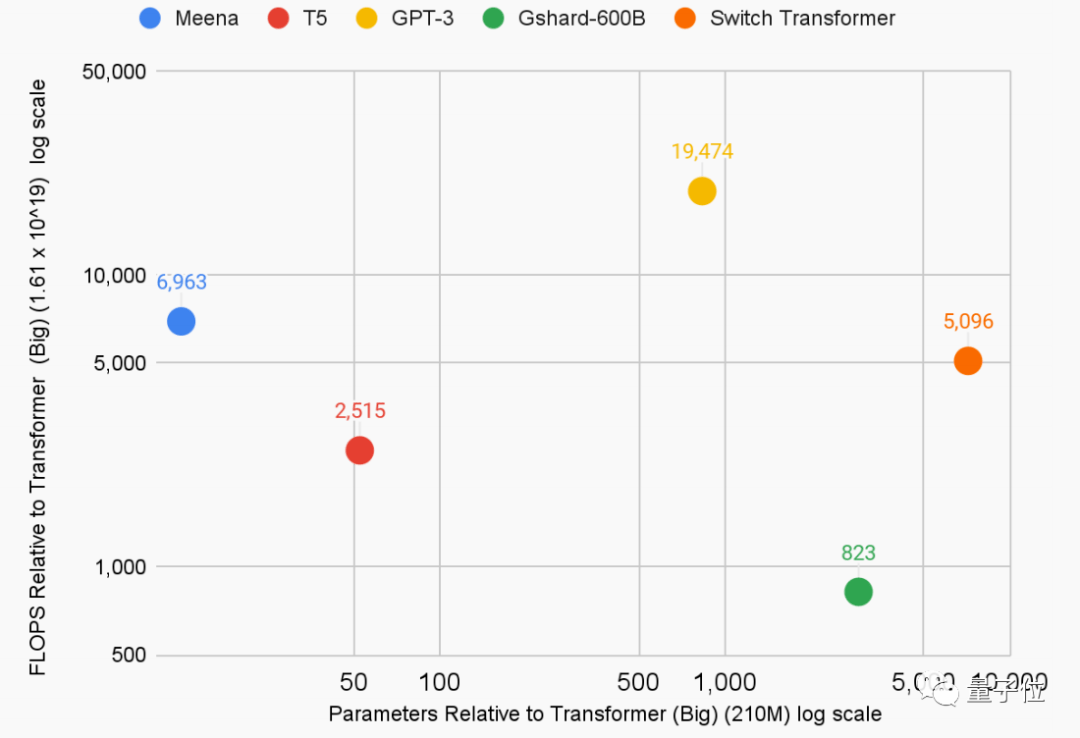

採用新公式,研究者們重新估計了5個大語言模型的能源使用量和二氧化碳排放量:

- T5,Google預訓練語言模型,86MW,47噸

- Meena,Google的26億參數對話機器人,232MW,96噸

- GShard,Google語言翻譯框架,24MW,4.3噸

- Switch Transformer,Google路由算法,179MW,59噸

- GPT-3,OpenAI大語言模型,1287MW,552噸

不過,即使Google的碳排放量,真是Jeff Dean這篇論文統計的結果,這些模型訓練導致的二氧化碳排放總量也已經超過200噸。

甚至OpenAI的一個 GPT-3模型,就已經達到了這個數值。

這相當於 43輛車、或是 24個家庭在一年內的碳排放量。

論文還表示,Google會繼續不斷提高模型質量、改進方法,來降低訓練對環境造成的影響。

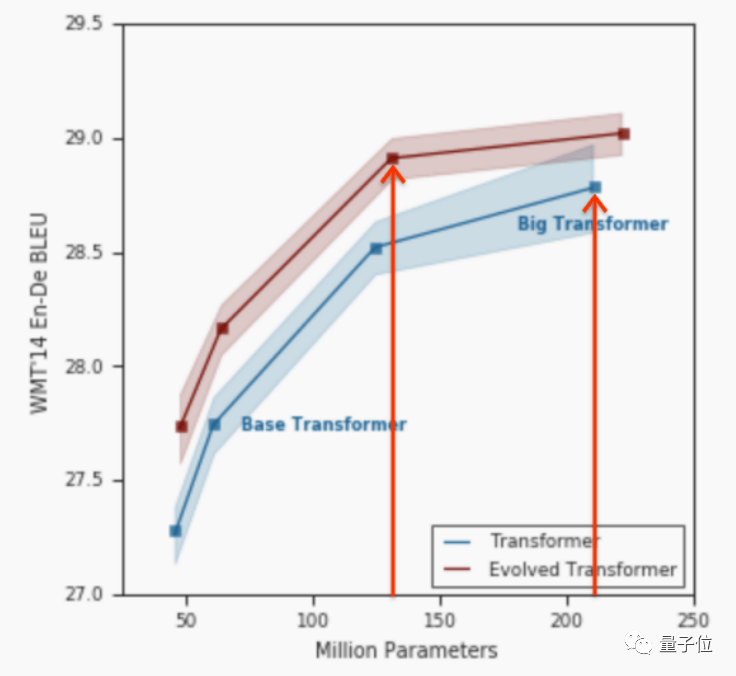

例如,Google對Transformer改進後的Evolved Transformer模型,每秒所用的浮點計算降低了 1.6倍,訓練時間也減少了1.1~1.3倍。

除此之外,稀疏激活 (讓資訊編碼中更多元素為0或趨近於0)也同樣能降低模型能耗,甚至最多能降低55倍的能源消耗、減少約130倍的淨碳排放量。

這篇論文,還引用了發表在 Science上的一篇論文:

即使算力已經被增加到原來的 550%,但全球數據中心的能源消耗僅比2010年增長了6%。

即使算力已經被增加到原來的 550%,但全球數據中心的能源消耗僅比2010年增長了6%。

論文最後給出的建議如下:

需要大量計算資源的機器學習模型,在實際應用中,應該明確「能源消耗」和「二氧化碳排放量」的具體數值,這兩者都應該成為評估模型的關鍵指標。

需要大量計算資源的機器學習模型,在實際應用中,應該明確「能源消耗」和「二氧化碳排放量」的具體數值,這兩者都應該成為評估模型的關鍵指標。

所以,Jeff Dean忽然參與到碳排放量研究中,到底是怎麼回事?

與Google利益相沖突

事實上,這篇論文是對此前Timnit Gebru合著的一篇論文的「指正」。

Gebru那篇論文的標題,名為「On the Dangers of Stochastic Parrots: Can Language Models Be Too Big?」 (隨機鸚鵡的危險:語言模型會太大嗎?)

論文提出,自然語言模型存在 「四大風險」:

- 環境和經濟成本巨大

- 海量數據與模型的不可解釋性

- 存在研究機會成本

- 語言AI可能欺騙人類

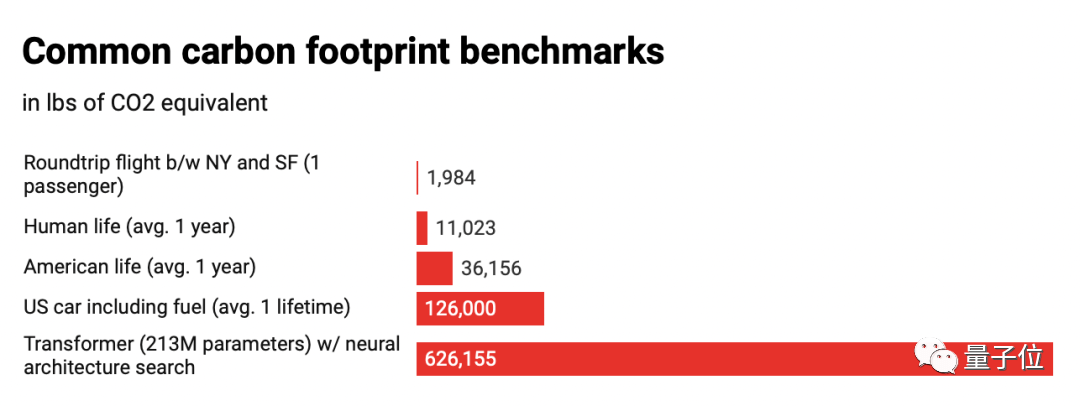

論文表明,使用神經網路結構搜索方法(NAS)的語言模型,會產生相當於 284噸的二氧化碳,相當於5輛汽車在其壽命內的碳排放量。

論文還以Google的NLP模型BERT為例,指出它會在AI倫理上會產生一系列負面影響:

它排放的1823磅二氧化碳量,相當於紐約到舊金山航班往返的碳排放量。

它排放的1823磅二氧化碳量,相當於紐約到舊金山航班往返的碳排放量。

這篇論文被認為顯然 不符合Google的商業利益。

Google此前開發過許多AI模型,包括雲翻譯和NLP語言對話模型等,而Google雲業務,還在2021年Q1收入增長了46%,達到 40.4億美元。

論文被送到Google相幹部門審核,但過了兩個月,卻一直沒有得到反饋。

2020年12月,Gebru忽然被 解雇。

Jeff Dean表示,Gebru的論文存在著一些 漏洞,隻提到了BERT,卻沒有考慮到後來的模型能提高效率、以及此前的研究已經解決了部分倫理問題。

而開除原因,則是因為「她要求提供這篇論文的審核人員名單,否則將離職。」

Jeff Dean表示,Google無法滿足她的要求。

這件事一直發酵到現在,Jeff Dean也正式給出了論文,「學術地」回應了這件事情。

和挖礦相比如何?

據Venturebeat報導,此前研究表明,用於訓練NLP和其他AI模型的計算機數量,在6年內增長了 30萬倍,比摩爾定律還要快。

MIT的一項研究人員認為,這表明深度學習正在接近它的「計算極限」。

不過,商業巨頭們也不是完全沒有行動。

OpenAI的前老板馬斯克,最近還懸賞了 1億美元,來開展碳清除技術比賽,比賽將持續到2025年。

這場主辦方是XPRIZE的比賽,鼓勵研究碳清除技術,來清除大氣和海洋中的二氧化碳,以對付全球氣候變暖的事實。

但這項技術,目前還 不具備商業可行性。

據路透社表示,光是去除一噸碳,就需要花費超過 300美元的成本,而全世界一年排放的溫室氣體,相當於約500億噸二氧化碳。

那麼,產生的這些碳排放量,和挖礦相比如何呢?

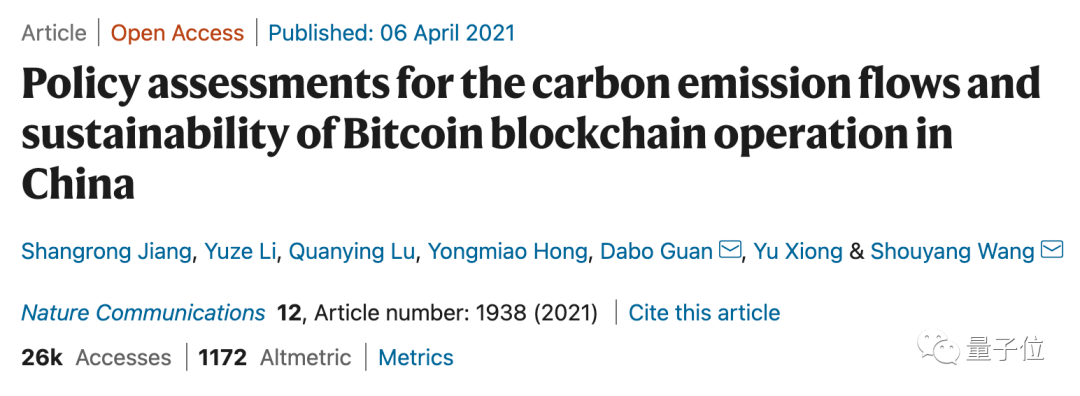

據Nature上的一項研究顯示,到2024年,中國的比特幣挖礦產業可能產生多達 1.305億噸的碳排放量,相當於全球每年飛行產生的碳排放量的14%。

具體到年份的話,到2024年,全球挖礦產生的能量將達到每年 350.11TWh(1太瓦時=10^9×千瓦時)。

而據Venturebeat的報導,訓練機器學習模型耗費的能量,每年估計也將達到 200TWh。

對比一下的話,一個美國家庭平均每年消耗的能量僅僅是0.00001TWh。

看來, 挖礦造成的環境污染,確實要比機器學習模型更嚴重……

論文地址:

https://arxiv.org/abs/2104.10350

— 完—

本文系網易新聞•網易號特色內容激勵計劃簽約帳號【量子位】原創內容,未經帳號授權,禁止隨意轉載。

加入AI社群,拓展你的AI行業人脈

量子位「AI社群」招募中!歡迎AI從業者、關註AI行業的小夥伴們掃碼加入,與 50000+名好友共同關註人工智慧 行業發展&技術進展:

量子位 QbitAI · 頭條號簽約作者

վ’ᴗ’ ի 追蹤AI技術和產品新動態

一鍵三連「分享」、「點讚」和「在看」

科技前沿進展日日相見~