尋夢新聞LINE@每日推播熱門推薦文章,趣聞不漏接❤️

人工智慧公司 OpenAI 在去年發布了 GTP-3 語言模型,這一模型可以說是顛覆了 AI 語言模型界的遊戲規則,它解決了許多有關大型語言模型的難題。

但是 GTP-3 還不是完美的。目前有關人工智慧人們最為擔憂的問題之一,就是 AI——尤其是聊天機器人和文檔生成工具等——由於不會辨別可能會不分黑白地對網路上的各種文檔進行學習,進而生產出錯誤的、惡意冒犯的、甚至是攻擊性的「有毒」語言輸出。

而像 GPT-3 這樣的大型語言模型是使用大量文檔進行訓練的,尤其是這些文檔大部分都是來自互聯網的,其中就包括了人類用文字可以表達的最好和最壞的內容,例如那些種族主義者和偏見主義者的激烈攻擊言語、甚至是謊言。

而最近,位於舊金山的 OpenAI 又宣布發表了 GTP-3 的更新版本——InstructGPT,更新之後的語言模型在訓練時能更好地聽從使用者的指示,也就是說使用者可以對模型按照自己的需求進行校準和微調,這樣用 InstructGTP 訓練得到的結果「毒性」也相應更少,並更加符合用戶的意願與需求。

OpenAI 目前已經將 IntructGPT 設置成了自己的應用程序編程接口 (API) 的默認模型——用戶可以通過此 KPI 付費享用這一最新的語言模型。同時用戶依然可以使用 GPT-3 模型,不過這已經不是 OpenAI 的最佳推薦。

而 OpenAI 負責校準團隊的共同領導者揚·萊克(Jan Leike)說,這是首次將人工智慧的校準技術應用於實際產品中。

OpenAI 公司在 InstructGTP 語言模型的校準和微調所使用的,是一種名為人類反饋強化學習技術,或者叫 RLHF (reinforcement learning from human feedback) 技術。

在 InstructGTP 模型的一個演示應用中,在用戶向 API 輸入了提示要求之後,模型給出了多個不同的輸出,這時用戶會將這些多個不同的輸出進行排名,接下來模型就會使用這些數據通過 RLHF 技術在 GTP-3 模型的基礎長進行校準與微調。就是通過這樣的方法,InstructGTP 模型可以得到對於用戶來說更安全、更有用且更符合自己想法的結果。

另外,在對 InstructGPT 的校準和微調進行訓練的過程中,OpenAI 公司還專門聘請了 40 人來對 GPT-3 得出的結果進行評估,在訓練中首先給 GTP-3 一些預先編寫好的任務,例如讓 AI 來「編寫一個以名為 Julius 的聰明青蛙為主人公的故事」,或者「為某個產品創作一個運用於facebook上的創意廣告」。

之後這 40 人的任務,就是對人工智慧給出的結果進行評估,他們覺得明顯更符合命題者意圖的結果,會得到更高的評判,也就是得到正反饋。而那些其中包含性或暴力語言、惡意毀謗性語言的結果,將會被標記。之後,這一反饋被用作強化學習算法中的獎勵。這一過程的主要目的就是為了訓練 InstructGPT 以對用戶友好的方式來匹配對提示的響應。

而最終這一訓練的努力也得到了回報,OpenAI 公司統計發現,其 API 用戶在超過 70% 的情況下更喜歡 InstructGPT 。

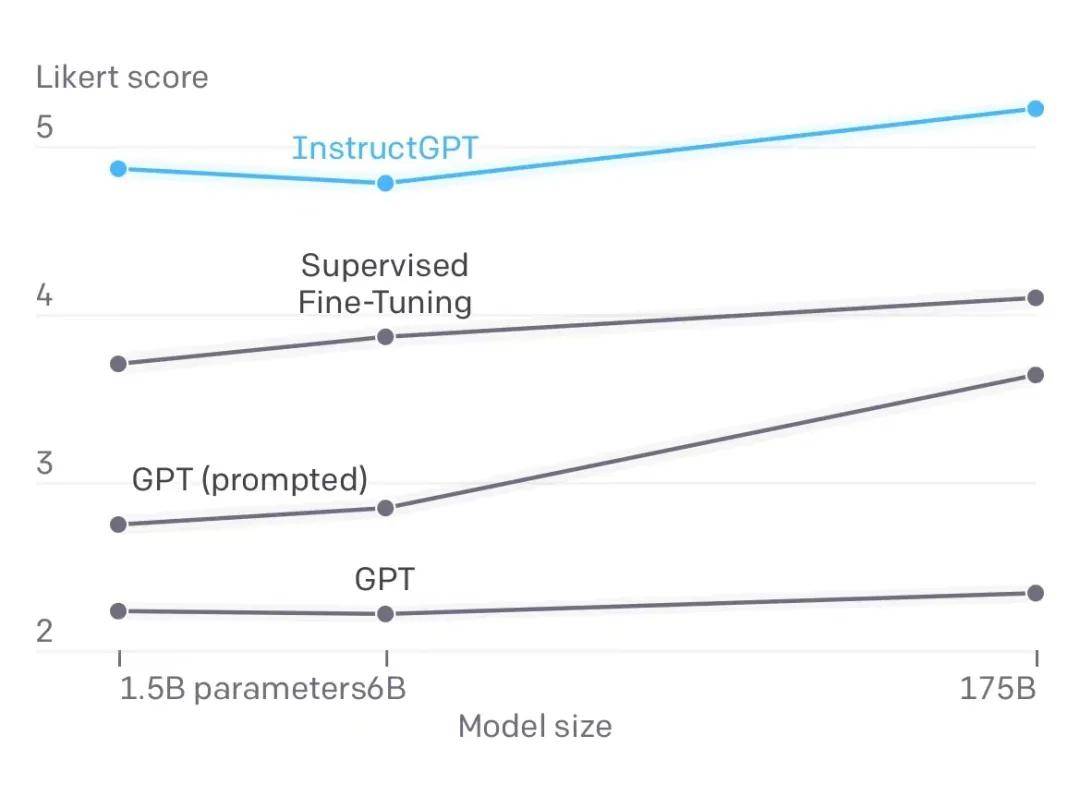

圖丨針對各種不行尺寸(x 軸)的不同模型輸出的質量評級(y 軸,最低為 1 級,最高為 7 級)(來源:OpenAI)

圖丨針對各種不行尺寸(x 軸)的不同模型輸出的質量評級(y 軸,最低為 1 級,最高為 7 級)(來源:OpenAI)

OpenAI 的客戶之一的 Yabble 公司的產品負責人本·羅(Ben Roe)也表示,通過 InstructGPT 生成的結果中的語法錯誤也幾乎消失,新模型的理解和遵循指示的能力也有了明顯的進步。據悉,Yabble 公司是一家使用 OpenAI 模型為其客戶的業務數據創建自然語言摘要的市場研究公司。

作為評估,研究人員還對比了不同參數大小的 InstructGPT 和 GPT-3 模型,結果發現並不一定是參數量越大的模型所得出的結果越符合用戶的心意。相比起 1750 億參數的 GPT-3 模型得出的結果,用戶卻更喜歡 13 億參數的 InstructGPT 模型的結果,盡管 InstructGPT 模型的參數量小了 100 多倍。這也意味著,除了不斷地增加參數量的大小,使用校準和微調可能也是一種優化語言模型的更簡單方法。

致力於開源語言模型的 AI 公司 Hugging Face 的研究員杜威·基拉(Douwe Kiela )也評價說,他認為 InstructGTP 是在正確的方向上邁出的重要一步。他還建議,可以將反饋驅動的訓練進行多輪的重復,從而進一步改進模型。而 OpenAI 公司的工程師也表示,將通過客戶的反饋來進行這一改進過程。

不過,盡管已經有了很大的提升與進步,InstructGPT 也不能說已經達到了完美。它仍然會犯一些簡單的錯誤,例如有時會產生一些毫不相幹或者沒有意義的響應,甚至還有著會被人類惡意利用的風險。

例如,有時如果給出的提示包含有虛假資訊,InstructGPT 會將這一虛假資訊視為真實。且由於它就是被訓練去做人類要求它做的事情,如果它得到的是不正當的指示,InstructGPT 甚至將會產生比 GPT-3 更惡劣有毒的語言。

-End-

參考:

https://openai.com/blog/instruction-following/

https://www.technologyreview.com/2022/01/27/1044398/new-gpt3-openai-chatbot-language-model-ai-toxic-misinformation/