生活中心/綜合報導

《魔法壞女巫:第二部》全球上映造成火熱話題,IP聯名商品英國木瓜霜品牌Dr.PAWPAW隨之爆紅,粉絲瘋狂追逐搶購(圖:擷取Dr.PAWPAW品牌IG)

《魔法壞女巫:第二部》全球上映造成火熱話題,IP聯名商品英國木瓜霜品牌Dr.PAWPAW隨之爆紅,粉絲瘋狂追逐搶購(圖:擷取Dr.PAWPAW品牌IG)你知道嗎?木瓜霜不只澳洲有,這款Dr.PAWPAW英國木瓜霜憑藉著與《魔法壞女巫:第二部》IP聯名合作,在國際間正火熱受到粉絲瘋狂追蹤中,英國木瓜霜台灣代理商婕曦實業表示:源自英國倫敦的Dr.PAWPAW品牌創辦人夫妻Johnny與Pauline Paterson為了幫女兒尋找一款天然、溫和且有效的潤膚產品,他們從木瓜(Papaya / Pawpaw)果實中發現卓越的修護與保濕力量,結合蘆薈與植物萃取成分,研發出首款明星產品Original Balm木瓜蘆薈奇肌霜(也是目前當紅的英國木瓜霜)開啟品牌之路;台灣目前已引進這款明星產品,上市不到二個月就創出百萬佳績。

作為全球推動永續的英國品牌Dr.PAWPAW所有包裝均採用:後消費回收塑料、70% 回收纖維紙板、水性環保油墨印刷,並致力於實現100%可回收設計;此外,品牌持續開發可生物分解材質的產品包裝,以實際行動減少碳足跡,並積極支持慈善與社會責任計畫,期望透過每一支產品,讓世界變得更美好。代理商婕曦指出:由於進口的關係,目前這款《魔法壞女巫》IP聯名款木瓜霜預計12月底才有機會來台,不少網友表示:雖然Dr.PAWPAW《魔法壞女巫》IP聯名款尚未引進台灣,但原本的明星商品-木瓜蘆薈奇肌霜,不僅可當護唇膏、萬用霜使用,還有「晚安唇膜、熱戀紅潤色霜、蜜桃亮采霜、乳木果修護霜」四款不同色彩系列都超好用的,這款英國木瓜霜可說是玩出了不同時尚色彩,滿足更多愛美者的護膚需求。

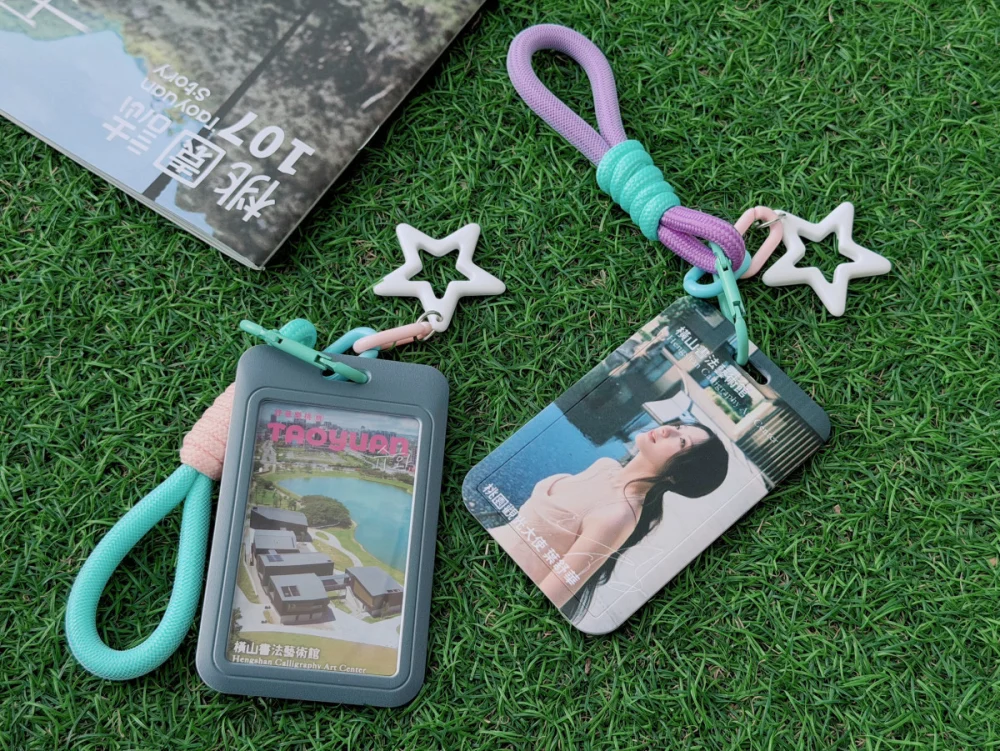

過去在台灣已經紅很久的澳洲「木瓜霜」,因用途廣泛,可當護唇膏、護手霜使用,長期累積許多好評,成為網路長賣款,而這款來勢洶洶又兼具國際品牌力的英國木瓜霜,代理商不僅一次引進五款經典木瓜霜在品牌官網與百貨通路銷售,更趁即將到來的「聖誕節」,推出Dr.PAWPAW柏靈頓熊IP聯名款-旅行典藏組、野餐點心組與甜點派對組,要搶攻聖誕part交換禮物商機。

Dr.PAWPAW英國木瓜霜 https://lihi3.me/2hRXD

Dr.PAWPAW柏靈頓熊IP聯名款 https://lihi3.me/Nc2RY

更多新聞推薦