尋夢新聞LINE@每日推播熱門推薦文章,趣聞不漏接❤️

作者 | 唐小引 & 孫浩峰

出品 | CSDN(ID:CSDNNews)

今時今日,當我們使用著微信的音視頻通話功能,在吃雞、狼人殺劇本殺裡語音對話、直播答題組隊,以及在各類在線教育的 App 網站與老師一對一或一對多地課堂互動,並習以為常之時,已經很難記起曾經那個普遍使用著 2G 把上網叫作「網上沖浪」的年代裡我們都是怎麼生活學習與工作的,那時候,上網的成本甚高,通話的質量卻低得今天回想起來都不敢置信。

盡管這樣的景象才過去十年有餘,卻如隔了半個世紀。

而如今,語音聊天、視頻社交,通過網路實時地與朋友家人乃至世界各地的人們互動都已經成為了我們的日常工作生活不可或缺的一部分,一如西北工業大學教授陳景東在 RTC 2018 實時互聯網大會的主題演講中所分享的,我們不僅做到了「通信+交互+控制+智能」,更有 Handsfree 和遠場交互。從前單通道的聲信號獲取已經發展至今天的高保真、多方及具有沉浸感的臨境體驗。這背後的一切均離不開 RTC 實時通信技術,而其所帶來的實時互動的能力,深入了從泛娛樂、教育、遠程醫療到政務、公安等各行各業,正如聲網 Agora 創始人 & CEO 趙斌在 RTC 2018 實時互聯網大會上所言 —— 「正在一點一滴地在線上創造一個新世界」。

聲網 Agora 創始人 & CEO 趙斌

實時互動技術應用已全面爆發!

在不久前,筆者與大家曾分享過從遊戲、直播到社交、教育這些社交需求極強的應用,以及微信開放了實時音視頻能力後所帶來的在小程序上的實時互動探索。而在正在舉行的 RTC 2018 實時互聯網大會上,筆者則看到了實時互動更加豐富的技術應用。

在大會現場,聲網 Agora 創始人 & CEO 趙斌為我們帶來了直播連麥、在線遊戲房、智能 AR 眼鏡、K12 家教一對一、視頻急救 120 等諸多已經成型並落地的應用。其中在直播方面,聲網專門推出了百萬人實時大頻道互動能力,從更高質量、更大規模、更低延時三個角度,做到線下巨型會議的線上化。從實際應用數據來看,實時大頻道互動中,98.5% 的參與者延遲在200ms以內,優質傳輸率為 97.3%。在演唱會、體育比賽、講座大課等超大型直播場景下,觀眾不僅能夠觀看直播,更可以把自己的現場反饋如歡呼、尖叫反饋給主播和其他觀眾,重現現場感受。

眾所周知,當前在國內的社交直播中,已經做到了動態實時濾鏡支持,通過實時追蹤人臉多個特徵點,做到實時動態貼紙、360°無死角美顏、自帶哈哈鏡和顏色濾鏡等功能。而聲網還在幫助海外的平台做到這些功能,譬如被稱為美國版「陌陌」的全美最大線上婚戀約會社交平台 MeetMe,即做到了互動直播,支持多人連麥互動,之後又陸續推出了人臉識別、臉部特效和虛擬禮物等動態功能。在大會現場,MeetMe 技術高級副總裁 Richard Friedman 分享了對於實時互動的見解:「實時視頻是人與人之間的通信交流,表情和肢體語言是很重要的一部分,以前依賴於文字聊天,很多東西其實都沒有傳輸出去。而有了 RTC 之後,這些部分能夠有效地被表現出來,從而更好地解決溝通的問題。並且區別從前的長延時直播,低延時互動直播拉近了主播與觀眾的距離,重新定義了盈利的模式,不止於傳統廣告,還有用戶打賞行為。而未來,實時互動將在生態系統上做到突破。」

MeetMe 技術高級副總裁 Richard Friedman

而智能 AR 眼鏡在國內外主流媒體都有過大幅報導,便是大陸警方已經正式採用智能眼鏡執法,只要戴上一副 AR 眼鏡,就能做到執法記錄、人臉識別、車牌識別、人證比對、實時語音指揮等功能。智能眼鏡在實時互動方面的應用除了這點,亮亮視野聯合創始人馬寅還分享了一個遠程醫療急救的例子,在卡達通過 5G 網路與遠程醫院專家進行溝通,在急救車上解決如何生產嬰兒、腦梗治療等問題。

此外,趙斌現場分享的一個視頻急救 120 的例子引起了諸多討論。聲網與重慶市聯合推出的傷急救視頻 120 自救互救服務,能夠讓傷者做到「一鍵求救」,醫生可通過視頻實時指導現場人員自救或互救。

趙斌表示,「這是對行業的一個穿透和改造。過去,打 120 只能在家裡等著救護車到,你與醫生之間的交流是非常有限的。通過這樣的方式,電話結束後通過發送簡訊裡的鏈接,打開手機瀏覽器,醫生即可知道病人發生了什麼,指導病人家屬做緊急處理。這個場景一旦成熟,將會改變行業的經營方式和模型。有些幸運的患者經過視頻指導後,甚至無須到醫院處理,這對緊急情況下病人的福祉有深度影響。」

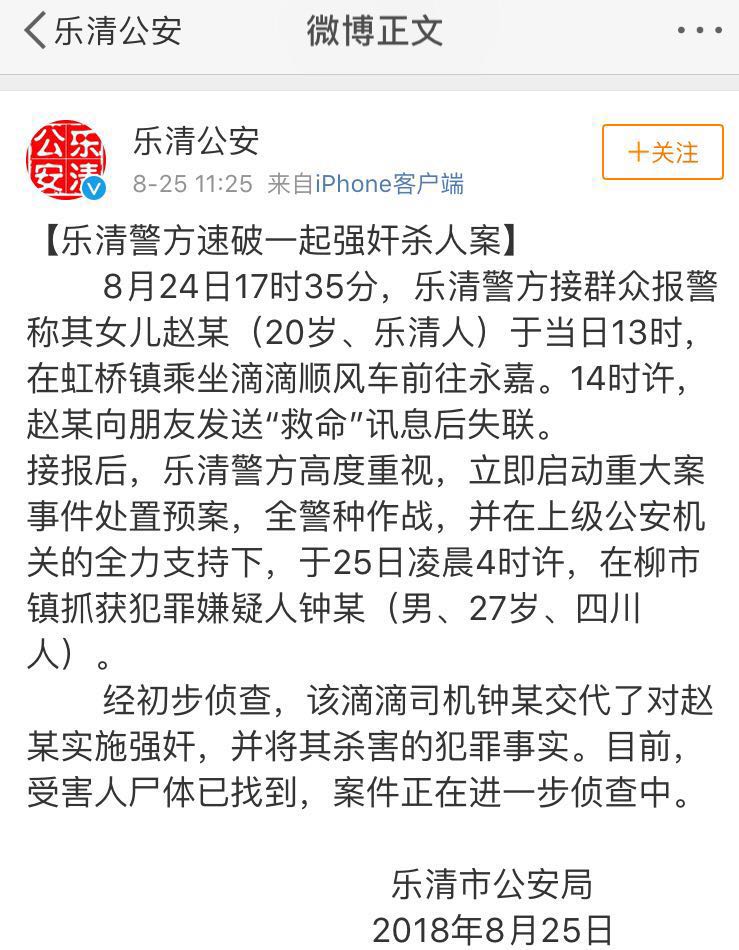

當筆者聞此時,不禁想起了讓人痛心的一再發生的滴滴順風車乘客遇害事件。在此之後,滴滴大力推廣通過添加緊急聯繫人夜間出行開啟自動行程分享來解決這一安全痛點,筆者在電梯中常常會見到,從一定程度上來講,應該是通過 Socket 長連接不斷發送地理位置。

順風車事件後,筆者便常見到滴滴開啟行程分享的廣告

那麼,我們是不是可以通過集成這樣的實時互動 SDK 服務,在滴滴中,只需一鍵操作,即可報警或求救,而對方可以實時地獲取行程路徑位置、車輛、司機等信息?當筆者就此疑問來請教趙斌時,他對此進行了肯定,不過要想在出行中做到這樣的安全保障還需要從行業的對接與努力。

這一切應用的背後,是標準制定與技術的迭代

去年 6 月,筆者在《蘋果終於入夥 WebRTC,新一代移動 Web 應用爆發路上還有哪些坑?》一文中曾為大家詳細解讀了 WebRTC(網路實時通信)這項技術的來龍去脈,彼時在聊到「蘋果 Safari 終於做到對於 WebRTC 的支持,究竟意味著什麼?」時,聲網創始人 & CEO 趙斌與我們分享道:「在 Safari 支持 WebRTC 後,過去只能在諸如 Chrome 瀏覽器之間做到的音視頻通話,現在在 Safari 以及 Chrome 與 Safari 之間做到了,其影響一定是積極的。可以預見,很多網站及開發者將會更加認真地考慮將這類功能添加至網站及應用中。」

在過去的一年裡,我們不僅看到了蘋果支持 WebRTC 所帶來的各種音視頻應用做到支持 WebRTC,並將瀏覽器作為音視頻應用的入口,還迎來了 WebRTC 1.0 的 Feature Complete。趙斌表示,「這是一個里程碑的事件,這是行業多少年來的發展和推動走到了今天的成果」。此外,在 RTC 領域,還有幾項重大技術事件的發生,包括 AV1 1.0 版定稿,蘋果加入 AOM 聯盟;AVS 2.0 音頻標準頒布,中國原創音視頻標準完成等。當筆者問到這些對於 RTC 意味著什麼,將帶來哪些改變時,趙斌如是說道:「WebRTC 的定稿意味著功能和能力上的最終固化,這勢必將帶來行業的標準統一,下一步是繁榮成長和互通互動能力的擴展。而新一代的視頻編碼是免費開源的能力開放,也會促進這個場景應用能力的延伸,就如同我們經營商每個月為開發者和創業者提供一萬分鐘的免費使用,給予他們非常大的自由度可以在沒有成本顧慮的環境下做創新。」

而一直以來「延時」是橫亙在通信面前的一大難題,筆者曾言過「現存的互聯網作為冷戰時代的產物最早其實是為了用於保障美國通信網路,其在網路傳輸方面的種種局限也直接導致了現在的互聯網在大文件傳輸、實時傳輸方面的窒礙難行。而語/視頻通信、直播連麥對實時性要求非常高,要求延遲低至幾百毫秒,因此,現存的互聯網並不能滿足這種新型的實時應用場景。」

也是因為這點,從 IM 到實時通信,一直都在致力於解決傳輸問題,而趙斌也表示,「在過去的一年裡聲網的研發團隊在持續改進和提高音視頻處理方面的能力,其 Agora Solo™ 編碼算法的升級版 Solo X™ 不僅能夠改造丟包對抗的能力,現在還做到了與 WebRTC 默認標準的 OPUS 編碼結合,幫助 OPUS 提高丟包對抗能力,且可以做到兼容互通。比如在瀏覽器上智能用標準的 OPUS,在客戶端可以用其他編碼算法,當這兩者互通時,是不是能夠平滑切換並繼續使用丟包對抗能力。」

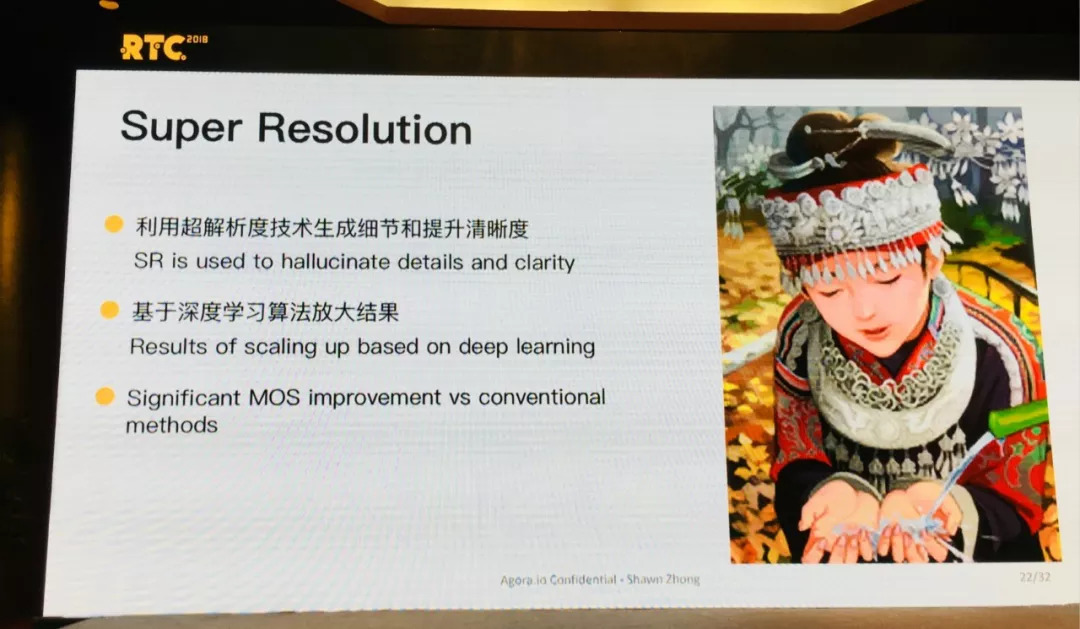

在大會現場,聲網 Agora 首席科學家鐘聲則更系統地為我們講解了從視頻編碼、網路和雲數據中心、視頻前/後處理以及深度學習等技術挑戰。譬如如何在低延時限制(比如 < 300ms)下有效對抗 70% 網路丟包率?又如何實時準確可能上下行網路的可用帶寬?如何及時發現、修復和預防影響用戶體驗的問題?如何標定相關數據,比如對視頻內容、用戶畫像的精確描述?如何有效提升圖像解析度和細節、修復圖像損傷?如何設計可以基於更小數據的小模型快速學習算法、推理決策能在移動端軟體實時運行等等。

基於這種種的挑戰,鐘聲分享了聲網技術團隊經過研究摸索實踐後的初步成果。在丟包率方面新算法對比傳統算法已經做到了在高丟包率和低延時下更具優勢,譬如在 4 幀延時、60% 丟包率的情況下做到了 21.36% 的碼率節省。而在諸如圖像、文件傳輸過程中由於低碼率或低分辨率而導致出現模糊情況,聲網研發團隊通過深度學習算法,讓細節和清晰度都做到了極大提升。

當 AI 與 RTC 深度融合、5G 商用落地,實時互動將走向何方?

鐘聲在現場提出了一個問題 —— 「今天的實時技術狀態猶如 20 年前互聯網 1.0 時期剛興起那般充滿了期待,那麼未來的 RTC 2.0、3.0 又將如何?」並基於此分享了一則數據 —— 「思科在 2017 年做過預測,互聯網流量從 2017 年到 2021 年將做到 4 倍增長,其中視頻流量將會持續增長到 87%。就細分領域來看,實時視頻會增長 15 倍,占視頻流量的 13%,也就是整個互聯網流量中超過 11%;在線遊戲增長 11 倍,占整體的 5%,VR/AR 將增長 20倍,由於現有基數較低,2021 將占全球流量的 1%,但隨著 5G 的到來,將會做到爆發式增長。」

而趙斌則是更系統性地為我們梳理了在實時互動方面的行業趨勢,主要分為三點:

- AI 和深度學習在 RTC 技術深度結合:由 AlphaGo 開始,我們已經看到了在圖像視頻識別、自然語言處理、語音識別等諸多領域,人工智能都已取得了重大的技術突破,同時也被應用到很多場景,在實時互動方面,AI 能夠為其在質量、體驗、功能上做出更新、更好的效果。

- 各國 5G 商用時間表落地,將催生更多 RTC 場景:5G 有著更大的帶寬,支持更多的 IoT 設備同時連接。未來的實時互動不僅僅只是發生在人與人之間,更有人與設備的連接、設備與設備的連接,這些互動都要依賴於更好的網路。而 5G 網路的出現和快速普及,會給予實時互動 RTC 領域更大的機會,帶來更普遍的實時場景滲透。

- 微軟、NVIDIA、Valve、Oculus、AMD 組成聯盟,推出 VirtualLink 接口標準:VirtualLink 的落地給行業帶來了新的機會。虛擬現實是行業都在關注的未來實時互動的一種全新的媒體和體驗形式,為行業帶來了新的高度。在過去一年多的時間裡,我們已經看到了 VR/AR 在實時互動行業的場景爆發。

「

征稿啦」